Method Article

都市公園環境における歩行の映像を自由に視聴する映像コンテンツの分析とアイトラッキングデータを組み合わせる

要約

プロトコルの目的は、実験室で使用するためのビデオデータを収集する方法を詳述することです。データを見ている参加者の目を追跡するデータと、機械学習の手法を使用して見ていたビデオのコンテンツを効率的に分析する方法を記録する方法。

要約

都市で生活する人が増えていく中で、日々の動きや収集できるデータを研究する方法が重要で価値あるものとなっています。アイトラッキング情報は、感情、健康状態、精神状態や行動の範囲に接続することが知られています。しかし、ビジョンは絶え間ない目の動きの結果であるため、雑音とは何かということから重要なことは、複雑でデータ集約的である。さらに、彼らに提示されたものと比較して人々が見るものを制御することも重要な課題です。

次に、自然で複雑なシーンのビデオのアイトラッキングを組み合わせて分析する方法と、ビデオのコンテンツを分析するための機械学習手法を示します。このプロトコルでは、撮影したビデオからのデータの分析、ビデオが参加者の視線データを記録するのに最もよく使用される方法、ビデオのコンテンツを分析してアイトラッキングデータと組み合わせる方法に重点をおいています。我々は、結果の簡潔な要約と、複雑な環境におけるさらなる研究のための方法の可能性についての議論を提示する。

概要

都市環境における私たちの日々の経験は、私たちの健康と幸福に大きく影響します。私たちの幸福は、私たちが見ることができる緑の空間の量に依存することができ、1,2,3, そして、これらのビューは、公園の設計についての意思決定を導くために、アイトラッキング機器を使用して定量化することができます.ただし、生成される視線追跡データの量と、このデータの意味に関する問題が発生します。ラボや自然環境で視線データを記録するための設備がより使いやすく、より強力になるにつれて、研究者は、意思決定の質問に役立つデータをどのように収集して分析できるかを検討する必要があります。

これまでのところ、多くのアイトラッキング研究では、調査や実験室の設定4で写真を使用してきました。この方法は、再現性と結果の制御の多くを可能にしながら, ビデオやウェアラブルモバイルアイトラッカーの使用を含むアイトラッキング技術の最新の進歩を活用することができません。.さらに、歩行とリラックスの行為は、特にウェイファインディング5のような仕事に向いているとき、必然的に動的であると主張します。したがって、これらの設定の完全に科学的な理解は、研究室の外で行われるべきです。しかし、現時点では、現実の自然環境でのアイトラッキングは、被験者間の経験を非常に困難なものと比較します。たとえば、ある回答者が樹木を他のものよりも見ているかどうかを比較する場合、自分の視点が他の人に比べて常に変化しているか、または頭が回転しているかどうかを制御する方法があります。これらの条件での詳細な解析は、現在の解析手法ではほぼ不可能です。私たちは、調査されている個人に利用可能な表示領域を制御することが重要であると主張し、分析では、任意の時点で見られている全体のシーンを考慮することができるようにします。

ストレスレベルと安全性の認識を景観ビューに結びつける一連の理論と、応力6,7のよく進化した尺度があります。視線8を測定するアイトラッキング装置の高度化も急速に進展している。目を追跡することは、不随意の目の動きがより確実に好み、ストレスや他の従来の測定よりも、アンケートや、唾液のコルチゾールなどの侵入性の生理学的検査よりも安全に接続される可能性があるため重要です。本研究の目的は、より自然な設定に適用される視線追跡データのより正確な測定を可能にするツールを開発することであり、これにより、公園の設計に情報を提供した長期にわたるランドスケープ理論を反論したり、数 十 年。

このプロジェクトの目的は、パークウォークのシミュレーションのさまざまなビデオに関連する視線追跡データを生成する新しい分析手法を開発し、テストすることです。ここと他の場所で報告された私たちの仕事は、完全にモバイルのアイトラッキングシステムの自然主義的な設定と上記で言及したラボベースの写真研究との中間点を表しています。特に、私たちは刺激材料としてビデオを使用することに集中し、この材料を使用してメルボルン市で異なる公園が生成する魅力の量をテストする方法を模索しています。私たちの仕事は、ビデオの詳細な分析がストレスからの回復を提供するために、公園の可能性の完全な、より自然な評価を行う前に、違反する必要があるステップであるという仮定に基づいています。

本研究では、都市公園を散策した映像を用いたデスクトップ・アイ・トラッカーを用いて、公園内をのんびりと散歩しているとの想像を求めた。我々は、参加者が異なるオブジェクトを見て、公園間で匹敵する時間を費やすことを可能にする方法を説明する。一般に、デスクトップスタディはモバイル ET の研究と比較して制御が容易で、各被験者の比較分析が可能です。

標準的なアイトラッキングソフトウェアでは、手動による対象領域ツールを使用して、オペレータが各シーンで目的のオブジェクトの周囲に手動で境界を描画することができます。これにより、参加者が異なるオブジェクトを見て自動的にカウントされるまでの時間を設定できます。ビデオデータの場合、このプロセスは労働集約的であり、オペレータの主観とエラーの対象となります。アイトラッキング解析ソフトウェアのそれ以降のバージョンでは、AOIs は、それらがビデオで同じサイズである場合、フレーム間でオブジェクトを自動的に追跡することができます。これは改善であるが、これは各画像の少数の刺激に対してのみ使用されることを意図しており、各画像は確認および確認されなければならない。

画像内のオブジェクトの手動ラベリングは一般的であり、GNU 画像操作プログラム (GIMP) などの画像編集ソフトウェアによってサポートされています。1 s が30フレームまたはイメージを生成することを考えると、ビデオの手動ラベリングは実用的ではありません。さらに、樹木の天蓋のような複雑なオブジェクトの端の周りに描画ベクトルポリゴンによる AOI ラベリングは非常に時間がかかります。最後に、ベクトルラベリングを使用してビューのフィールド内のオブジェクトのサイズを計算することは可能ですが、この機能は現在使用できません。

以下で報告する方法は、これらの制限を扱っています。本研究ではオブジェクトの自動ラベリングを採用した。これは、ビデオのすべてのフレーム内のすべてのピクセルにオブジェクトクラスを示すラベルが割り当てられる、セマンティックラベリングと呼ばれる画像処理手法を使用して可能です。機械学習は、対象のオブジェクトクラスごとにピクセル分類子を導出するために使用されます。これらの分類子は、各ピクセルに確率的なラベル (単項電位として知られている) を提供し、最終的なラベル出力を達成するために後続の最適化プロセスでリファインされます。これらの分類子は、テクスチャ、エッジの向きのヒストグラム、RGB カラー値、正規化された画像座標など、画像から抽出されたフィーチャの空間における各オブジェクトクラス間の統計的決定境界を学習します。このための適切な技術は、ダーウィン機械学習ツールボックス10に実装されており、以下に説明されています。

プロトコル

このプロジェクトの倫理的な承認は、オーストラリアのカトリック大学倫理委員会の承認番号 #201500036E によって与えられました。これにより、すべての参加者からインフォームドコンセントが得られ、参加者全員が自発的に参加し、参加者データは匿名かつ機密のままでした。さらに、承認は方法と設備オーストラリア規格安全規則を満たすために与えられました。

1. アイトラッキング研究で使えるアーバンシーンの撮影

- ジンバルに接続された高品質のデジタルビデオカメラを使用して、シミュレートした「ウォーキング」または「着席」ビデオを作成します。

- 25 fps で4k 解像度で滑らかな流体の動きでフィルムを記録し、1920 x 1080 HD でそれらを保存します。

- これに慣れていない、または機器へのアクセスが不足している場合は、プロの撮影会社を使用してデジタルフィルムを生成します。

- 正確に定義されたルートと特性を持つすべてのビデオ間で単一の長さに、1テイクでフィルムを撃ちます。

注: 例のビデオの詳細: シミュレートされた各ウォークフィルムは3分50秒であり、各模擬座っているフィルムは1分の長さでした。この調査のビデオでは、パスにつながる短い階段登りでビデオが開始されました。パスは正確に1分30秒の後に続いた後、カメラが停止し、45-60 度のために左にパンし、15秒間停止しました。カメラは3分 25 s マークまで歩行パスに沿って継続し、15秒間左に40-70 度、3分 50 s マークまでパスに沿って続け、その後黒にフェードしました。 - フィルムが同等であることを確認し、言い換えれば、彼らは異なる歩行軌跡やカメラの動きからの新しい視線データを導入していません。1つの映画は、合計2つずつ、各散歩の撮影された。

- 目の動きが音によって影響されるので、公園の外で突然の大きな騒音 (例えば、車の警報) からの中断なしでビデオの同じ長さのための歩くの1からの一般的な都市公園の音のファイルを記録しなさい。これは、両方のビデオの既存のサウンドトラックの代わりに再生できるため、ビデオの視覚的な影響を特定できます。

注: 車両やその他のオブジェクトが過度に移動すると、目の動きに影響を及ぼし、結果が歪むことがあります。この侵入の一部が発生した場合、フィルムは参加者に再生することができますが、フレームは分析から除外する必要があります。 - ウォーキングやベンチでの座りなど、さまざまなアクティビティに興味がある場合は、座って歩くシーンを個別のファイルとして保存または編集し、個別にテストします。

2. アイトラッキング機器のセットアップとデスクトップキャリブレーション

- 自然光が画面上の反射を避けるために除外することができる部屋の個人に撮影されたシーケンスを表示します。視野の外からの気晴らしを回避し、それによって視野の多くを占めるように、可能な限り大画面でそれらにそれを表示します。画面から約 60 cm 離れたワイドスクリーン (16:9) PC モニター (22 インチ) は、許容される標準です。

- アイトラッキングソフトウェアの作り付けの口径測定用具を使用して各参加者のためのスクリーンに口径測定を行いなさい。参加者に、画面の周りを動き回る赤いボールを見て、5つのキャリブレーションポイントで停止させる必要があります。

- キャリブレーションの間に参加者を観察し、彼らは同様に自分の頭を移動していないことを確認してください。それらが画面に近すぎて、画面が非常に大きい場合、これは問題になる可能性があります。それに応じて、画面からの距離を調整します。

- 各フィルムを編集して、ビデオの初期フレームの左上隅に白い十字を配置します。これは、ビデオ編集ソフトウェアを使用して行うことができます。この画面を3秒間表示してから、歩行を開始します。これは、アイトラッキングのキャリブレーションをチェックし、アイトラッキングデータの収集時間を個々のフレーム番号と一致させることができるようにするためです。

3. 採用・倫理

- 学生やスタッフの体の中からサンプルやリクルートの中で異なる性別、年齢や職業の広がりを確保するために、プロの研究採用会社を使用してください。

- 既知の眼または神経学的状態および/または傷害のための参加者のスクリーニング。彼らは目の動きに影響を与えることが知られている薬を服用しているかどうかを尋ねられる必要があります (例えば、ベンゾジアゼピン系).

- 近くの視力検査とペントーチ眼球運動の遠足のテストを行い、彼らは完全な目の動きの遠足を持っていることを実証します。

- 参加者の年齢、性別、公園利用頻度について調査します。

4. 参加者実験のセットアップ

- 参加者に, 自分が回復を必要としていることを想像してもらいます。次のような目を追跡するビデオの文脈を想像することができる文を使用してください: 「それは正午であり、あなたはメルボルンで一人で歩いていることを想像してみてください。あなたは職場での強烈な集中から精神的に疲れているし、散歩に行くためにどこかに座ると、座って、少しの間、仕事に戻る前に休息するために探しています。

- コンピュータの画面の前で、参加者には 60 ~ 65 cm の距離で快適に座って映画を見ることができます。

- スプレッドシートプログラムを使用して、参加者の前で再生する前に、ランダムにフィルムを注文します。

- スピーカーを使用して、すべての映画に同じオーディオを再生します。

- デスクトップのアイトラッキングシステムを使用して、参加者の視線軌跡を記録します。製造元の指示に従って、デスクトップの目を追跡するデバイスをマウントします。これは、テーブルの画面のすぐ下にあるか、画面の端にクリップすることができます (たとえば、上にあります)。

- 120 Hz のサンプリングレートと0.50 °の精度を持つアイトラッキングユニットを使用して、頭部の動きの自由度を大幅に向上させることで、自然な頭部の動きによる記録を可能にします。低周波のアイトラッカーも許容されます。57.3 cm では、1°の視覚角度は、画面上で約 1 cm に相当します。

- 参加者がモニター上のフッテージを高解像度で視聴できるようにします。

- アイトラッキングソフトウェアを使用して目の動きを記録する

- 固定フィルタを使用して、未加工の目のサンプルデータを解析用に変換します。メインメニューで [ツール > の設定] をクリックします。[固定フィルタ] タブを選択します。生のアイトラッキングデータを凝視点に集約するための最良のフィルタタイプに基づいて、メーカーの仕様に従って固定フィルタを選択します。

- 複数のフィルムを使用してアイトラッキングデータを記録する場合は、参加者がリクエストするたびにレコーディングセッション間で休憩を与えます。

5. 視聴した公園を動画の感想につなげる

- 参加者に、各公園の評価を 1 ~ 10 の尺度で行うように求めることによって、オブジェクトの表示範囲と動画の意見を比較し、まず、その環境で休息して回復できると感じたかどうかを確認します (1、10、非常に多くの)、第二に、彼らは公園を好きだった (1、非常に多く、10、非常に多く)。

- 参加者に、公園をリラックスまたはストレス解消するために使用するかどうか (Y/N)、公園との事前の関連付けの潜在的な影響を制御するために、彼らが見ていた公園 (Y/N) を認識しているかどうかを尋ねます。

- 参加者からの短い回答の回答を録音して、ボイスレコーダーを使用して感想を説明した後、これらを書き起こします。

6. 関心領域抽出のための自動ビデオ分析

- AOIs の選択

- そのような木、低木、標識、建物、芝生、パス、ステップなどのように、公園のデザイナー、都市のデザイナー、プランナーや建築家のために興味のあるアイテムを選択してください。

- 最適なパフォーマンスと最小限のトレーニング要件 (以下で詳しく説明します) のために、互いに視覚的に区別しやすい要素を肉眼で使用したり、各ビデオフレームの異なる領域を一貫して占有したりします。一般に、各 AOI の視覚的な区別の違いを示す十分なトレーニング例は、堅牢なパフォーマンスのために十分である必要があります。

- AOI 抽出のためのトレーニング分類子

- 使用するトレーニングフレームの選択、数および根拠

- 適切な数のトレーニングフレームを選択します (これ以降はトレーニングセットと呼ばれます)。適切な固定数はありません。

注: フレームは、ビデオ全体にわたって、各オブジェクトクラス (つまり、ラベル付けされるオブジェクト) の視覚的な表示範囲を十分にカバーする必要があります。例えば、1つのパークランドシーンを描いた15000フレームのビデオシーケンスの40フレームが、十分な精度を達成することが判明しました。シーケンスに大きなばらつきがある場合は、より多くのフレームが必要になることがあります。 - トレーニングフレームを選択するときは、フレームコンテンツを検討します。これには、照明、分類されているものに関する図形 (たとえば、木の種類だけではなく、木の種類の範囲、画像内の位置、明るさなど)、テクスチャ、および色が含まれます。

- 含めるフレームの数も考慮してください。具体的には、分析対象のビデオ全体にわたって表示される視覚状態の長さとバリエーション、および識別するオブジェクトクラスの数、およびその出現頻度です。

- 適切な数のトレーニングフレームを選択します (これ以降はトレーニングセットと呼ばれます)。適切な固定数はありません。

- トレーニングフレームのための手動ピクセルラベリング

注: 手動でトレーニングフレームをラベル付けすると、対象のオブジェクトクラスにピクセルが関連付けられます。- トレーニングフレームのピクセルラベル

- さらに、画像編集ソフトウェアのビデオから各トレーニングフレームを開きます。

- ビデオからの各トレーニングフレームについて、読み込んだ画像に透明な画像レイヤーをオーバーレイしてラベルを付け、カラーパレットを作成して、対象のオブジェクトクラス (AOIなど) ごとに1つの色を提供します。

- ラベル付けプロセス全体を通じて、カラーパレットとオブジェクトクラスへの色のマッピングが同じであることを確認します。

- サンプル AOI の色を選択します。

- サンプル AOIs のカラー領域を選択すると、マウスをクリックしてドラッグすると、適切なパレットの選択を使用して、領域内のピクセルが「色」になります。

注: 大きなオブジェクトを不正確に色付けすることができます。ただし、数ピクセルの幅が狭い/小さいオブジェクトの場合は、手動でラベルを正確に表示するように注意してください。 - フレームのラベリングが完了したら、オーバーレイされたレイヤーを別のイメージファイルとして書き出します。基本ファイル名が元のフレームベースファイル名と一致しているが、末尾に "c" が付加されていることを確認します。たとえば、元のフレームのファイル名が "1234. png" の場合、ラベルの付いたレイヤーファイル名は "1234c" にする必要があります。

- すべてのラベル付きイメージが1つのフォルダーに格納されていることを確認します。

-

検証フレームのピクセルラベル

注: トレーニング済み分類子の精度を定量的に検証するには、ラベル付きフレームの追加セットを作成する必要があります。- トレーニングセットに含まれるように、まだ選択されていない元のビデオシーケンスからフレームを選択します。5分間のビデオでは、これらは20フレーム以上である必要はありませんが、十分なカバレッジを確保するために、ビデオシーケンス全体から均一にサンプリングしなければなりません。

- トレーニングフレームの準備 (6.2.2) について概説されている手順を使用して、各フレームのピクセルにラベルを付けます。しかし、この時間は、これがグランドトゥルースの比較として使用されるので、可能な限り正確で包括的であるとラベリングされます。

- フレームのラベル付けが完了したら、トレーニングと同じ命名規則を使用しますが、ファイルは個別の検証フレームフォルダに保存するようにしてください。

- トレーニングフレームのピクセルラベル

- ビデオシーケンスの自動ピクセルラベル

- Http://drwn.anu.edu.au からダーウィンソフトウェアライブラリをダウンロードしてください。

注: このホワイトペーパーに記載されているシステムは Linux 環境内で実装したものであるため、ダーウィンの Linux リリースは、web サイトからの指示に従ってダウンロードしてインストールする必要があります。 - ダーウィン GUI を起動する

- ダーウィンの GUI で、「トレーニング・ラベルのロード」をクリックします。

- 表示された [ファイルエクスプローラ] ダイアログボックスを使用して、関連するビデオシーケンスのラベル付きトレーニングイメージを含むフォルダを選択します。

- ビデオフレームをロードするをクリックし、ビデオシーケンスのすべての元のフレームを含むフォルダを選択する6.2.3.2 と同じ手順に従ってください。これは、各フレームのファイル名がビデオシーケンス内のそのフレームの番号であるイメージのフォルダーである必要があります (たとえば、フレーム1234は 1234. png という名前になります)。

- 列車のボタンをクリックします。このアルゴリズムでは、ラベル付けされた各トレーニングフレームを検証し、対象の指定したオブジェクトクラスのいずれかにピクセルを分類するための外観のモデルを学習します。

- Http://drwn.anu.edu.au からダーウィンソフトウェアライブラリをダウンロードしてください。

- トレーニング済み分類子の検証

- トレーニングが完了したら、[トレーニングを検証] ボタンをクリックします。

- [ファイルエクスプローラ] ダイアログボックスを使用して、関連するビデオシーケンスのすべてのラベル付き検証イメージを含むフォルダを選択します。トレーニング済みの分類子は、検証セットで参照される各フレームのピクセルを分類するために使用されるようになりました。これを、検証フォルダーに用意されているグラウンドトゥルースラベルと比較します。

注: この GUI では、検証セット内の各フレームに対して正しくラベル付けされたピクセルの割合や、検証セット全体について、精度の統計情報を表示します。 - 生成されたラベルを視覚的に検証するには、[ビジュアル検証] ボタンをクリックします。クリックすると、生成されたラベルの付いた各イメージが、元の検証フレームの横に表示されます。

注: これは、オブジェクトの分類がどこで発生しているかを特定するのに役立つ可能性があります。たとえば、目視検査は、オブジェクトクラスの特定の部分でエラーが一貫して発生していることを示している可能性があり、トレーニングセットでのラベリングの改善が必要であることが示唆されます。あるいは、検査は、ビデオ中の特定の時点においてのみエラーが発生することを示してもよく、ビデオ中のその期間からより多くのトレーニング例が必要であることを示唆している。 - 定量的または定性的な検証で観察される精度が許容レベルを下回っている場合は、さらにトレーニング例を含めます。この場合、追加のトレーニングフレームを含めるために6.2.2 からすべての手順を繰り返し、6.2.3 の次の手順に従って分類子を再トレーニングし、6.2.4 の次の手順を再検証します。

- ビデオピクセルラベリング

- 分類子のトレーニングと検証のフェーズが完了したら、ダーウィンの GUI 上のラベルフレームをクリックして、トレーニング済みの分類器を使用して、ビデオシーケンス内のすべてのフレームの完全なラベリングを開始します。

- プロンプトに従って、トレーニングで使用したのと同じカラーパレットを使用してラベル付けされたイメージの形式になるすべての出力フレームの宛先フォルダを選択します。

- 使用するトレーニングフレームの選択、数および根拠

7. アイトラッキングデータを動画コンテンツに登録する

- アイトラッキングソフトウェアでファイル ≫ エクスポートをクリック...アイトラッキングファイルを CSV ファイルとしてエクスポートします。

- スプレッドシートプログラムでファイルを開きます。

- ビデオシーケンスからフレームの左上の白い十字 (2.3 参照) が消える時間を識別します。この時間を使用して、視線追跡の結果に関連する列を使用して、視線を識別します。これは、目を追跡するデータ収集の開始点です。

- 目のトラッキングデータに列を追加します。

- この新しい列には、各行または目のトラッキングデータポイントに、番号1から始まるフレーム番号が付けて使用されます。

8. 参加者がビデオ内のさまざまなクラスのオブジェクトを調べた時間の表示

注意: 目を追跡するデータの巨大なサイズのために、Python のプログラミング言語は、データ処理プログラムも使用することができますが、8.4 へのステップのために使用する方が良いです。

- 含まれている Python コードを使用して、対象のオブジェクトと目のトラッキングの固定時間と周波数のオーバーラップ量を計算します。

- このデータを合計して、参加者が異なるオブジェクトを見て費やした時間を把握します。

- ヒストグラムを使用して、オブジェクトが画面を占有した合計時間を表示します。

- 参加者がさまざまなオブジェクトを見た合計時間と比較します。

- アイトラッキングソフトウェアでヒートマップを作成するには、チェックボックスを使用して、パークウォークの動画のいずれかをクリックします。

- [ヒートマップ] タブをクリックします。

- 「カウント」 (時間枠で作成された凝視点の合計数)、「絶対継続時間」 (固定期間の累積)、および「相対継続時間」の変数を使用して、必要に応じてヒートマップのカラーおよびその他の機能を調整します (オブジェクトをシーンを見て過ごす時間で割った値)。

- ヒートマップを含むイメージまたはビデオを、JPEG ファイルまたはビデオファイルとして書き出します。

結果

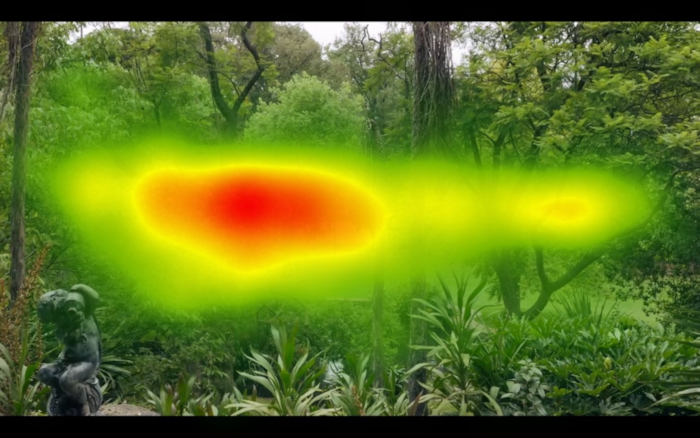

図 1と図 2は、すべての参加者のビデオ全体のすべての目のトラッキングデータを取得し、ヒートマップを作成した結果を示しています。これは、アイトラッキングソフトウェアパッケージで利用できる標準的なアプローチです。図1と図 2を比較することにより、図1のビデオの x 座標上で平均的な参加者が左右に走査した図2に比べて、丸い形を示していることが確認できる。図1では、図2の公園と比較して、ビデオ全体で水平方向の要素が増えています。ヒートマップの背後にあるイメージは単一のフレームであり、ビデオの完全な内容を適切に表現していません。

デスクトップアイトラッキングシステムとソフトウェアは、両方の目を同時に配置できる結果のみをカウントします。つまり、片方または両方の目が見つからない場合、データは失われたものとしてカウントされる。我々のケースでは、アイトラッキングデータは、時間の 80% > のために捕獲されました。

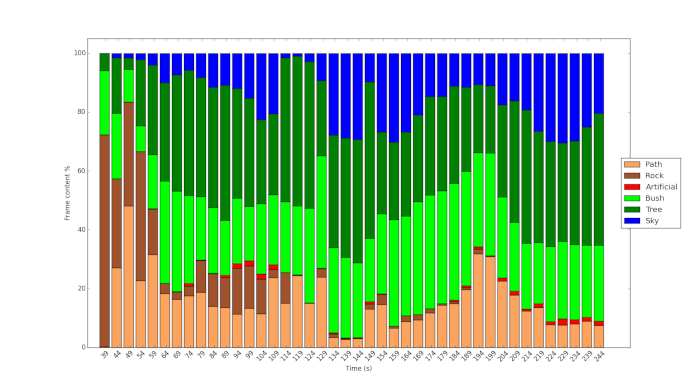

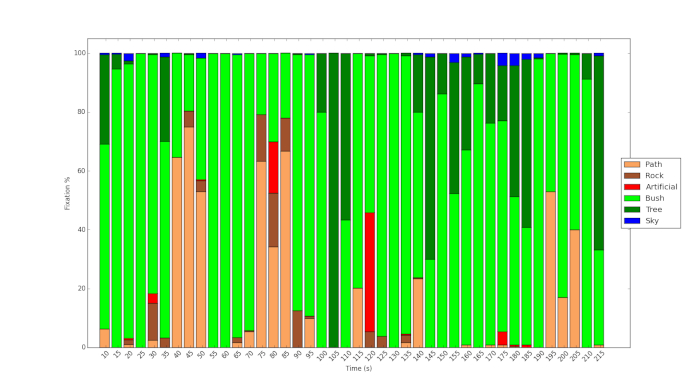

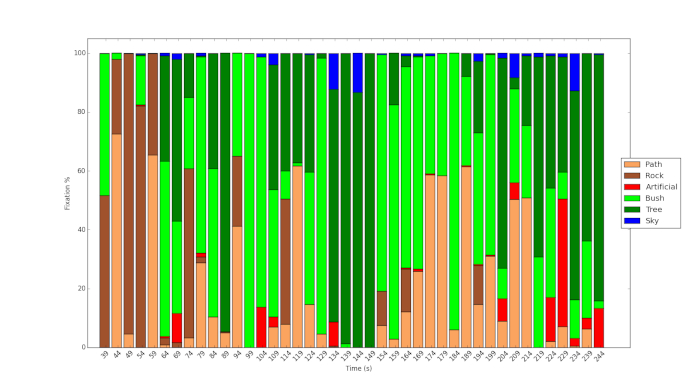

図 3と図 4は、ビデオの内容を分析するためのプロトコルと機械学習の使用の結果を示しています。図 3は、ロイヤルパークの比較的まばらな植生に比べて、フィッツロイ庭園の密集した植生を示しています (図 4)。後者では、より多くの空が見える、より多くのシーンは低木の植生によって支配されています。図 5は、参加者の1人のビデオの経過中の異なるオブジェクトに対する% 固定時間を示しています。これは、ビデオの進行中にパスがはっきりと見えても、参加者はこの機能だけをときどき重要な点で見ることができることを示しています。同様に、図 6に示すように、ロイヤルパークのビデオのコンテンツのごく一部は人工物に関連していますが、研究の参加者はこれらの特徴を比較的大きな範囲で調べています。

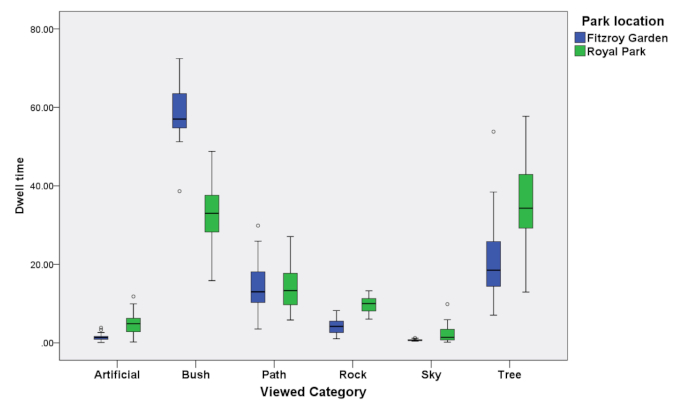

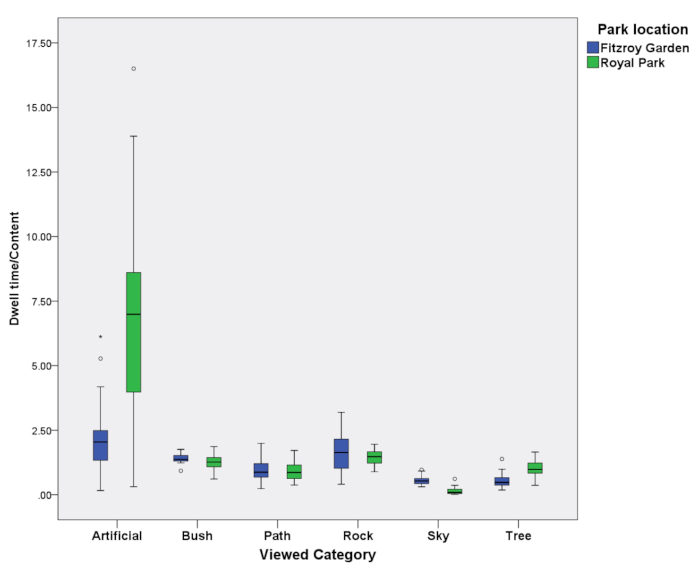

図3、図 4、図 5、および図 6の結果は、この調査でデータが使用されたすべての39参加者の図7と図8にまとめられています。図 7は、ビデオの長さ全体にわたってオブジェクトを見るときのすべての参加者の滞留時間を示しています。図 8は、この同じデータを、これらのさまざまなオブジェクトがビデオで占めていた時間と空間の量で割ったものを示しています。値を1に設定すると、ビデオ内のオブジェクトの量によってドウェル時間を計上できることを示します。図 7は、街灯やベンチなどの人工的なオブジェクトを、他のオブジェクト (> 1) と比較して大きな範囲にわたっていることを示しています。図 7は、両方の画像の空など、あまり関係のないオブジェクトが比較的少ない値 (< 1) で表示されていることも示しています。

図 1: 公園の1つのビデオ全体に対して生成されるヒートマップの例。これは、アイトラックの大半が位置していた場所を示しています。ビデオ内の水平方向の要素が優勢であるため、ヒートマップの水平方向の形状に注意してください。この図の大規模なバージョンを表示するには、ここをクリックしてください。

図 2: 公園の別の1つのビデオ全体に対して生成されるヒートマップの例ビデオに垂直および水平の要素が存在するため、より丸みのある形状に注意してください。この図の大規模なバージョンを表示するには、ここをクリックしてください。

図 3: フィッツロイ庭園のビデオのコンテンツのヒストグラムは、機械学習技術を使用して分析しました。この図の大規模なバージョンを表示するには、ここをクリックしてください。

図 4: 機械学習技術を用いて分析した王立公園の映像におけるコンテンツのヒストグラム。この図の大規模なバージョンを表示するには、ここをクリックしてください。

図 5: フィッツロイ庭園内のオブジェクトを見て過ごすアイトラッキング固定時間。この図の大規模なバージョンを表示するには、ここをクリックしてください。

図 6: ロイヤルパークのオブジェクトを見て過ごすアイトラッキング固定時間。この図の大規模なバージョンを表示するには、ここをクリックしてください。

図 7: 両方の公園のすべての参加者とオブジェクトの目を追跡する集約時間。この図の大規模なバージョンを表示するには、ここをクリックしてください。

図 8: 集約されたアイトラッキング両方の公園のすべての参加者とオブジェクトのコンテンツに対する滞留時間。この図の大規模なバージョンを表示するには、ここをクリックしてください。

ディスカッション

一般的に、アイトラッキングデータを解析するための標準的なソフトウェアパッケージでは、ベクトル AOI が使用されます。1つの静止画像でも、ベクトルのサイズを簡単に測定することはできません。さらに、画像中の全ての AOIs を含む、AOIs の相対量を計算することは面倒である。説明したような機械学習の手法を使用せずに、ビデオに手動でこれを行うことはほとんど不可能です。これは、自由な表示状況を推測する比較的単純なステートメントでした。はるかに正確なシナリオを使用することができ、同じ刺激の前に異なるシナリオの説明は、眼球の動き11にも影響を与えることができます。

本研究では、映像中の物体を正確に分類し、目に見える範囲を解析する手法を用いた。この方法は、視線の動きが目的のオブジェクトにリンクされている範囲を表す1つの計算方法を表します。これにより、対象となるオブジェクトが、異なる被験者からの視線追跡をモバイルアイトラッキングデバイスと比較する際に、またはデスクトップベースのシステムを使用している場合に異なる場所で制御される視野内に存在する範囲を可能にする。機械学習を使用してオブジェクトの自動分類に影響を与える考慮すべきことは、分類されているものに関して照明、形状 (例えば、木の種類だけではなく、樹木の種類の範囲であり、その位置イメージ、それらが照らされる方法など)、テクスチャ、および色。フレーム数の考慮事項には、分析対象のビデオ全体にわたって表示される視覚状態の長さと変化、および識別するオブジェクトクラスの数とその出現頻度が含まれます。フレームは1/25 秒ごとに変更されますが、ソフトウェアによるアイトラッキングは 1/120 (120 Hz) で発生します。このため、アイトラッキングデータは、新しいフレームが表示されるレートの4.8 倍で収集されます。完全に正確にラベルを付けることはできませんが、フレームのラベリングは5回ごとに変更する必要があります。たとえば、99 ~ 101 s の間の視線追跡データは、ビデオの100秒のフレームで考慮されています。

現在のアイトラッキングパッケージの大きな利点は、ユーザーが自分の目を追跡する凝視点と経路のフィルムをレビューし、特定のオブジェクトを見た理由を説明できるように設定されていることです。これにより、個々の被験者が特定のオブジェクトを見たと思う理由を明らかにする定性的なデータセットが得られます。プロジェクトの拡張では、図 8の情報など、コンテンツに対してさまざまなタイミングでオブジェクトを参照するために費やされた時間も表示されます。しかし、シーン内のオブジェクト数を制御することによって、これを行うことは、現在は不可能です。

例えば、参加者は、記録された自分の視線の軌跡を見て、なぜ彼らが特定のオブジェクト12を見たのかを説明するよう求められる。我々のケースでは、各映画参加者の終わりに1-10 のスケールで各公園を評価するように求められ、まず、その環境で休息して回復することができると感じたかどうか (1、あまり、10、非常に多く)、そして第二に彼らはどれくらい好きだったか公園 (1、あまりにも多く、10、非常に多く)。

開示事項

なし

謝辞

この作業は、メルボルン市と部分的にアーク DP 150103135 によって財政的にサポートされました。私たちは彼のアドバイスと協調的なアプローチのための Eamonn Fennessy に感謝したいと思います。研究助手イザベル Janecki とイーサン・チェンにも特別な感謝を込めて、このデータの収集と分析を支援しました。すべてのエラーは作者のままです。

資料

| Name | Company | Catalog Number | Comments |

| 12 mm lens | Olympus | Lens | |

| Panasonic GH4 | Panasonic | Video Camera | |

| Tobii Studio version (2.1.14) | Tobii | Software | |

| Tobii x120 desktop eye-tracker | Tobii | Eye-tracker |

参考文献

- Patrik, P., Stigsdotter, U. K. The relation between perceived sensory dimensions of urban green space and stress restoration. Landscape and Urban Planning. 94 (3-4), 264-275 (2010).

- Bjørn, G., Patil, G. G. Biophilia: does visual contact with nature impact on health and well-being?. International Journal of Environmental Research and Public Health. 6 (9), 2332-2343 (2009).

- Velarde, M. a. D., Fry, G., Tveit, M. Health effects of viewing landscapes-Landscape types in environmental psychology. Urban Forestry & Urban Greening. 6 (4), 199-212 (2007).

- Polat, A. T., Ahmet, A. Relationships between the visual preferences of urban recreation area users and various landscape design elements. Urban Forestry & Urban Greening. 14 (3), 573-582 (2015).

- Peter, P., Giannopoulos, I., Raubal, M. Where am I? Investigating map matching during self-localization with mobile eye tracking in an urban environment. Transactions in GIS. 18 (5), 660-686 (2014).

- Berto, R., Massaccesi, S., Pasini, M. Do Eye Movements Measured across High and Low Fascination Photographs Differ? Addressing Kaplan's Fascination Hypothesis. Journal of Environmental Psychology. 28 (2), 185-191 (2008).

- Kaplan, S. The restorative benefits of nature: Towards an integrative framework. Journal of Environmental Psychology. 15, 169-182 (1995).

- Duchowski, A. T. . Eye Tracking Methodology: Theory and Practice. , (2017).

- Amati, M., Ghanbari Parmehr, E., McCarthy, C., Sita, J. How eye-catching are natural features when walking through a park? Eye- tracking responses to videos of walks?. Urban Forestry and Urban Greening. 31, 67-78 (2018).

- Gould, S. D. A. R. W. I. N. A Framework for Machine Learning and Computer Vision Research and Development. Journal of Machine Learning Research. (Dec), 3533-3537 (2012).

- Richardson, D., Matlock, T. The integration of figurative language and static depictions: an eye movement study of fictive motion. Cognition. 102 (1), 129-138 (2007).

- Bojko, A. . Eye Tracking the User Experience: A Practical Guide to Research. , (2013).

転載および許可

このJoVE論文のテキスト又は図を再利用するための許可を申請します

許可を申請さらに記事を探す

This article has been published

Video Coming Soon

Copyright © 2023 MyJoVE Corporation. All rights reserved