Method Article

Combinare i dati di tracciamento degli occhi con un'analisi dei contenuti video da Free-visualizzazione di un video di una passeggiata in un ambiente parco urbano

In questo articolo

Riepilogo

L'obiettivo del protocollo è quello di dettaglio come raccogliere i dati video per l'uso in laboratorio; come registrare i dati Eye-Tracking dei partecipanti guardando i dati e come analizzare in modo efficiente il contenuto dei video che stavano guardando utilizzando una tecnica di apprendimento automatico.

Abstract

Come individui sempre più vivono in città, metodi per studiare i loro movimenti quotidiani e i dati che possono essere raccolti diventa importante e prezioso. Gli Eye-Tracking informatici sono conosciuti per connettersi a una serie di sentimenti, condizioni di salute, stati mentali e azioni. Ma poiché la visione è il risultato di continui movimenti oculari, prendere in giro ciò che è importante da ciò che è il rumore è complesso e intensivo di dati. Inoltre, una sfida significativa sta controllando ciò che le persone guardano rispetto a ciò che gli viene presentato.

Di seguito viene presentata una metodologia per combinare e analizzare gli eye-tracking su un video di una scena naturale e complessa con una tecnica di machine learning per l'analisi del contenuto del video. Nel protocollo ci concentriamo sull'analisi dei dati da video girati, come un video può essere utilizzato al meglio per registrare i dati degli occhi dei partecipanti, e soprattutto come il contenuto del video può essere analizzato e combinato con i dati di tracciamento degli occhi. Presentiamo un breve riassunto dei risultati e una discussione del potenziale del metodo per ulteriori studi in ambienti complessi.

Introduzione

Le nostre esperienze quotidiane vissute negli ambienti urbani influiscono notevolmente sulla nostra salute e sul nostro benessere. Il nostro benessere può dipendere dalla quantità di spazi verdi che vediamo e sperimentiamo1,2,3, e queste viste possono essere quantificate utilizzando attrezzature Eye-Tracking per guidare il processo decisionale su Park Design. Tuttavia, si verifica un problema con il volume di dati di rilevamento degli occhi che viene generato e che dà un senso di questi dati. Poiché l'apparecchiatura per la registrazione dei dati dello sguardo in un laboratorio o in un ambiente naturale diventa più facile da usare e più potente, i ricercatori devono considerare come possiamo raccogliere e analizzare i dati validamente per aiutare con le domande decisionali.

Finora, una grande quantità di ricerca Eye Tracking ha usato fotografie in un sondaggio o impostazione di laboratorio4. Sebbene questa metodologia consenta una grande quantità di riproducibilità e controllo sui risultati, non è in grado di trarre vantaggio degli ultimi progressi nella tecnologia Eye-tracking che includono l'uso di video e Wearable eye-tracker mobili. Inoltre, vorremmo sostenere che l'atto di camminare e di rilassarsi è necessariamente dinamico soprattutto quando orientato verso un compito come segnaletica5. Pertanto, una conoscenza pienamente scientifica di queste impostazioni dovrebbe avvenire al di fuori del laboratorio. Tuttavia, al momento, l'Eye-Tracking in un ambiente naturalistico reale rende il confronto dell'esperienza tra soggetti molto difficile. Per esempio, se volevamo confrontare se un rispondente Guarda gli alberi più di un altro, come possiamo controllare per il fatto che il loro punto di vista sarebbe in continua evoluzione rispetto ad altri o che la loro testa potrebbe essersi trasformata. L'analisi dettagliata in queste condizioni è quasi impossibile con le tecniche di analisi attuali. Vorremmo sostenere che è importante controllare le aree di visualizzazione disponibili per l'individuo in fase di studio e nell'analisi per essere in grado di tenere conto della scena totale visualizzata in qualsiasi momento.

Ci sono una serie di teorie che collegano i livelli di stress e le percezioni di sicurezza alle viste panoramiche e alle misure ben evolute dello stress6,7. C'è stato anche un rapido aumento della sofisticazione delle attrezzature Eye-Tracking per misurare lo sguardo8. L'Eye-Tracking è importante perché i movimenti involontari degli occhi possono essere collegati in modo più affidabile alle preferenze, allo stress e ad altre misure tradizionali rispetto ai sondaggi e ai test fisiologici intrusivi, come i livelli di cortisolo salivare. L'obiettivo di questa ricerca è quello di sviluppare strumenti che consentano una misurazione più precisa dei dati di tracciamento degli occhi applicati a contesti più naturalistici, in modo da fornire ulteriori prove o confutare le teorie paesaggistiche di lunga data che hanno informato la progettazione del parco per Decenni.

Lo scopo di questo progetto è quello di sviluppare e testare una nuova tecnica di analisi in grado di generare dati di tracciamento degli occhi rilevanti per diversi video di simulazioni di camminata del parco. Il nostro lavoro riportato qui e altrove9 rappresenta un punto a metà strada tra l'impostazione naturalistica di un sistema di tracciamento degli occhi completamente mobile e gli studi fotografici basati su laboratorio di cui sopra. In particolare, ci concentriamo sull'utilizzo di video come materiale di stimolo, esplorando come questo materiale può essere utilizzato per testare la quantità di fascino che i diversi parchi generano nella città di Melbourne. Il nostro lavoro si basa sul presupposto che un'analisi dettagliata dei video sia un passo necessario per violare prima di intraprendere una valutazione più completa e più naturalistica del potenziale dei parchi per fornire il restauro dallo stress.

In questo studio, abbiamo impiegato un eye-tracker desktop con video di passeggiate attraverso parchi urbani e ha chiesto ai partecipanti di immaginare che stavano facendo una passeggiata rilassante attraverso un parco. Descriviamo un metodo per consentire la quantità di tempo che i partecipanti hanno speso a guardare diversi oggetti per essere comparabili tra i parchi. Gli studi sul desktop sono generalmente più facili da controllare rispetto agli studi ET mobili e consentono l'analisi comparativa di ogni soggetto.

Il software di tracciamento degli occhi standard utilizza uno strumento di area di interesse manuale in cui un operatore può disegnare manualmente i contorni intorno agli oggetti di interesse in ogni scena. In questo modo la quantità di tempo che i partecipanti hanno speso a guardare diversi oggetti da conteggiare automaticamente. Per i dati video, questo processo è intensivo di manodopera e soggetto a soggettività e errore dell'operatore. Nelle versioni successive del software di analisi Eye-Tracking, AOIs può monitorare automaticamente gli oggetti tra i fotogrammi quando sono della stessa dimensione nel video. Questo è un miglioramento, tuttavia, questo è destinato solo per essere utilizzato per un piccolo numero di stimoli in ogni immagine e ogni immagine deve essere verificata e confermata.

L'etichettatura manuale degli oggetti in un'immagine è comune e supportata da software di editing di immagini come il programma di manipolazione delle immagini GNU (GIMP). Dato che 1 s produce 30 fotogrammi o immagini, l'etichettatura manuale dei video è poco pratica. Inoltre, l'etichettatura AOI disegnando poligoni vettoriali attorno al bordo di oggetti complessi come le tettine degli alberi richiede molto tempo. Infine, sebbene sia plausibilmente possibile calcolare la dimensione degli oggetti in un campo visivo utilizzando l'etichettatura vettoriale, questa funzione non è attualmente disponibile.

Il metodo che riportiamo qui di seguito si occupa di queste limitazioni. Questo studio ha impiegato l'etichettatura automatica degli oggetti. Questo è possibile utilizzando una tecnica di elaborazione delle immagini nota come etichettatura semantica, in cui ogni pixel in ogni fotogramma del video viene assegnata un'etichetta che indica una classe di oggetti. L'apprendimento automatico viene utilizzato per derivare i classificatori di pixel per ogni classe di oggetti di interesse. Questi classificatori forniscono un'etichetta probabilistica per ogni pixel (noti come potenziali unari), che vengono poi perfezionati in un successivo processo di ottimizzazione per ottenere l'output finale etichettato. Questi classificatori imparano i confini delle decisioni statistiche tra ciascuna classe di oggetti nello spazio delle feature estratte dall'immagine, tra cui texture, istogramma degli orientamenti dei bordi, valori di colore RGB e le coordinate dell'immagine normalizzata. Una tecnica appropriata per questo è implementata nella cassetta degli attrezzi di DARWIN Machine Learning10 ed è descritta di seguito.

Protocollo

L'approvazione etica per questo progetto è stata data dal numero di approvazione della Commissione etica dell'Università cattolica australiana #201500036E. Ciò ha assicurato che il consenso informato è stato acquisito da tutti i partecipanti e tutti i partecipanti hanno partecipato volontariamente, e che i dati dei partecipanti sono rimasti anonimi e riservati. Inoltre l'approvazione è stata data a causa del metodo e delle attrezzature conformi alle norme di sicurezza australiane.

1. riprese di scene urbane che possono essere utilizzate in uno studio Eye-Tracking

- Utilizzare una videocamera digitale di alta qualità collegata a una Gimbal per creare un video simulato ' walking ' o ' seduto '.

- Registra il film con movimenti fluidi lisci in risoluzione 4K a 25 fps e salvarli a 1920 x 1080 HD.

- Utilizzare una società di riprese professionali per produrre film digitali se non familiarità con questo o mancanza di accesso alle attrezzature.

- Scatta film in una sola volta, a una sola lunghezza su tutti i video con precise rotte e caratteristiche predefinite.

Nota: i dettagli video di esempio: ogni film a piedi simulato è stato 3 min 50 s di lunghezza e ogni film di seduta simulato è stato 1 minuto di lunghezza. Per entrambi i video in questo studio, i video hanno iniziato con una breve salita scala che conduce a un percorso. Il percorso è stato seguito per esattamente 1 min 30 s e poi la fotocamera fermato e stroncato sinistra per 45-60 gradi e si fermò per 15 secondi. La fotocamera proseguì lungo il percorso a piedi fino a quando il segno di 3 min 25 s, stroncato sinistra 40-70 gradi per 15 secondi, continuò lungo il percorso fino a quando il 3 min 50 s marchio, poi sbiadito a nero. - Assicurarsi che i film siano comparabili, in altre parole non introducono nuovi dati sullo sguardo da diverse traiettorie di camminata o movimento della fotocamera. Un film è stato preso di ogni passeggiata, due in totale.

- Poiché i movimenti oculari sono influenzati dal suono, registrare un file di generico parco urbano suona da una delle passeggiate per la stessa lunghezza del video senza interruzioni da rumori improvvisi al di fuori del parco (ad esempio, allarmi auto). Questo può essere riprodotto al posto della colonna sonora esistente da entrambi i video in modo che l'impatto visivo del video possa essere isolato.

Nota: il movimento eccessivo di veicoli e altri oggetti può influenzare i movimenti oculari e inclinare i risultati. Se si verifica una parte di questa intrusione, il film può essere riprodotto ai partecipanti, ma i fotogrammi potrebbero dover essere esclusi dall'analisi. - Se interessati a diverse attività in una passeggiata, come camminare e poi seduti su una panchina, salvare o modificare le scene di seduta e a piedi come file separati in modo da testare in modo indipendente.

2. configurazione e calibrazione del desktop dell'apparecchiatura di tracciamento oculare

- Mostra le sequenze filmate agli individui in una stanza in cui la luce naturale può essere esclusa per evitare riflessi sullo schermo. Mostralo a loro su uno schermo più grande possibile per occupare la maggior parte del campo visivo, evitando così la distrazione dall'esterno del campo di vista. Un monitor per PC widescreen (16:9) (22 pollici) con partecipanti di circa 60 cm di distanza dallo schermo è uno standard accettabile.

- Eseguire una calibrazione sullo schermo per ogni partecipante utilizzando lo strumento di calibrazione integrato sul software di tracciamento degli occhi. Richiedere ai partecipanti di guardare una palla rossa muoversi intorno allo schermo come parte di questo e fermarsi a 5 punti di calibrazione chiave.

- Durante la calibrazione osservare i partecipanti e assicurarsi che non si muovono anche la testa. Se sono troppo vicini allo schermo e lo schermo è molto grande questo può essere un problema. Regolare la distanza dallo schermo di conseguenza.

- Modifica ogni pellicola per avere una croce bianca situata nell'angolo in alto a sinistra dei primi fotogrammi del video. Questo può essere fatto utilizzando un software di editing video. Mostra questa schermata per 3 secondi, quindi inizia a giocare la passeggiata. Questo è per controllare la calibrazione Eye-Tracking e per garantire che i tempi di raccolta dei dati Eye-Tracking potrebbero essere abbinati con singoli numeri di fotogramma.

3. reclutamento ed etica

- Utilizzare una società di reclutamento di ricerca professionale per garantire una diffusione di diversi generi, età e occupazioni tra il campione o reclutare in loco tra il corpo dello studente e del personale.

- Partecipanti allo schermo per condizioni oculari o neurologiche conosciute e/o lesioni. Devono essere chiesti se stanno assumendo farmaci che sono noti per influenzare i movimenti oculari (ad es. benzodiazepine).

- Condotta vicino a test di lettura della vista e un test di escursione di movimento della torcia della penna per dimostrare che hanno escursioni di movimento degli occhi pieni.

- Partecipanti al sondaggio circa l'età, il sesso e la frequenza di utilizzo del parco.

4. configurazione sperimentale dei partecipanti

- Chiedete ai partecipanti di immaginarsi bisognosi di restauro. Utilizzare una frase che permette loro di immaginare il contesto del video Eye-Tracking utilizzato come:' Immaginate che è mezzogiorno e si cammina da solo a Melbourne. Siete mentalmente stanchi di intensa concentrazione al lavoro e siete alla ricerca di un posto dove andare a fare una passeggiata, sedersi e riposare per un po', prima di tornare al lavoro '.

- Sedersi i partecipanti comodamente davanti allo schermo del computer ad una distanza di 60 – 65 cm per visualizzare i film.

- Utilizzando un programma di fogli di calcolo ordinare i film casualmente prima di giocare davanti ai partecipanti.

- Utilizzare gli altoparlanti per riprodurre lo stesso audio per tutti i film.

- Registra la traiettoria dello sguardo dei partecipanti utilizzando un sistema di tracciamento degli occhi del desktop. Montare il dispositivo desktop Eye-Tracking secondo le istruzioni del produttore. Questo potrebbe essere appena sotto lo schermo su una tabella, o potrebbe agganciare al bordo dello schermo, in cima ad esempio.

- Utilizzare un'unità Eye-tracking che ha una frequenza di campionamento di 120 Hz e una precisione di 0,50 °, che consente una grande libertà di movimenti della testa permettendo la registrazione durante i movimenti della testa naturali. È anche accettabile un eye-tracker di frequenza inferiore. A 57,3 cm, 1 ° di angolo visivo equivale a ~ 1 cm sullo schermo.

- Consenti ai partecipanti di guardare il filmato su un monitor in alta definizione.

- Registrare i movimenti oculari utilizzando il software Eye-Tracking

- Impiegare un filtro di fissazione per convertire i dati di esempio di occhio grezzo per l'analisi. Dal menu principale, fare clic su strumenti ≫ impostazioni. Selezionare la scheda filtri di fissazione . Selezionare il filtro di fissazione in base alle specifiche del produttore sul miglior tipo di filtro per aggregare i dati grezzi di tracciamento degli occhi in fissazioni.

- Se la registrazione di dati Eye-Tracking utilizzando più film, dare pause tra le sessioni di registrazione ogni volta che i partecipanti lo richiedono.

5. collegamento dei parchi visti alle impressioni dei video

- Confronta la misura in cui le persone hanno visto gli oggetti e le loro opinioni dei video chiedendo ai partecipanti di valutare ciascuno dei parchi su una scala di 1 – 10, in primo luogo per se ritenesse che sarebbero in grado di riposare e recuperare in quell'ambiente (1 , non molto, a 10, molto) e in secondo luogo quanto gli piaceva il parco (1, non molto, a 10, molto).

- Chiedi ai partecipanti se avrebbero utilizzato il parco per rilassarsi o alleviare lo stress (s/N) e se hanno riconosciuto il parco che stavano guardando (s/N) per controllare il potenziale impatto di una precedente associazione con il parco.

- Registra risposte di risposta brevi dai partecipanti per spiegare le loro impressioni utilizzando un registratore vocale e poi trascridi questi.

6. analisi video automatica per estrazione area di interesse

- Selezione di AOIs

- Scegli oggetti che sono di interesse per i progettisti di parchi, progettisti urbani, progettisti o architetti, come alberi, arbusti, cartelli, edifici, tappeto erboso, sentieri, gradini, ecc.

- Per prestazioni ottimali e requisiti minimi di formazione (discussi più avanti), utilizzare elementi facilmente distinguibili l'uno dall'altro ad occhio nudo e/o occupare costantemente diverse regioni di ogni fotogramma video. In generale, è sufficiente un numero sufficiente di esempi di formazione che descrivano le differenze visive di ciascuna AOI per prestazioni solide.

- Classificatori di formazione per l'estrazione AOI

- Selezione dei telai formativi da utilizzare, numero e motivazioni

- Scegliere un numero appropriato di fotogrammi di training (da ora in poi denominato set di training). Non esiste un numero fisso appropriato.

Nota: i fotogrammi devono fornire una copertura sufficiente della gamma di aspetto visivo di ogni classe di oggetti (ad esempio, quegli oggetti da etichettare) in tutto il video. Ad esempio, sono stati trovati 40 fotogrammi di una sequenza video di 15.000 fotogrammi che raffigurano una singola scena di parco per ottenere una precisione sufficiente. Se una sequenza contiene variazioni significative, potrebbero essere necessari più fotogrammi. - Considerare il contenuto del fotogramma quando si scelgono i fotogrammi di training. Questi includono: illuminazione, forme rispetto a ciò che viene classificato (ad esempio, non solo un tipo di albero, ma una gamma di tipi di albero, la loro posizione nell'immagine, il modo in cui sono illuminati, ecc), texture e colore.

- Considerare anche il numero di fotogrammi da includere. In particolare, la lunghezza e la variazione delle condizioni visive esposte nel video analizzato, nonché il numero di classi di oggetti da identificare e la frequenza del loro aspetto.

- Scegliere un numero appropriato di fotogrammi di training (da ora in poi denominato set di training). Non esiste un numero fisso appropriato.

- Etichettatura manuale dei pixel per i telai di allenamento

Nota: l'etichettatura manuale dei fotogrammi di training associerà i pixel alle classi di oggetti di interesse.- Etichettatura dei pixel dei telai di allenamento

- A sua volta, aprire ogni fotogramma di formazione dal video nel software di editing delle immagini.

- Per ogni fotogramma di allenamento del video, Sovrapponi un livello di immagine trasparente sull'immagine caricata per l'etichettatura e crea una tavolozza di colori, fornendo un colore per ogni classe di oggetti di interesse (ad esempio, AOI).

- Assicurarsi che la tavolozza dei colori e la mappatura dei colori alle classi di oggetti siano uguali per tutto il processo di etichettatura.

- Selezionare il colore per l'AOI di esempio.

- Regioni di colore di esempio AOIs selezionando, con un clic del mouse e trascinare, pixel all'interno dell'area per "colore in" utilizzando la scelta tavolozza appropriata.

Nota: è possibile colorare oggetti di grandi dimensioni in modo impreciso. Tuttavia, per gli oggetti stretti/piccoli di soli pochi pixel di larghezza, prestare maggiore attenzione a garantire che l'etichettatura manuale cattura accuratamente l'aspetto visivo dell'oggetto. - Una volta completata l'etichettatura di un fotogramma, esportate il livello sovrapposto come file immagine separato. Assicurarsi che il nome del file di base corrisponda al nome del file di base del fotogramma originale, ma con un "c" aggiunto alla fine. Ad esempio, se il nome del file del fotogramma originale era "1234. png", allora l'etichetta deve essere "1234c. png".

- Assicurarsi che tutte le immagini etichettate siano memorizzate in una singola cartella.

-

Etichettatura dei pixel dei fotogrammi di validazione

Nota: per convalidare quantitativamente l'accuratezza del classificatore addestrato, è necessario creare un set aggiuntivo di fotogrammi etichettati.- Selezionare i fotogrammi della sequenza video originale non già scelti per essere inclusi nel set di training. Per un video di 5 minuti, questi non devono essere più di 20 fotogrammi, ma devono essere campionati uniformemente da tutta la sequenza video per garantire una copertura sufficiente.

- Etichettare i pixel in ogni fotogramma utilizzando la stessa procedura descritta per la preparazione dei fotogrammi di training (6.2.2). Tuttavia, questa volta è il più preciso e il più completo possibile con l'etichettatura in quanto questo sarà utilizzato come un confronto di verità a terra.

- Quando l'etichettatura di un fotogramma è completa, utilizzare la stessa convenzione di denominazione per la formazione, tuttavia assicurarsi che i file vengono salvati in una cartella di fotogrammi di convalida separata.

- Etichettatura dei pixel dei telai di allenamento

- Etichettatura automatica dei pixel della sequenza video

- Scaricate la libreria software di DARWIN da http://drwn.anu.edu.au.

Nota: il sistema descritto in questo documento è stato implementato all'interno di un ambiente Linux, e quindi il rilascio di Linux di DARWIN deve essere scaricato e installato, seguendo le istruzioni del sito Web. - Lancia la GUI di Darwin

- Nella GUI di Darwin, clicca su carica etichette di addestramento.

- Utilizzando la finestra di dialogo Esplora file visualizzata, selezionare la cartella contenente le immagini di training etichettate per la sequenza video pertinente.

- Fare clic su carica fotogrammi video e seguire la stessa procedura di 6.2.3.2 per selezionare la cartella contenente tutti i fotogrammi originali della sequenza video. Questa dovrebbe essere una cartella di immagini, in cui ogni frame filename è il numero di quel fotogramma nella sequenza video (ad esempio, il fotogramma 1234 sarebbe denominato 1234. png)

- Fare clic sul pulsante treno . L'algoritmo esaminerà ora ogni fotogramma di training etichettato e imparerà un modello di aspetto per classificare i pixel in una delle classi di oggetti di interesse specificate.

- Scaricate la libreria software di DARWIN da http://drwn.anu.edu.au.

- Convalida del classificatore addestrato

- Al termine dell'allenamento, fare clic sul pulsante convalida Training .

- Utilizzando la finestra di dialogo Esplora file, selezionare la cartella contenente tutte le immagini di convalida etichettate per la sequenza video pertinente. Il classificatore addestrato verrà ora utilizzato per classificare i pixel in ognuno dei fotogrammi a cui si riferisce il set di convalida. Confrontarlo con le etichette di verità di terra fornite nella cartella di convalida.

Nota: una volta completata, la GUI visualizzerà le statistiche di accuratezza, inclusa la percentuale di pixel correttamente etichettate per ogni fotogramma nel set di convalida, nonché nell'intero set di convalida. - Per convalidare visivamente le etichette generate, fare clic sul pulsante convalida visiva . Se si fa clic, ogni immagine generata con etichetta viene visualizzata accanto al fotogramma di convalida originale.

Nota: questo può essere istruttivo nell'identificare dove si verificano le mis-classificazioni sull'oggetto. Ad esempio, l'ispezione visiva può indicare che gli errori si verificano in modo coerente in una particolare parte di una classe di oggetti, suggerendo che è necessaria una migliore etichettatura nel set di training. In alternativa, l'ispezione può mostrare che gli errori si verificano solo in un particolare punto temporale nel video, suggerendo più esempi di formazione sono necessari da quel periodo di tempo nel video. - Se l'accuratezza osservata in una convalida quantitativa o qualitativa scende al di sotto dei livelli accettabili, includere ulteriori esempi di formazione. In questo caso, ripetere tutti i passaggi da 6.2.2 per includere i frame di training aggiuntivi, riaddestrare il classificatore seguendo i passaggi in 6.2.3 e convalidare nuovamente i passaggi seguenti in 6.2.4.

- Etichettatura dei pixel video

- Una volta completata la fase di training e validazione del classificatore, fare clic su etichette cornici sulla GUI di Darwin per iniziare l'etichettatura completa di tutti i fotogrammi nella sequenza video utilizzando il classificatore addestrato.

- Seguire la richiesta di selezionare una cartella di destinazione per tutti i fotogrammi di output, che saranno sotto forma di immagini etichettate utilizzando la stessa tavolozza di colori utilizzata per la formazione.

- Selezione dei telai formativi da utilizzare, numero e motivazioni

7. registrazione dei dati di tracciamento degli occhi ai contenuti video

- Nel software Eye-Tracking clicca su File ≫ Esporta... Esporta il file di tracciamento degli occhi come file CSV.

- Aprire il file in un foglio di calcolo.

- Dalla sequenza video si identifica il tempo in cui la croce bianca sulla parte superiore sinistra del telaio (vedere 2,3) scompare. Utilizzare questa volta per identificare l'Eye-Tracking utilizzando la colonna pertinente sul risultato del tracciamento oculare. Questo è l'inizio della raccolta di dati Eye-Tracking.

- Aggiungere una colonna ai dati di tracciamento degli occhi.

- Utilizzando questa nuova etichetta di colonna ogni riga o punto dati di tracciamento degli occhi con un numero di fotogramma a partire dal numero 1.

8. visualizzazione della quantità di tempo che i partecipanti hanno esaminato diverse classi di oggetti nei video

Nota: a causa delle enormi dimensioni dei dati di tracciamento degli occhi, il linguaggio di programmazione Python è meglio utilizzato per passi fino a 8,4, anche se può essere utilizzato anche un programma di elaborazione dati.

- Utilizzando il codice Python incluso, calcolare la quantità di sovrapposizione tra gli oggetti di interesse e il tempo di fissazione Eye-Tracking e la frequenza.

- Sommare questi dati per capire la quantità di tempo che i partecipanti hanno speso a guardare oggetti diversi.

- Impiegare un istogramma per mostrare la quantità totale di tempo che gli oggetti occupano lo schermo.

- Confrontarlo con la quantità totale di tempo che i partecipanti hanno esaminato oggetti diversi.

- Per produrre una Heatmap nel software Eye-Tracking clicca su uno dei video a piedi del parco utilizzando la casella di spunta.

- Fare clic sulla scheda mappa termica .

- Regolare il colore e altre caratteristiche della mappa di calore come desiderato utilizzando le variabili di ' conteggio ' (numero totale di fissazioni effettuate sulla finestra temporale),' durata assoluta ' (durata di fissazione accumulata), è durata relativa ' (la quantità di tempo trascorso a guardare un oggetto diviso per la quantità di tempo trascorso a guardare una scena).

- Esporta l'immagine o il video che include la mappa di calore come file JPEG o video.

Risultati

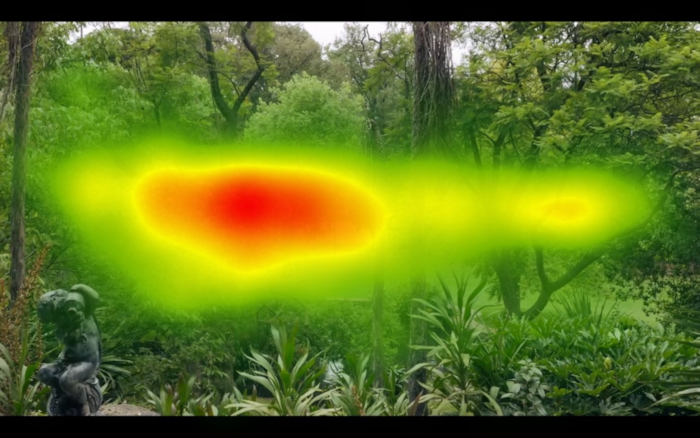

Figura 1 e Figura 2 mostrano il risultato di prendere tutti i dati Eye-Tracking per l'intero video in tutti i partecipanti e la produzione di una mappa di calore; Questo è l'approccio standard disponibile nei pacchetti software Eye-Tracking. Confrontando la Figura 1 e la Figura 2 è possibile identificare che in media i partecipanti scansionati a destra e a sinistra sulla coordinata x del video in Figura 1 rispetto alla Figura 2, che mostra una forma tuttofare. Questo perché la Figura 1 aveva più elementi orizzontali in tutto il video rispetto al parco in Figura 2. L'immagine dietro la mappa di calore è un singolo fotogramma e non rappresenta adeguatamente il contenuto completo del video.

Il sistema di tracciamento degli occhi del desktop e il software contano solo i risultati in cui entrambi gli occhi possono essere posizionati allo stesso tempo. In altre parole, se uno o entrambi gli occhi non possono trovarsi, i dati vengono conteggiati come persi. Nel nostro caso i dati Eye-Tracking sono stati catturati per > 80% del tempo.

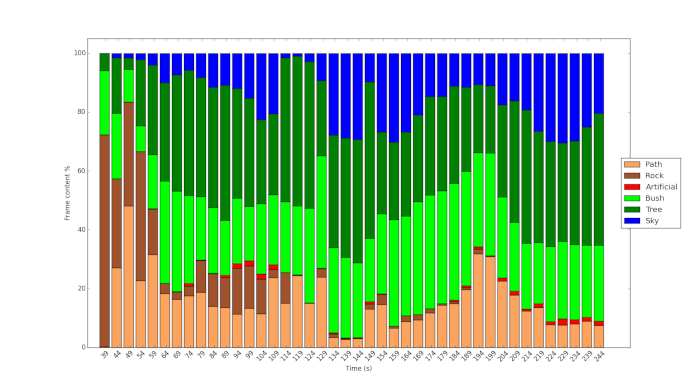

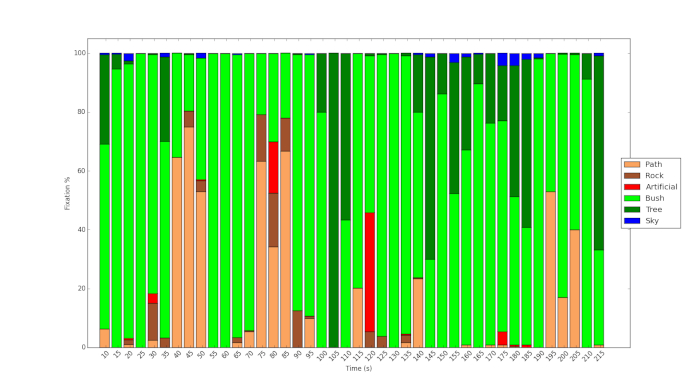

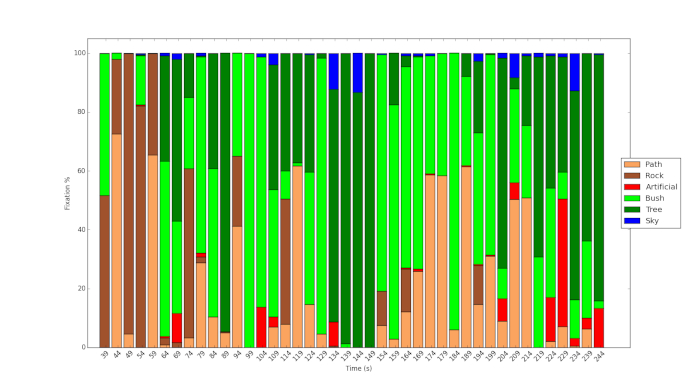

Figura 3 e Figura 4 mostrano il risultato dell'utilizzo del protocollo e l'uso di machine learning per analizzare il contenuto dei video. Figura 3 Mostra la fitta vegetazione di Fitzroy Gardens rispetto alla vegetazione relativamente scarsa di Royal Park (Figura 4). In quest'ultimo, più cielo è visibile, più delle scene sono dominate da vegetazione arbusto. Figura 5 Mostra il tempo di fissazione% sui diversi oggetti durante il corso del video per uno dei partecipanti. Esso mostra che anche se il percorso è chiaramente visibile durante il corso del video, il partecipante Guarda solo a questa funzione occasionalmente ma in punti chiave. Analogamente, come Mostra la Figura 6 , anche se una piccola frazione del contenuto del video in Royal Park riguarda oggetti artificiali, il partecipante allo studio esamina queste caratteristiche in misura relativamente grande.

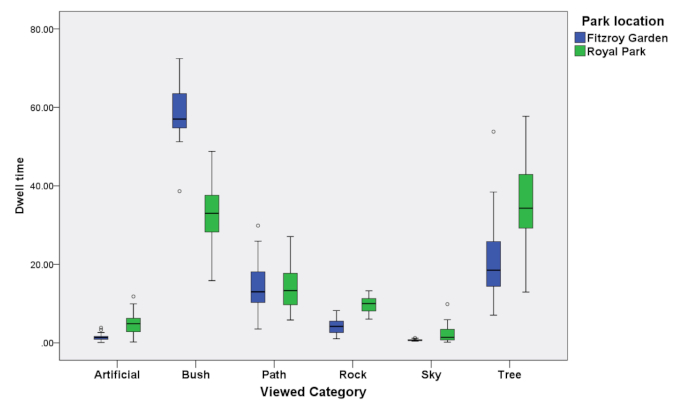

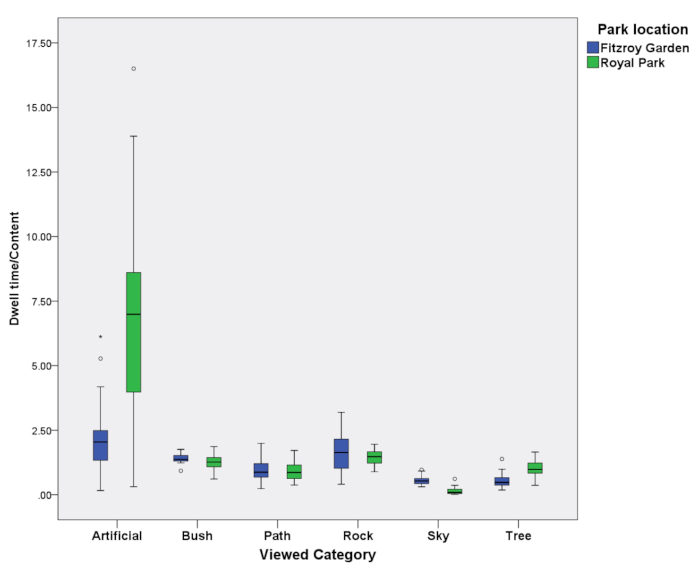

I risultati della figura 3, figura 4, Figura 5e Figura 6 possono essere riepilogati in Figura 7 e Figura 8 per tutti i 39 partecipanti i cui dati sono stati utilizzati in questo studio. Figura 7 Mostra il tempo di permanenza per tutti i partecipanti quando si Guarda gli oggetti per tutta la lunghezza del video. Figura 8 Mostra gli stessi dati divisi per la quantità di tempo e lo spazio che questi diversi oggetti occupati nel video. Il valore 1 indica che il tempo di permanenza può essere contabilizzato in base alla quantità di oggetto nel video. La Figura 7 Mostra che gli oggetti artificiali come le luci di strada e le panchine sono abitate in misura maggiore rispetto ad altri oggetti (> 1). Figura 7 Mostra anche che gli oggetti che erano meno pertinenti, come il cielo in entrambe le immagini, sono stati visti relativamente meno (< 1).

Figura 1: esempio di mappa termica prodotta per l'intero video di uno dei parchi. Questo mostra dove sono state situate la maggior parte delle tracce oculari. Si noti la forma orizzontale della mappa di calore a causa della dominanza degli elementi orizzontali nel video. Si prega di cliccare qui per visualizzare una versione più grande di questa cifra.

Figura 2: esempio di mappa termica che viene prodotta per l'intero video di un altro dei parchi. Si noti la forma più arrotondata a causa della presenza di elementi verticali e orizzontali nel video. Si prega di cliccare qui per visualizzare una versione più grande di questa cifra.

Figura 3: istogramma del contenuto nel video di Fitzroy Gardens analizzato utilizzando la tecnica di apprendimento automatico. Si prega di cliccare qui per visualizzare una versione più grande di questa cifra.

Figura 4: istogramma del contenuto nel video di Royal Park analizzato utilizzando la tecnica di apprendimento automatico. Si prega di cliccare qui per visualizzare una versione più grande di questa cifra.

Figura 5: tempo di fissazione Eye Tracking speso guardando gli oggetti in Fitzroy Gardens. Si prega di cliccare qui per visualizzare una versione più grande di questa cifra.

Figura 6: tempo di fissazione Eye Tracking speso guardando gli oggetti in Royal Park. Si prega di cliccare qui per visualizzare una versione più grande di questa cifra.

Figura 7: tempi di permanenza del tracciamento degli occhi aggregati per tutti i partecipanti e oggetti per entrambi i parchi. Si prega di cliccare qui per visualizzare una versione più grande di questa cifra.

Figura 8: tempi di permanenza del tracciamento degli occhi aggregati relativi al contenuto per tutti i partecipanti e oggetti per entrambi i parchi. Si prega di cliccare qui per visualizzare una versione più grande di questa cifra.

Discussione

Generalmente, nei pacchetti software standard per l'analisi dei dati di tracciamento oculare, viene utilizzato un vettore AOI. Anche per una singola immagine fissa, la dimensione del vettore non può essere facilmente misurata. Inoltre, includendo tutti gli AOIs in un'immagine e calcolando le relative quantità di AOIs è laborioso. È quasi impossibile farlo manualmente su un video senza una tecnica di apprendimento automatico come quella descritta. Questa è stata una dichiarazione relativamente semplice che deduce una situazione di visione libera. Uno scenario molto più preciso può essere utilizzato e diverse descrizioni dello scenario prima che lo stesso stimolo possa influenzare anche i movimenti oculari11.

La nostra ricerca ha utilizzato un metodo per classificare accuratamente gli oggetti in un video e analizzare la misura in cui questi erano visibili all'occhio. Il metodo rappresenta un mezzo di contabilità per la misura in cui i movimenti oculari sono collegati a oggetti di interesse. Ciò consente di controllare la misura in cui gli oggetti di interesse sono presenti in un campo visivo quando si confronta il tracciamento degli occhi da soggetti diversi con un dispositivo mobile per il tracciamento degli occhi o posizioni diverse quando si utilizza un sistema basato su desktop. Considerazioni che possono influenzare la classificazione automatica degli oggetti utilizzando l'apprendimento automatico che impieghiamo includono illuminazione, forme rispetto a ciò che viene classificato (ad esempio , non solo un tipo di albero, ma una serie di tipi di albero, la loro posizione nel l'immagine, il modo in cui sono illuminati ecc.), la texture e il colore. Le considerazioni sul numero di fotogrammi includono la lunghezza e la variazione delle condizioni visive esposte sul video analizzato, nonché il numero di classi di oggetti da identificare e la frequenza del loro aspetto. I fotogrammi cambiano ogni 1/25 secondi, ma il tracciamento degli occhi con il software si verifica a 1/120 (120 Hz). Per questo motivo i dati di tracciamento degli occhi saranno raccolti a 4,8 volte la velocità con cui viene visualizzato un nuovo fotogramma. Non è possibile etichettare completamente con precisione, ma l'etichettatura dei telai dovrebbe cambiare ogni 5 volte. Ad esempio, i dati di tracciamento degli occhi durante 99 a 101 s sono stati presi in considerazione per il fotogramma del 100 ° secondo del video.

Un vantaggio significativo degli attuali pacchetti Eye-Tracking è che sono impostati per consentire agli utenti di rivedere un film di loro fissazioni e percorsi di tracciamento degli occhi e descrivere il motivo per cui hanno guardato alcuni oggetti. Ciò si traduce in un set di dati qualitativi che può rivelare perché i singoli soggetti pensano di aver esaminato determinati oggetti. Un'estensione del progetto potrebbe anche mostrare loro la quantità di tempo trascorso a guardare gli oggetti in momenti diversi rispetto al contenuto, ad esempio le informazioni in Figura 8. Eppure, facendo questo controllando per il numero di oggetti in una scena abbastanza rapidamente non è attualmente possibile.

Ad esempio, ai partecipanti potrebbe essere chiesto di visualizzare i propri percorsi di sguardo che erano stati registrati e di descrivere il motivo per cui avevano guardato i particolari oggetti12. Nel nostro caso, alla fine di ogni film i partecipanti sono stati invitati a votare ciascuno dei parchi su una scala di 1-10, in primo luogo per se si sentiva che sarebbero in grado di riposare e recuperare in quell'ambiente (1, non molto, a 10, molto) e in secondo luogo quanto hanno fatto a loro piace il Parco (1, non molto, a 10, molto).

Divulgazioni

nessuno

Riconoscimenti

Questo lavoro è stato sostenuto finanziariamente dalla città di Melbourne e parzialmente da ARC DP 150103135. Vorremmo ringraziare Eamonn Fennessy per il suo Consiglio e l'approccio collaborativo. Con un ringraziamento speciale agli assistenti di ricercatore Isabelle Janecki e Ethan Chen che hanno anche contribuito a raccogliere e analizzare questi dati. Tutti gli errori restano gli autori.

Materiali

| Name | Company | Catalog Number | Comments |

| 12 mm lens | Olympus | Lens | |

| Panasonic GH4 | Panasonic | Video Camera | |

| Tobii Studio version (2.1.14) | Tobii | Software | |

| Tobii x120 desktop eye-tracker | Tobii | Eye-tracker |

Riferimenti

- Patrik, P., Stigsdotter, U. K. The relation between perceived sensory dimensions of urban green space and stress restoration. Landscape and Urban Planning. 94 (3-4), 264-275 (2010).

- Bjørn, G., Patil, G. G. Biophilia: does visual contact with nature impact on health and well-being?. International Journal of Environmental Research and Public Health. 6 (9), 2332-2343 (2009).

- Velarde, M. a. D., Fry, G., Tveit, M. Health effects of viewing landscapes-Landscape types in environmental psychology. Urban Forestry & Urban Greening. 6 (4), 199-212 (2007).

- Polat, A. T., Ahmet, A. Relationships between the visual preferences of urban recreation area users and various landscape design elements. Urban Forestry & Urban Greening. 14 (3), 573-582 (2015).

- Peter, P., Giannopoulos, I., Raubal, M. Where am I? Investigating map matching during self-localization with mobile eye tracking in an urban environment. Transactions in GIS. 18 (5), 660-686 (2014).

- Berto, R., Massaccesi, S., Pasini, M. Do Eye Movements Measured across High and Low Fascination Photographs Differ? Addressing Kaplan's Fascination Hypothesis. Journal of Environmental Psychology. 28 (2), 185-191 (2008).

- Kaplan, S. The restorative benefits of nature: Towards an integrative framework. Journal of Environmental Psychology. 15, 169-182 (1995).

- Duchowski, A. T. . Eye Tracking Methodology: Theory and Practice. , (2017).

- Amati, M., Ghanbari Parmehr, E., McCarthy, C., Sita, J. How eye-catching are natural features when walking through a park? Eye- tracking responses to videos of walks?. Urban Forestry and Urban Greening. 31, 67-78 (2018).

- Gould, S. D. A. R. W. I. N. A Framework for Machine Learning and Computer Vision Research and Development. Journal of Machine Learning Research. (Dec), 3533-3537 (2012).

- Richardson, D., Matlock, T. The integration of figurative language and static depictions: an eye movement study of fictive motion. Cognition. 102 (1), 129-138 (2007).

- Bojko, A. . Eye Tracking the User Experience: A Practical Guide to Research. , (2013).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneThis article has been published

Video Coming Soon