Method Article

Combiner les données de suivi des yeux avec une analyse du contenu vidéo à partir de Free-visualisation d’une vidéo d’une promenade dans un environnement de parc urbain

Dans cet article

Résumé

L’objectif du protocole est de détailler Comment collecter des données vidéo à utiliser en laboratoire; Comment enregistrer les données de suivi oculaire des participants qui regardent les données et comment analyser efficacement le contenu des vidéos qu’ils cherchaient à utiliser une technique d’apprentissage automatique.

Résumé

Comme les individus vivent de plus en plus dans les villes, les méthodes pour étudier leurs mouvements quotidiens et les données qui peuvent être collectées devient important et précieux. L’informatique de suivi des yeux est connue pour se connecter à une gamme de sentiments, les conditions de santé, les États mentaux et les actions. Mais parce que la vision est le résultat de mouvements oculaires constants, taquiner ce qui est important de ce qui est le bruit est complexe et les données intensives. En outre, un défi important consiste à contrôler ce que les gens regardent par rapport à ce qui leur est présenté.

Ce qui suit présente une méthodologie pour combiner et analyser le suivi des yeux sur une vidéo d’une scène naturelle et complexe avec une technique d’apprentissage automatique pour analyser le contenu de la vidéo. Dans le protocole, nous nous concentrons sur l’analyse des données à partir de vidéos filmées, comment une vidéo peut être mieux utilisé pour enregistrer les données de suivi oculaire des participants, et surtout comment le contenu de la vidéo peut être analysé et combiné avec les données de suivi des yeux. Nous présentons un bref résumé des résultats et une discussion sur le potentiel de la méthode pour d’autres études dans des environnements complexes.

Introduction

Nos expériences quotidiennes d’environnements urbains ont un impact considérable sur notre santé et notre bien-être. Notre bien-être peut dépendre de la quantité d’espaces verts que nous avons vue et de l’expérience1,2,3, et ces vues peuvent être quantifiées à l’aide de l’équipement de suivi des yeux pour guider la prise de décision sur la conception du parc. Cependant, un problème survient avec le volume des données de suivi des yeux qui est générée et qui rend le sens de ces données. Comme l’équipement pour l’enregistrement des données de regard dans un laboratoire ou un environnement naturel devient plus facile à utiliser et plus puissant, les chercheurs doivent examiner comment nous pouvons collecter et analyser les données validement pour aider à des questions de prise de décision.

Jusqu’à présent, une grande partie de la recherche sur le suivi des yeux a utilisé des photographies dans un cadre de sondage ou de laboratoire4. Bien que cette méthodologie permette une grande reproductibilité et un contrôle sur les résultats, elle ne peut pas tirer parti des dernières avancées dans la technologie de suivi des yeux qui incluent l’utilisation de la vidéo et portable mobile Eye-trackers. En outre, nous affirons que l’acte de marche et de détente est nécessairement dynamique, surtout lorsqu’il est orienté vers une tâche telle que le orientation5. Par conséquent, une compréhension entièrement scientifique de ces paramètres devrait avoir lieu en dehors du laboratoire. Cependant, pour le moment, le suivi des yeux dans un cadre naturaliste de la vie réelle rend la comparaison de l’expérience entre les sujets très difficile. Par exemple, si nous voulions comparer si un répondant regarde les arbres plus qu’un autre, comment pourrions-nous contrôler le fait que leur point de vue serait en constante évolution par rapport à d’autres ou que leur tête pourrait avoir tourné. Une analyse détaillée dans ces conditions est presque impossible avec les techniques d’analyse actuelles. Nous soutenons qu’il est important de contrôler les zones d’observation à la disposition de la personne étudiée et, dans l’analyse, de pouvoir tenir compte de la scène totale qui est visualisée à un moment donné.

Il existe un ensemble de théories reliant les niveaux de stress et les perceptions de la sécurité aux vues paysagères et aux mesures bien évoluées du stress6,7. Il y a également eu une augmentation rapide de la sophistication de l’équipement de suivi oculaire pour mesurer le regard8. Le suivi des yeux est important parce que les mouvements oculaires involontaires peuvent être reliés de manière plus fiable à la préférence, au stress et à d’autres mesures traditionnelles que les enquêtes et les tests physiologiques intrusifs tels que les niveaux de cortisol salivaire. L’objectif de cette recherche est de développer des outils qui permettent une mesure plus précise des données de suivi oculaire appliquées à des contextes plus naturalistes, afin de fournir des preuves supplémentaires ou de réfuter les théories du paysage de longue date qui ont éclairé la conception du parc pour Décennies.

Le but de ce projet est de développer et de tester une nouvelle technique d’analyse qui peut générer des données pertinentes de suivi des yeux pour différentes vidéos de simulations de promenade de parc. Notre travail rapporté ici et ailleurs9 représente un point à mi-chemin entre le cadre naturaliste d’un système de suivi des yeux entièrement mobile et les études de photo en laboratoire mentionnées ci-dessus. En particulier, nous nous concentrons sur l’utilisation de vidéos comme matériau de stimulation, en explorant comment ce matériel peut être utilisé pour tester la quantité de fascination que les différents parcs génèrent dans la ville de Melbourne. Notre travail est basé sur l’hypothèse que l’analyse détaillée des vidéos est une étape nécessaire pour violer avant d’entreprendre une évaluation plus complète et plus naturaliste du potentiel des parcs pour fournir la restauration du stress.

Dans cette étude, nous avons employé un Eye-Tracker de bureau avec des vidéos de promenades dans les parcs urbains et a demandé aux participants d’imaginer qu’ils prenaient une promenade relaxante à travers un parc. Nous décrivons une méthode permettant de prévoir le temps que les participants ont passé à examiner différents objets pour être comparables entre les parcs. Les études de bureau sont généralement plus faciles à contrôler par rapport aux études mobiles et permettent une analyse comparative de chaque sujet.

Le logiciel standard de suivi des yeux utilise un outil de zone d’intérêt manuel dans lequel un opérateur peut tracer manuellement des limites autour des objets d’intérêt dans chaque scène. Cela permet de compter le temps que les participants ont passé à examiner différents objets pour être automatiquement comptés. Pour les données vidéo, ce processus est intensif en main-d’œuvre et soumis à la subjectivité et à l’erreur de l’opérateur. Dans les versions ultérieures du logiciel d’analyse de suivi des yeux, AOIs peut automatiquement suivre les objets à travers les trames quand ils sont de la même taille dans la vidéo. Il s’agit d’une amélioration, cependant, ce n’est destiné à être utilisé pour un petit nombre de stimuli dans chaque image et chaque image doit être vérifiée et confirmée.

L’étiquetage manuel des objets dans une image est commun et pris en charge par le logiciel d’édition d’images tel que GNU Image Manipulation Program (GIMP). Etant donné que 1 s produit 30 trames ou images, l’étiquetage manuel des vidéos n’est pas pratique. En outre, l’étiquetage AOI en dessinant des polygones vectoriels autour du bord d’objets complexes tels que les auvents d’arbres est très long. Enfin, bien qu’il soit possible de calculer la taille des objets dans un champ de vision à l’aide de l’étiquetage vectoriel, cette fonctionnalité n’est pas disponible actuellement.

La méthode que nous rapmettons ci-dessous traite de ces limitations. Cette étude a utilisé l’étiquetage automatique des objets. Ceci est possible à l’aide d’une technique de traitement d’image connue sous le nom d’étiquetage sémantique, dans laquelle chaque pixel de chaque image de la vidéo reçoit une étiquette indiquant une classe d’objet. L’apprentissage automatique est utilisé pour dériver des classificateurs de pixel pour chaque classe d’objet d’intérêt. Ces classificateurs fournissent une étiquette probabiliste pour chaque pixel (connu sous le nom de potentiels unaires), qui sont ensuite affinées dans un processus d’optimisation ultérieur pour obtenir la sortie étiquetée finale. Ces classificateurs apprennent les limites de décision statistique entre chaque classe d’objet dans l’espace des entités extraites de l’image, y compris la texture, l’histogramme des orientations de périphérie, les valeurs de couleur RVB et les coordonnées d’image normalisées. Une technique appropriée pour cela est implémentée dans la boîte à outils de machine learning de DARWIN10 et est décrite ci-dessous.

Protocole

L’approbation éthique de ce projet a été donnée par le numéro d’homologation du Comité d’éthique de l’Université catholique australienne #201500036E. Cela a veillé à ce que tous les participants aient obtenu le consentement éclairé et que tous les participants aient participé volontairement, et que les données des participants demeurent anonymes et confidentielles. En outre, l’approbation a été donnée en raison de la méthode et de l’équipement répondant aux normes australiennes de sécurité.

1. filmer des scènes urbaines qui peuvent être utilisées dans une étude de suivi des yeux

- Utilisez une caméra vidéo numérique de haute qualité attachée à une nacelle pour créer une vidéo simulée de «marche» ou de «séance».

- Enregistrez le film avec des mouvements fluides lisses en résolution 4k à 25 ips et sauvegardez-les à 1920 x 1080 HD.

- Utilisez une entreprise de tournage professionnelle pour produire des films numériques s’ils ne sont pas familiers avec ce ou manque d’accès à l’équipement.

- Filmer en une seule prise, à une seule longueur sur toutes les vidéos avec des itinéraires et des caractéristiques prédéfinis précis.

NOTE: exemple de détails vidéo: chaque film de marche simulé était de 3 min 50 s de long et chaque film de séance simulée était de 1 minute de long. Pour les deux vidéos de cette étude, les vidéos ont commencé par une courte montée d’escalier menant à un chemin. Le chemin a été suivi pour exactement 1 min 30 s, puis la caméra s’est arrêtée et a été déplacée à gauche pour 45-60 degrés et arrêté pendant 15 secondes. La caméra a ensuite continué le long du sentier pédestre jusqu’à ce que la marque de 3 min 25 s, a laissé 40-70 degrés à gauche pendant 15 secondes, a continué le long du chemin jusqu’à la marque 3 min 50 s, puis s’est évanouie en noir. - Assurez-vous que les films sont comparables, en d’autres termes, ils n’introduisent pas de nouvelles données de regard de différentes trajectoires de marche ou de mouvement de la caméra. Un film a été pris de chaque promenade, deux au total.

- Comme les mouvements oculaires sont touchés par le son, enregistrer un fichier de sons de parc urbain générique de l’une des promenades pour la même longueur de la vidéo sans interruptions de bruits soudains à l’extérieur du parc (par exemple, les alarmes de voiture). Cela peut être joué au lieu de la bande originale existante à partir des deux vidéos afin que l’impact visuel de la vidéo peut être isolé.

Remarque: un mouvement excessif des véhicules et d’autres objets peut affecter les mouvements oculaires et fausser les résultats. Si une partie de cette intrusion se produit, le film peut être joué aux participants, mais les trames peuvent devoir être exclues de l’analyse. - Si vous êtes intéressé par différentes activités dans une promenade, comme la marche et puis assis sur un banc, enregistrer ou modifier les scènes de séance et de marche comme des fichiers distincts afin de les tester indépendamment.

2. Configuration et calibrage du Bureau de l’équipement de repérage des yeux

- Montrez les séquences filmées à des personnes dans une pièce où la lumière naturelle peut être exclue pour éviter les reflets sur l’écran. Montrez-leur sur un écran aussi grand que possible d’occuper autant de champ visuel, évitant ainsi la distraction de l’extérieur du champ de vision. Un écran large (16:9) pour PC (22 pouces) avec des participants d’environ 60 cm à l’extérieur de la moustiquaire est une norme acceptable.

- Effectuez un étalonnage à l’écran pour chaque participant à l’aide de l’outil d’étalonnage intégré sur le logiciel de suivi des yeux. Exigez que les participants regardent une bille rouge se déplaçant autour de l’écran dans le cadre de ceci et s’arrêtant à 5 points d’étalonnage de clef.

- Pendant l’étalonnage, observez les participants et assurez-vous qu’ils ne bougent pas aussi bien la tête. Si elles sont trop près de l’écran et l’écran est très grand cela peut être un problème. Ajustez la distance de l’écran en conséquence.

- Modifiez chaque film pour avoir une croix blanche située dans le coin supérieur gauche des premières images de la vidéo. Cela peut être fait à l’aide d’un logiciel de montage vidéo. Montrez cet écran pendant 3 secondes, puis commencez à jouer la marche. Il s’agit de vérifier l’étalonnage de la détection des yeux et de s’assurer que les temps de collecte des données de suivi des yeux peuvent être appariés avec des numéros de trame individuels.

3. recrutement et éthique

- Utilisez une entreprise professionnelle de recrutement de recherche pour assurer une propagation de différents genres, âges et professions parmi l’échantillon ou de recruter sur le site parmi les étudiants et le personnel du corps.

- Les participants à l’écran pour les affections oculaires ou neurologiques connues et/ou les blessures. Il faut leur demander s’ils prennent des médicaments dont on sait qu’ils affectent les mouvements oculaires (p. ex. les benzodiazépines).

- Effectuez des tests de lecture à proximité de la vision et un test d’excursion à la torche à stylo pour démontrer qu’ils ont des excursions pleines de mouvement oculaire.

- Les participants au sondage sur leur âge, leur sexe et leur fréquence d’utilisation du parc.

4. Configuration expérimentale du participant

- Demandez aux participants d’imaginer qu’ils ont besoin de restauration. Utilisez une phrase qui leur permet d’imaginer le contexte de la vidéo de suivi des yeux utilisé comme: «Imaginez qu’il est midi et vous marchez seul à Melbourne. Vous êtes mentalement fatigué de la concentration intense au travail et sont à la recherche d’un endroit pour aller faire une promenade, s’asseoir et se reposer pendant un petit moment, avant de retourner au travail».

- Asseyez-vous confortablement devant l’écran de l’ordinateur à une distance de 60 – 65 cm pour visionner les films.

- En utilisant un tableur, commandez les films au hasard avant de jouer devant les participants.

- Utilisez des haut-parleurs pour jouer le même son pour tous les films.

- Enregistrez la trajectoire du regard des participants à l’aide d’un système de suivi des yeux de bureau. Montez le dispositif de repérage des yeux de bureau conformément aux instructions du fabricant. Cela pourrait être juste en dessous de l’écran sur une table, ou il pourrait clip sur le bord de l’écran, sur le dessus par exemple.

- Utilisez une unité de suivi des yeux qui a une fréquence d’échantillonnage de 120 Hz et une précision de 0,50 °, ce qui permet une grande liberté de mouvements de la tête permettant l’enregistrement pendant les mouvements de la tête naturelle. Une fréquence inférieure Eye-Tracker est également acceptable. À 57,3 cm, 1 ° d’angle visuel équivaut à ~ 1 cm sur l’écran.

- Permettez aux participants de regarder les séquences sur un moniteur en haute définition.

- Enregistrer les mouvements oculaires à l’aide du logiciel de suivi des yeux

- Employez un filtre de fixation pour convertir les données brutes d’échantillon d’oeil pour l’analyse. Dans le menu principal, cliquez sur outils ≫ paramètres. Sélectionnez l’onglet Filtres de fixation . Sélectionnez le filtre de fixation selon les spécifications du fabricant sur le meilleur type de filtre pour agréger les données brutes de suivi oculaire en fixations.

- Si vous enregistrez des données de suivi des yeux à l’aide de plusieurs films, accordez des pauses entre les sessions d’enregistrement chaque fois que les participants le demandent.

5. connexion des parcs consultés aux impressions des vidéos

- Comparez la mesure dans laquelle les gens ont vu les objets et leurs opinions sur les vidéos en demandant aux participants de noter chacun des parcs sur une échelle de 1 à 10, premièrement pour savoir s’ils estimaient qu’ils seraient en mesure de se reposer et de se rétablir dans cet environnement (1 , pas beaucoup, à 10, beaucoup) et deuxièmement combien ils ont aimé le parc (1, pas beaucoup, à 10, beaucoup).

- Demandez aux participants s’ils utiliseraient le parc pour se détendre ou soulager le stress (Y/N) et s’ils reconnaissaient le parc qu’ils rechercheraient (Y/N) pour contrôler l’impact potentiel d’une association antérieure avec le parc.

- Enregistrez les réponses brèves des participants afin d’expliquer leurs impressions à l’aide d’un enregistreur vocal, puis de les transcriter.

6. analyse vidéo automatique pour l’extraction de la zone d’intérêt

- Sélection des AOIs

- Choisissez les éléments qui intéressent les concepteurs de parcs, les concepteurs urbains, les planificateurs ou les architectes, tels que les arbres, les arbustes, les panneaux, les bâtiments, le gazon, les chemins, les marches, etc.

- Pour des performances optimales et des exigences de formation minimales (discutées plus loin ci-dessous), utilisez des éléments qui se distinguent facilement visuellement les uns des autres à l’œil nu, et/ou occupent systématiquement différentes régions de chaque trame vidéo. En général, des exemples de formation suffisants illustrant les différences visuelles de chaque AOI devraient suffire à des performances robustes.

- Classificateurs d’entraînement pour l’extraction d’AOI

- Sélection des cadres de formation à utiliser, nombre et justification

- Choisissez un nombre approprié de cadres de formation (ci-après dénommés le jeu de formation). Il n’y a pas de nombre fixe approprié.

Remarque: les trames doivent fournir une couverture suffisante de la gamme d’aspect visuel de chaque classe d’objet (c.-à-d., ces objets à étiquetter) tout au long de la vidéo. Par exemple, 40 trames d’une séquence vidéo de trame 15 000 représentant une scène de parc unique ont été trouvées pour obtenir une précision suffisante. Si une séquence contient des variations significatives tout au long de ce temps, plusieurs trames peuvent être requises. - Considérez le contenu du cadre lors du choix des cadres d’entraînement. Ceux-ci comprennent: l’éclairage, les formes en ce qui concerne ce qui est classé (par exemple, pas seulement un type d’arbre, mais une gamme de types d’arbres, leur position dans l’image, la façon dont ils sont éclairés, etc.), la texture et la couleur.

- Considérez également le nombre de trames à inclure. Plus précisément, la longueur et la variation des conditions visuelles exposées à travers la vidéo en cours d’analyse, ainsi que le nombre de classes d’objets à identifier, et la fréquence de leur apparence.

- Choisissez un nombre approprié de cadres de formation (ci-après dénommés le jeu de formation). Il n’y a pas de nombre fixe approprié.

- Étiquetage manuel des pixels pour les cadres d’entraînement

Remarque: l’étiquetage manuel des cadres d’entraînement associera les pixels aux classes d’objets d’intérêt.- Étiquetage pixel des cadres d’entraînement

- À son tour, ouvrez chaque cadre d’entraînement à partir de la vidéo dans le logiciel de retouche d’image.

- Pour chaque cadre d’entraînement de la vidéo, superposez une couche d’image transparente sur l’image chargée pour l’étiquetage et créez une palette de couleurs, en fournissant une couleur pour chaque classe d’objet donnée d’intérêt (c.-à-d., AOI).

- Assurez-vous que la palette de couleurs et le mappage des couleurs aux classes d’objets sont identiques tout au long du processus d’étiquetage.

- Sélectionnez la couleur de l’exemple d’AOI.

- Les régions de couleur de l’échantillon AOIs en sélectionnant, avec un clic de souris et de glisser, les pixels dans la zone de «couleur dans» en utilisant le choix de palette approprié.

Remarque: il est possible de colorer les objets volumineux de manière imprécise. Toutefois, pour les objets étroits/petits de seulement quelques pixels de largeur, prendre plus de soin pour s’assurer que l’étiquetage manuel capte avec précision l’aspect visuel de l’objet. - Une fois l’étiquetage d’un cadre terminé, exportez la couche superposée en tant que fichier image distinct. Assurez-vous que le nom du fichier de base correspond au nom du fichier de base de la trame d’origine, mais avec un «c» ajouté à la fin. Par exemple, si le nom de fichier de la trame d’origine était «1234. png», alors l’étiquette de la couche étiquetée doit être «1234c. png».

- Assurez-vous que toutes les images étiquetées sont stockées dans un seul dossier.

-

Étiquetage pixel des trames de validation

Remarque: pour valider quantitativement la précision du classifieur formé, un ensemble supplémentaire de trames étiquetées doit être créé.- Sélectionnez les images de la séquence vidéo d’origine qui n’ont pas déjà été choisies pour être incluses dans le jeu d’entraînement. Pour une vidéo de 5 minutes, ils ne doivent pas être plus de 20 images, mais doivent être échantillonnés uniformément à travers la séquence vidéo pour assurer une couverture suffisante.

- Étiqueter les pixels dans chaque trame en utilisant la même procédure que celle décrite pour la préparation des cadres d’entraînement (6.2.2). Cependant, cette fois-ci être aussi précis et aussi complet que possible avec l’étiquetage car il sera utilisé comme une comparaison de la vérité au sol.

- Lorsque l’étiquetage d’un cadre est terminé, utilisez la même convention d’appellation que pour la formation, mais assurez-vous que les fichiers sont enregistrés dans un dossier de trames de validation distincte.

- Étiquetage pixel des cadres d’entraînement

- Étiquetage automatique des pixels de la séquence vidéo

- Téléchargez la bibliothèque logicielle DARWIN à partir de http://drwn.anu.edu.au.

Remarque: le système décrit dans ce document a été implémenté dans un environnement Linux, et donc la version Linux de DARWIN doit être téléchargée et installée, en suivant les instructions du site Web. - Lancez l’interface graphique Darwin

- Dans l’interface graphique de Darwin, cliquez sur charger les étiquettes de formation.

- À l’aide de la boîte de dialogue Explorateur de fichiers qui s’affiche, sélectionnez le dossier contenant les images d’apprentissage marquées pour la séquence vidéo pertinente.

- Cliquez sur charger les images vidéo et suivez la même procédure que 6.2.3.2 pour sélectionner le dossier contenant tous les cadres originaux de la séquence vidéo. Il doit s’agir d’un dossier d’images, dans lequel chaque nom de fichier de trame est le numéro de cette trame dans la séquence vidéo (par exemple, Frame 1234 serait nommé 1234. png)

- Cliquez sur le bouton train . L’algorithme examinera désormais chaque cadre d’apprentissage étiqueté et apprendront un modèle d’apparence pour classer les pixels dans l’une des classes d’objets spécifiées.

- Téléchargez la bibliothèque logicielle DARWIN à partir de http://drwn.anu.edu.au.

- Validation du classifieur formé

- Une fois la formation terminée, cliquez sur le bouton valider la formation .

- À l’aide de la boîte de dialogue Explorateur de fichiers, sélectionnez le dossier contenant toutes les images de validation étiquetées pour la séquence vidéo pertinente. Le classifieur formé sera maintenant utilisé pour classer les pixels dans chacune des trames mentionnées dans le jeu de validation. Comparez ceci aux étiquettes de vérité de sol fournies dans le dossier de validation.

Remarque: une fois terminé, l’interface graphique affichera les statistiques de précision, y compris le pourcentage de pixels correctement étiquetés pour chaque image dans le jeu de validation, ainsi que sur l’ensemble de la validation. - Pour valider visuellement les étiquettes générées, cliquez sur le bouton validation visuelle . Si vous cliquez dessus, chaque image marquée générée est affichée à côté de la trame de validation d’origine.

NOTE: Ceci peut être instructif pour identifier où les erreurs de classification se produisent sur l’objet. Par exemple, l’inspection visuelle peut indiquer que des erreurs se produisent systématiquement dans une partie particulière d’une classe d’objets, ce qui suggère une amélioration de l’étiquetage dans l’ensemble de formation est nécessaire. Alternativement, l’inspection peut montrer que des erreurs se produisent seulement à un moment particulier dans la vidéo, suggérant plus d’exemples de formation sont exigés de cette période de temps dans la vidéo. - Si la précision observée dans la validation quantitative ou qualitative est inférieure à des niveaux acceptables, il convient d’inclure d’autres exemples de formation. Dans ce cas, répétez toutes les étapes de la 6.2.2 pour inclure des cadres d’entraînement supplémentaires, réentraînez le classifieur suivant les étapes de la 6.2.3 et validez à nouveau les étapes suivantes dans 6.2.4.

- Étiquetage des pixels vidéo

- Une fois la phase de formation et de validation du classifieur terminée, cliquez sur cadres d’étiquettes sur l’interface graphique de Darwin pour commencer l’étiquetage complet de toutes les images de la séquence vidéo à l’aide du classifieur formé.

- Suivez l’invite pour sélectionner un dossier de destination pour toutes les trames de sortie, qui se présente sous la forme d’images étiquetées à l’aide de la même palette de couleurs que celle utilisée dans la formation.

- Sélection des cadres de formation à utiliser, nombre et justification

7. enregistrement des données de suivi des yeux sur le contenu vidéo

- Dans le logiciel de suivi des yeux, cliquez sur fichier ≫ Export... Exportez le fichier de suivi des yeux en tant que fichier CSV.

- Ouvrez le fichier dans un tableur.

- À partir de la séquence vidéo, identifiez l’heure à laquelle la croix blanche en haut à gauche du cadre (voir 2,3) disparaît. Utilisez cette heure pour identifier le suivi des yeux en utilisant la colonne pertinente sur le résultat de suivi des yeux. C’est le début de la collecte de données de suivi des yeux.

- Ajoutez une colonne aux données de suivi des yeux.

- L’utilisation de cette nouvelle étiquette de colonne chaque ligne ou point de données de suivi des yeux avec un numéro de trame commençant au numéro 1.

8. affichage du laps de temps pendant lequel les participants ont examiné différentes classes d’objets dans les vidéos

Remarque: en raison de l’énorme taille des données de suivi des yeux, le langage de programmation Python est mieux utilisé pour les étapes jusqu’à 8,4, bien qu’un programme de traitement des données peut également être utilisé.

- En utilisant le code python inclus, calculez la quantité de chevauchement entre les objets d’intérêt et le temps et la fréquence de fixation du suivi oculaire.

- Additionnez ces données pour comprendre le laps de temps que les participants ont passé à examiner différents objets.

- Employez un histogramme pour montrer la quantité totale de temps que les objets occupaient l’écran.

- Comparez cela avec la quantité totale de temps que les participants ont regardé différents objets.

- Pour produire une carte thermique dans le logiciel de suivi des yeux, cliquez sur l’une des vidéos de marche du parc à l’aide de la case à cocher.

- Cliquez sur l’onglet carte thermique .

- Ajustez la couleur et les autres caractéristiques de la carte thermique comme désiré en utilisant les variables de’Count' (nombre total de fixations effectuées sur la fenêtre de temps), 'durée absolue' (durée de fixation cumulée) et’durée relative' (le temps passé à regarder un l’objet divisé par le temps passé à regarder une scène).

- Exportez l’image ou la vidéo qui inclut la carte de densité en tant que fichier JPEG ou fichier vidéo.

Résultats

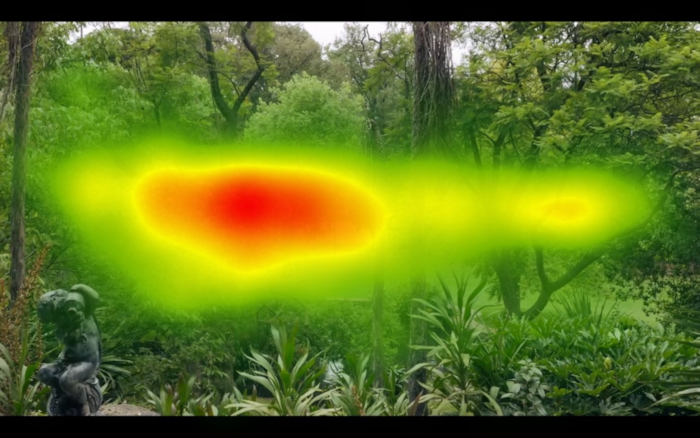

La figure 1 et la figure 2 montrent le résultat de la prise de toutes les données de suivi oculaire pour l’ensemble de la vidéo sur tous les participants et la production d’une carte de chaleur; C’est l’approche standard disponible dans les progiciels de suivi des yeux. En comparant la figure 1 et la figure 2 , il est possible d’identifier que les participants moyens scannés à gauche et à droite sur la coordonnée x de la vidéo dans la figure 1 par rapport à la figure 2, qui montre une forme plus ronde. C’est parce que la figure 1 avait plus d’éléments horizontaux tout au long de la vidéo par rapport au parc dans la figure 2. L’image derrière la carte de chaleur est une trame unique et ne représente pas adéquatement le contenu complet de la vidéo.

Le système de suivi des yeux de bureau et le logiciel ne compte que les résultats où les deux yeux peuvent être localisés en même temps. En d’autres termes, si un ou les deux yeux ne peuvent pas être localisés, les données sont comptabilisées comme perdues. Dans notre cas, les données de suivi des yeux ont été capturées pour > 80% du temps.

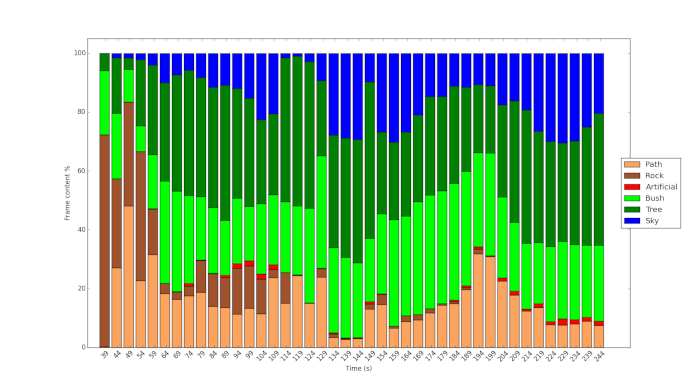

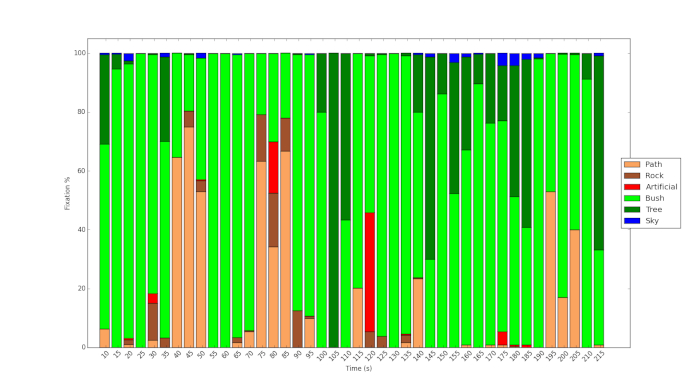

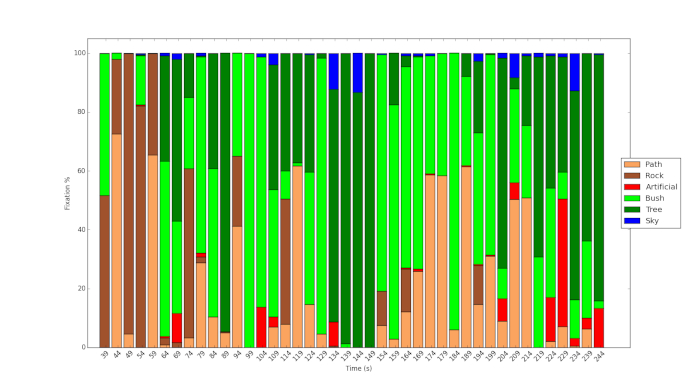

La figure 3 et la figure 4 montrent le résultat de l’utilisation du protocole et de l’utilisation de l’apprentissage automatique pour analyser le contenu des vidéos. La figure 3 montre la végétation dense des jardins de Fitzroy par rapport à la végétation relativement clairsemée du parc Royal (figure 4). Dans ce dernier, plus de ciel est visible, plus de scènes sont dominées par la végétation arbustive. La figure 5 montre le temps de fixation% sur les différents objets au cours de la vidéo pour l’un des participants. Il montre que bien que le chemin est clairement visible au cours de la vidéo, le participant ne regarde que cette fonction occasionnellement, mais à des points clés. De même, comme le montre la figure 6 , bien qu’une infime fraction du contenu de la vidéo dans le parc Royal se rapporte à des objets artificiels, le participant à l’étude examine ces caractéristiques dans une relativement grande mesure.

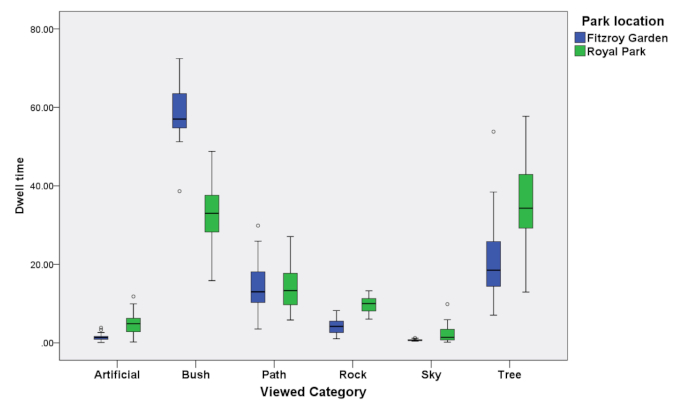

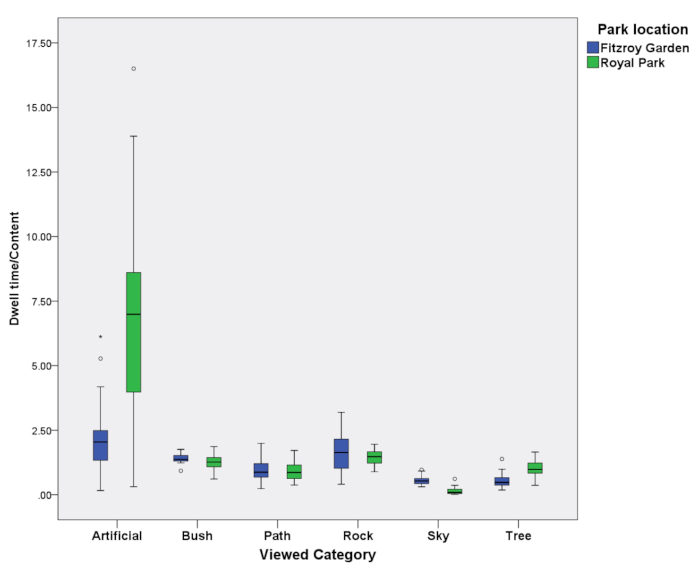

Les résultats de la figure 3, de la figure 4, de la figure 5et de la figure 6 peuvent être résumés à la figure 7 et à la figure 8 pour tous les 39 participants dont les données ont été utilisées dans cette étude. La figure 7 montre le temps de pause pour tous les participants lors de la recherche d’objets pendant toute la durée de la vidéo. La figure 8 montre ces mêmes données divisé par la quantité de temps et d’espace que ces différents objets occupés dans la vidéo. Une valeur de 1 indique que le temps de pause peut être comptabilisé par la quantité d’objet dans la vidéo. La figure 7 montre que les objets artificiels, tels que les lampadaires et les bancs, sont plus largement comparés à d’autres objets (> 1). La figure 7 montre également que les objets qui étaient moins pertinents, comme le ciel dans les deux images, ont été vus comparativement moins (< 1).

Figure 1: exemple de carte de chaleur produite pour l’ensemble de la vidéo d’un des parcs. Cela montre où se trouvaient la majorité des traces oculaires. Notez la forme horizontale de la carte thermique en raison de la dominance des éléments horizontaux dans la vidéo. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Figure 2: exemple de carte de chaleur qui est produite pour l’ensemble de la vidéo d’un autre des parcs. Notez la forme plus arrondie en raison de la présence d’éléments verticaux et horizontaux dans la vidéo. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Figure 3: histogramme du contenu de la vidéo de Fitzroy Gardens analysé à l’aide de la technique d’apprentissage automatique. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Figure 4: histogramme du contenu de la vidéo de Royal Park analysé à l’aide de la technique d’apprentissage automatique. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Figure 5: temps de fixation de suivi des yeux passé à regarder des objets dans les jardins Fitzroy. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Figure 6: temps de fixation de suivi des yeux passé à regarder des objets dans le parc Royal. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Figure 7: temps de maintien agrégé des yeux pour tous les participants et tous les objets des deux parcs. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Figure 8: temps d’arrêt agrégé du suivi des yeux par rapport au contenu de tous les participants et objets pour les deux parcs. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Discussion

Généralement, dans les progiciels standard pour l’analyse des données de suivi oculaire, un vecteur AOI est utilisé. Même pour une seule image fixe, la taille du vecteur ne peut pas être facilement mesurée. En outre, y compris tous les AOIs dans une image et le calcul des quantités relatives d’AOIs est laborieux. Il est presque impossible de le faire manuellement sur une vidéo sans une technique d’apprentissage machine telle que celle décrite. Il s’agit d’une déclaration relativement simple qui déduit une situation de visionnement libre. Un scénario beaucoup plus précis peut être utilisé et des descriptions de scénarios différentes avant le même stimulus peuvent également affecter les mouvements oculaires11.

Notre recherche a utilisé une méthode pour classer avec précision les objets dans une vidéo et analyser la mesure dans laquelle celles-ci étaient visibles à l’œil. La méthode représente un moyen de comptabilisation de la mesure dans laquelle les mouvements oculaires sont liés à des objets d’intérêt. Cela permet de déterminer dans quelle mesure les objets d’intérêt sont présents dans un champ de vision à contrôler lors de la comparaison du suivi des yeux de différents sujets avec un dispositif mobile de suivi des yeux, ou des emplacements différents lors de l’utilisation d’un système basé sur le bureau. Les considérations qui peuvent affecter la classification automatique des objets à l’aide de l’apprentissage machine que nous employons comprennent l’éclairage, les formes par rapport à ce qui est classifié (par exemple , pas seulement un type d’arbre, mais une gamme de types d’arbres, leur position dans le l’image, la façon dont ils sont allumés, etc.), la texture et la couleur. Les considérations sur le nombre de trames comprennent la longueur et la variation des conditions visuelles exposées à travers la vidéo analysée, ainsi que le nombre de classes d’objets à identifier et la fréquence de leur apparition. Les trames changent toutes les 1/25 secondes, mais le suivi des yeux avec le logiciel se produit à 1/120 (120 Hz). Pour cette raison, les données de suivi des yeux seront collectées à 4,8 fois le taux auquel une nouvelle trame apparaît. Il n’est pas possible d’étiqueter entièrement avec précision, mais l’étiquetage des cadres devrait changer tous les 5 fois. Par exemple, les données de suivi oculaire pendant 99 à 101 s ont été prises en compte pour le cadre de la 100ème seconde de la vidéo.

Un avantage significatif des paquets actuels de suivi des yeux est qu’ils sont mis en place pour permettre aux utilisateurs de revoir un film de leurs propres fixations de suivi des yeux et des voies et de décrire pourquoi ils ont regardé certains objets. Il en résulte un ensemble de données qualitatives qui peut révéler pourquoi les sujets individuels pensent qu’ils ont examiné certains objets. Une extension du projet serait de leur montrer aussi le temps qu’ils passaient à regarder des objets à des moments différents par rapport au contenu, par exemple les informations de la figure 8. Cependant, ce faisant, en contrôlant le nombre d’objets dans une scène assez rapidement n’est actuellement pas possible.

Par exemple, on pourrait demander aux participants de voir leurs propres voies de regard qui avaient été enregistrées et de décrire pourquoi ils avaient examiné les objets particuliers12. Dans notre cas, à la fin de chaque film, les participants ont été invités à évaluer chacun des parcs sur une échelle de 1-10, premièrement pour savoir s’ils estimaient qu’ils seraient en mesure de se reposer et de se rétablir dans cet environnement (1, pas beaucoup, à 10, beaucoup) et deuxièmement combien ont-ils aimé le Parc (1, pas beaucoup, à 10, beaucoup).

Déclarations de divulgation

aucun

Remerciements

Ce travail a été financé financièrement par la ville de Melbourne et en partie par l’ARC DP 150103135. Nous aimerions remercier Eamonn Fennessy pour son Conseil et son approche collaborative. Avec des remerciements particuliers aux assistants chercheurs Isabelle Janecki et Ethan Chen qui ont également aidé à collecter et à analyser ces données. Toutes les erreurs demeurent les auteurs.

matériels

| Name | Company | Catalog Number | Comments |

| 12 mm lens | Olympus | Lens | |

| Panasonic GH4 | Panasonic | Video Camera | |

| Tobii Studio version (2.1.14) | Tobii | Software | |

| Tobii x120 desktop eye-tracker | Tobii | Eye-tracker |

Références

- Patrik, P., Stigsdotter, U. K. The relation between perceived sensory dimensions of urban green space and stress restoration. Landscape and Urban Planning. 94 (3-4), 264-275 (2010).

- Bjørn, G., Patil, G. G. Biophilia: does visual contact with nature impact on health and well-being?. International Journal of Environmental Research and Public Health. 6 (9), 2332-2343 (2009).

- Velarde, M. a. D., Fry, G., Tveit, M. Health effects of viewing landscapes-Landscape types in environmental psychology. Urban Forestry & Urban Greening. 6 (4), 199-212 (2007).

- Polat, A. T., Ahmet, A. Relationships between the visual preferences of urban recreation area users and various landscape design elements. Urban Forestry & Urban Greening. 14 (3), 573-582 (2015).

- Peter, P., Giannopoulos, I., Raubal, M. Where am I? Investigating map matching during self-localization with mobile eye tracking in an urban environment. Transactions in GIS. 18 (5), 660-686 (2014).

- Berto, R., Massaccesi, S., Pasini, M. Do Eye Movements Measured across High and Low Fascination Photographs Differ? Addressing Kaplan's Fascination Hypothesis. Journal of Environmental Psychology. 28 (2), 185-191 (2008).

- Kaplan, S. The restorative benefits of nature: Towards an integrative framework. Journal of Environmental Psychology. 15, 169-182 (1995).

- Duchowski, A. T. . Eye Tracking Methodology: Theory and Practice. , (2017).

- Amati, M., Ghanbari Parmehr, E., McCarthy, C., Sita, J. How eye-catching are natural features when walking through a park? Eye- tracking responses to videos of walks?. Urban Forestry and Urban Greening. 31, 67-78 (2018).

- Gould, S. D. A. R. W. I. N. A Framework for Machine Learning and Computer Vision Research and Development. Journal of Machine Learning Research. (Dec), 3533-3537 (2012).

- Richardson, D., Matlock, T. The integration of figurative language and static depictions: an eye movement study of fictive motion. Cognition. 102 (1), 129-138 (2007).

- Bojko, A. . Eye Tracking the User Experience: A Practical Guide to Research. , (2013).

Réimpressions et Autorisations

Demande d’autorisation pour utiliser le texte ou les figures de cet article JoVE

Demande d’autorisationThis article has been published

Video Coming Soon