Method Article

Die Kombination von Eye-Tracking-Daten mit einer Analyse von Video-Inhalten aus dem Free-Viewing eines Videos von einem Walk in einer urbanen Park-Umgebung

In diesem Artikel

Zusammenfassung

Ziel des Protokolls ist es, detailliert darzulegen, wie Videodaten für den Einsatz im Labor gesammelt werden können; Wie man die Daten der Teilnehmer, die sich die Daten ansehen, aufzeichnet und wie man den Inhalt der Videos, die sie mit Hilfe einer maschinellen Lerntechnik betrachten, effizient analysiert.

Zusammenfassung

Da Individuen zunehmend in Städten leben, werden Methoden, um ihre Alltagsbewegungen zu studieren, und die Daten, die gesammelt werden können, werden wichtig und wertvoll. Eye-Tracking Informatiker sind dafür bekannt, dass sie sich mit einer Reihe von Gefühlen, gesundheitlichen Bedingungen, psychischen Zuständen und Handlungen verbinden. Aber weil das Sehen das Ergebnis ständiger Augenbewegungen ist, ist das Ausreißen des Wichtiges aus dem, was Lärm ist, komplex und datenintensiv. Darüber hinaus besteht die Kontrolle darüber, was die Menschen im Vergleich zu dem, was ihnen präsentiert wird, zu kontrollieren.

Im Folgenden finden Sie eine Methodik zur Kombination und Analyse von Eye-Tracking auf einem Video einer natürlichen und komplexen Szene mit einer maschinellen Lerntechnik zur Analyse des Inhalts des Videos. Im Protokoll geht es um die Analyse von Daten von gefilmten Videos, wie ein Video am besten verwendet werden kann, um die Eye-Tracking-Daten der Teilnehmer aufzuzeichnen, und wie der Inhalt des Videos analysiert und mit den Eye-Tracking-Daten kombiniert werden kann. Wir präsentieren eine kurze Zusammenfassung der Ergebnisse und eine Diskussion über das Potenzial der Methode für weitere Studien in komplexen Umgebungen.

Einleitung

Unsere täglichen Erfahrungen in urbanen Umgebungen haben großen Einfluss auf unsere Gesundheit und unser Wohlbefinden. Unser Wohlbefinden kann von der Menge der Grünflächen abhängen, die wir1,2,3sehen und erleben, und diese Ansichten können mit Hilfe von Eye-Tracking-Geräten quantifiziert werden, um die Entscheidungsfindung über das Parkdesign zu bestimmen. Ein Problem stellt sich jedoch mit dem Umfang der Eye-Tracking-Daten, die generiert werden und die für diese Daten sinnvoll sind. Da die Geräte zur Erfassung von Blickdaten in einem Labor oder in einer natürlichen Umgebung einfacher zu bedienen und leistungsfähiger werden, müssen die Forscher überlegen, wie wir Daten wirksam sammeln und analysieren können, um bei Entscheidungsfragen zu helfen.

Bisher hat eine große Menge Eye-Tracking-Recherchen Fotos in einer Befragung oder Laboreinstellung4verwendet. Diese Methodik ermöglicht zwar eine große Reproduzierbarkeit und Kontrolle über die Ergebnisse, ist aber nicht in der Lage, die neuesten Fortschritte in der Eye-Tracking-Technologie zu nutzen, zu der der Einsatz von Video und tragbaren mobilen Eye-Trackern gehört. Darüber hinaus würden wir argumentieren, dass der Akt des Gehens und Entspannens notwendigerweise dynamisch ist, besonders wenn er sich an einer Aufgabe wie der Wegeunterstellung5orientiert. Daher sollte ein vollständig wissenschaftliches Verständnis dieser Einstellungen außerhalb des Labors stattfinden. Im Moment jedoch macht die Eye-Tracking in einem realen naturalistischen Rahmen den Vergleich der Erfahrungen zwischen den Themen sehr schwierig. Wenn wir zum Beispiel vergleichen wollten, ob ein Befragter mehr als ein anderer auf Bäume schaut, wie könnten wir dann kontrollieren, dass sich ihr Standpunkt im Vergleich zu anderen ständig ändern würde oder dass sich ihr Kopf gewendet hätte. Eine detaillierte Analyse unter diesen Bedingungen ist mit aktuellen Analysetechniken nahezu unmöglich. Wir würden argumentieren, dass es wichtig ist, die Sichtbereiche zu kontrollieren, die dem untersuchten Individuum zur Verfügung stehen, und in der Analyse in der Lage zu sein, die Gesamtszene, die zu einem bestimmten Zeitpunkt betrachtet wird, zu berücksichtigen.

Es gibt eine Reihe von Theorien, die Stresslevel und Sicherheitswahrnehmungen mit Landschaftsansichten und gutentwickelten Messgrößen von Stress 6,7verbinden. Es gab auch einen rasanten Anstieg der Raffinesse der Eye-Tracking-Geräte, um den Blick8zu messen. Eye-Tracking ist wichtig, weil unfreiwillige Augenbewegungen zuverlässiger mit Präferenz, Stress und anderen traditionellen Messungen verbunden sein können als Umfragen und aufdringliche, physiologische Tests wie Speichelkortisolspiegel. Ziel dieser Forschung ist es, Werkzeuge zu entwickeln, die eine präzisere Messung von Eye-Tracking-Daten ermöglichen, die auf naturalistischere Umgebungen angewendet werden, um weitere Beweise für langjährige Landschaftstheorien zu liefern oder zu widerlegen, die die Gestaltung des Parks informiert haben. Jahrzehnten.

Ziel des Projektes ist es, eine neuartige Analysetechnik zu entwickeln und zu testen, die für verschiedene Videos von Park-Walking-Simulationen relevante Eye-Tracking-Daten generieren kann. Unsere Arbeit, die hier und anderswo berichtet wird9 , stellt einen halben Punkt zwischen der naturalistischen Einstellung eines vollmobilen Eye-Tracking-Systems und den oben erwähnten labbasierten Fotostudien dar. Wir konzentrieren uns vor allem darauf, Videos als Reizstoff zu verwenden und zu untersuchen, wie dieses Material genutzt werden kann, um die Faszination zu testen, die verschiedene Parks in der Stadt Melbourne erzeugen. Unsere Arbeit basiert auf der Annahme, dass eine detaillierte Analyse von Videos ein notwendiger Schritt ist, um zu brechen, bevor wir eine umfassendere, naturalistischere Bewertung des Potenzials von Parks, um Wiederherstellung von Stress zu ermöglichen.

In dieser Studie haben wir einen Desktop-Eye-Tracker mit Videos von Spaziergängen durch Stadtparks eingesetzt und die Teilnehmer gebeten, sich vorzustellen, dass sie einen entspannten Spaziergang durch einen Park machen. Wir beschreiben eine Methode, mit der die Zeit, die die Teilnehmer damit verbrachten, verschiedene Objekte zu betrachten, zwischen Parks vergleichbar ist. Desktopstudien sind im Vergleich zu mobilen ET-Studien in der Regel leichter zu kontrollieren und erlauben eine vergleichende Analyse der einzelnen Fäbanten.

Die Standard-Eye-Tracking-Software verwendet ein manuelles Tool, in dem ein Bediener manuell Grenzen um Objekte ziehen kann, die für jede Szene von Interesse sind. So kann automatisch gezählt werden, wie viel Zeit die Teilnehmer damit verbrachten, verschiedene Objekte zu betrachten. Bei Videodaten ist dieser Prozess arbeitsintensiv und unterliegt der Subjektivität und dem Irrtum des Betreibers. In späteren Versionen der Eye-Tracking-Analyse-Software können AOIs Objekte automatisch über Frames verfolgen, wenn sie im Video die gleiche Größe haben. Das ist eine Verbesserung, aber dies ist nur für eine kleine Anzahl von Reizen in jedem Bild gedacht und jedes Bild muss überprüft und bestätigt werden.

Die manuelle Kennzeichnung von Objekten in einem Bild ist üblich und wird durch Bildbearbeitungssoftware wie GNU Image Manipulation Program (GIMP) unterstützt. Da 1 s 30 Bilder oder Bilder produziert, ist die manuelle Kennzeichnung von Videos unpraktisch. Darüber hinaus ist die AOI-Kennzeichnung durch das Zeichnen von Vektorpolygonen am Rand komplexer Objekte wie Baumkronen sehr zeitaufwendig. Schließlich ist es zwar denkbar, die Größe von Objekten in einem Sichtfeld mit Vektorkennzeichnung zu berechnen, aber diese Funktion ist derzeit nicht verfügbar.

Die Methode, über die wir unten berichten, befasst sich mit diesen Einschränkungen. In dieser Studie wurde die automatische Kennzeichnung von Objekten verwendet. Möglich wird dies mit einer Bildbearbeitungstechnik, die als semantische Beschriftung bekannt ist, bei der jedem Pixel in jedem Rahmen des Videos ein Etikett zugewiesen wird, das eine Objektklasse anzeigt. Maschinelles Lernen wird verwendet, um Pixelklassiker für jede Objektklasse von Interesse abzuleiten. Diese Klassifizierer bieten für jedes Pixel (als unary Potentials bekannt) ein probabilistisches Etikett, das dann in einem anschließenden Optimierungsprozess verfeinert wird, um die Endbeschriftung zu erreichen. Diese Klassifikatoren lernen statistische Entscheidungsgrenzen zwischen den einzelnen Objektklassen im Raum der aus dem Bild gewonnenen Funktionen, einschließlich Textur, Histogramm der Kantenorientierung, RGB-Farbwerte und die normalisierten Bildkoordinaten. Eine entsprechende Technik dafür ist in der DARWIN-Maschinenlernwerkskaufstelle10 implementiert und wird im Folgenden beschrieben.

Protokoll

Die Ethikkommission der Australischen Katholischen Universität hat für dieses Projekt eine ethische Genehmigung erteilt-die Zustimmungsnummer #201500036E. Dies sorgte dafür, dass von allen Teilnehmern eine informierte Einwilligung eingeholt wurde und alle Teilnehmer freiwillig teilnahmen und die Daten der Teilnehmer anonym und vertraulich blieben. Darüber hinaus wurde die Genehmigung aufgrund der Methode und der Ausrüstung nach den australischen Normen Sicherheitsvorschriften erteilt.

1. Filmen urbane Szenen, die in einer Augenverfolgungsstudie verwendet werden können

- Verwenden Sie eine hochwertige digitale Videokamera, die an einem Gimbal befestigt ist, um ein simuliertes "Gehen" oder "Sitzen"-Video zu erstellen.

- Nehmen Sie den Film mit glatten Flüssigkeitsbewegungen in 4k-Auflösung bei 25 fps auf und speichern Sie sie bei 1920 x 1080 HD.

- Verwenden Sie ein professionelles Filmunternehmen, um digitale Filme zu produzieren, wenn sie mit diesem nicht vertraut sind oder keinen Zugang zu Geräten haben.

- Schießen Sie Film in einer Aufnahme, auf eine einzige Länge über alle Videos mit genau vordefinierten Routen und Eigenschaften.

Hinweis: Beispiel-Video-Details: Jeder simulierte Walk-Film war 3 min 50 s lang und jeder simulierte Sitzfilm war 1 Minute lang. Für beide Videos in dieser Studie starteten die Videos mit einer kurzen Treppe, die zu einem Pfad führte. Der Weg wurde für genau 1 min 30 s verfolgt und dann stoppte die Kamera und schwenkte für 45-60 Grad nach links und hielt für 15 Sekunden. Die Kamera setzte sich dann auf dem Gehweg fort, bis die 3 min 25s-Marke, die für 15 Sekunden nach 40-70 Grad gedreht wurde, den Weg bis zur 3 min 50-Marke fortsetzte und dann zu schwarz verblasste. - Sorgen Sie dafür, dass die Filme vergleichbar sind, das heißt, sie führen keine neuartigen Blickdaten aus unterschiedlichen Laufbahnen oder Kamerabewegungen ein. Von jedem Spaziergang wurde ein Film gemacht, von einem insgesamt zwei.

- Wenn Augenbewegungen durch den Klang beeinflusst werden, nehmen Sie eine Datei von generischen städtischen Park Geräusche von einem der Spaziergänge für die gleiche Länge des Videos ohne Unterbrechungen von plötzlichen lauten Geräuschen außerhalb des Parks (z.B. Autoalarme). Diese kann anstelle des vorhandenen Soundtracks aus beiden Videos abgespielt werden, so dass die visuelle Wirkung des Videos isoliert werden kann.

Achtung: Übermäßige Bewegung von Fahrzeugen und anderen Objekten kann die Augenbewegungen beeinflussen und die Ergebnisse verzerren. Wenn ein Teil dieser Eindringlichkeit auftritt, kann der Film an die Teilnehmer gespielt werden, aber die Rahmen müssen möglicherweise von der Analyse ausgeschlossen werden. - Wenn Sie sich für verschiedene Aktivitäten in einem Spaziergang interessieren, wie zum Beispiel zu Fuß und dann auf einer Bank sitzen, speichern oder bearbeiten Sie die Sitz-und Wanderszenen als separate Dateien, um sie selbstständig zu testen.

2. Einrichtung und Desktop-Kalibrierung der Eye-Tracking-Geräte

- Zeigen Sie die gefilmten Sequenzen Individuen in einem Raum, in dem natürliches Licht ausgeschlossen werden kann, um Reflexionen auf dem Bildschirm zu vermeiden. Zeigen Sie ihnen auf einem möglichst großen Bildschirm, um so viel des Gesichtsfeldes zu besetzen und so Ablenkung von außen zu vermeiden. Ein Breitbildschirm (16:9) PC-Monitor (22 Zoll) mit Teilnehmern etwa 60 cm vom Bildschirm entfernt ist ein akzeptabler Standard.

- Führen Sie für jeden Teilnehmer eine Kalibrierung auf dem Bildschirm durch, indem Sie das eingebaute Kalibrierungs-Tool auf der Eye-Tracking-Software verwenden. Verlangen Sie die Teilnehmer, sich eine rote Kugel anzusehen, die sich als Teil davon um den Bildschirm bewegt und an 5 Schlüssel-Kalibrierpunkten anhält.

- Bei der Kalibrierung beobachten die Teilnehmer und sorgen dafür, dass sie auch nicht den Kopf bewegen. Wenn sie zu nah am Bildschirm sind und der Bildschirm sehr groß ist, kann das ein Problem sein. Passen Sie den Abstand vom Bildschirm entsprechend an.

- Bearbeiten Sie jeden Film mit einem weißen Kreuz in der linken oberen Ecke der frühen Rahmen des Videos. Dies kann mit einer Videobearbeitungssoftware geschehen. Zeigen Sie diesen Bildschirm für 3 Sekunden, dann beginnen, den Spaziergang zu spielen. Damit soll die Eye-Tracking-Kalibrierung überprüft und sichergestellt werden, dass die Eye-Tracking-Datenerfassungszeiten mit individuellen Frame-Nummern übereinstimmen können.

3. Rekrutierung und Ethik

- Nutzen Sie eine professionelle Forschungsaufstellungsanstalt, um die Verbreitung verschiedener Geschlechter, Altersgruppen und Berufe unter der Stichprobe zu gewährleisten oder vor Ort unter der Studenten-und Personalbehörde zu rekrutieren.

- Bildschirmteilnehmer wegen bekannter okularer oder neurologischer Erkrankungen und/Verletzungen. Sie müssen gefragt werden, ob sie Medikamente einnehmen, von denen bekannt ist, dass sie die Augenbewegungen beeinflussen (z.B. Benzodiazepine).

- Führen Sie in der Nähe von Sehstörungen und einem Tauchlackelaugen-Bewegung-Test, um zu zeigen, dass sie volle Augenbewegungsausflüge haben.

- Befragung der Teilnehmer über ihr Alter, Geschlecht und Häufigkeit der Parkanutzung.

4. Participant Experimental Setup

- Fragen Sie die Teilnehmer, sich eine Restaurierung vorzustellen. Verwenden Sie einen Satz, der es ihnen erlaubt, sich den Kontext des Eye-Tracking-Videos vorzustellen, das verwendet wird, wie: "Stellen Sie sich vor, dass es Mittag ist und Sie gehen allein in Melbourne. Sie sind geistig müde von intensiver Konzentration bei der Arbeit und suchen einen Ort zum Spazierengehen, setzen sich hin und ruhen sich eine Weile aus, bevor Sie wieder zur Arbeit gehen ".

- Setzen Sie die Teilnehmer bequem vor den Computerbildschirm in einem Abstand von 60 – 65 cm, um die Filme zu sehen.

- Mit Hilfe eines Tabellenkalkulationsprogramms bestellen Sie die Filme nach dem Zufallsprinzip, bevor Sie vor den Teilnehmern spielen.

- Verwenden Sie Lautsprecher, um den gleichen Ton für alle Filme zu spielen.

- Zeichnen Sie die Blickbahn der Teilnehmer mit Hilfe eines Desktop-Eye-Tracking-Systems auf. Montieren Sie das Desktop-Eye-Tracking-Gerät nach den Anweisungen des Herstellers. Das könnte knapp unter dem Bildschirm auf einem Tisch liegen, oder es könnte zum Beispiel an den Rand des Bildschirms Clip gehen.

- Verwenden Sie eine Eye-Tracking-Einheit mit einer Abtastrate von 120 Hz und einer Genauigkeit von 0,50 °, die eine große Freiheit der Kopfbewegungen ermöglicht, die die Aufnahme während der natürlichen Kopfbewegungen ermöglicht. Auch ein niedrigerer Frequenz-Augenträger ist akzeptabel. Bei 57,3 cm entspricht 1 ° Blickwinkel auf dem Bildschirm ~ 1 cm.

- Den Teilnehmern erlauben Sie, das Filmmaterial auf einem Monitor in High Definition zu sehen.

- Mit der Eye-Tracking-Software Augenbewegungen aufnehmen

- Verwenden Sie einen Fixationsfilter, um die Rohaugenproben für die Analyse umzuwandeln. Im Hauptmenü klicken Sie auf Tools > Einstellungen. Wählen Sie die Registerkarte Fixation Filter.

- Wenn Sie mit mehreren Filmen die Liedverfolgung aufzeichnen, geben Sie Pausen zwischen den Aufnahmesessions, wenn die Teilnehmer sie anfordern.

5. Verbindung der betrachtten Parks mit Impressionen der Videos

- Vergleichen Sie das Ausmaß, in dem die Menschen Objekte und ihre Meinung zu den Videos angeschaut haben, indem sie die Teilnehmer bitten, jeden der Parks auf einer Skala von 1 – 10 zu bewerten, erstens, ob sie das Gefühl haben, in dieser Umgebung ruhen und sich erholen zu können (1 , nicht sehr viel, bis 10, sehr viel) und zweitens, wie sehr ihnen der Park gefallen hat (1, nicht sehr, bis 10, sehr viel).

- Fragen Sie die Teilnehmer, ob sie den Park nutzen würden, um sich zu entspannen oder Stress zu lindern (Y/N) und ob sie den Park, den sie sich angeschaut haben, erkannt haben (Y/N), um die möglichen Auswirkungen einer früheren Verbindung mit dem Park zu kontrollieren.

- Nehmen Sie kurze Antwortreaktionen der Teilnehmer auf, um ihre Eindrücke mit einem Sprachrekorder zu erklären und diese dann zu transkribieren.

6. Automatische Videoanalyse für den Bereich der Zinsextraktion

- Auswahl an AOIs

- Wählen Sie Gegenstände, die für Parkdesigner, Stadtplaner, Planer oder Architekten von Interesse sind, wie Bäume, Sträucher, Wegweiser, Gebäude, Rasen, Wege, Stufen , etc.

- Für optimale Leistung und minimale Trainingsanforderungen (weiter unten besprochen) verwenden Sie Elemente, die sich leicht mit bloßem Auge voneinander unterscheiden lassen, and/oder konsequent verschiedene Regionen jedes Videorahmens einnehmen. Generell sollten ausreichende Trainingsbeispiele, die die visuell abnehmenden Unterschiede der einzelnen AOI darstellen, für eine robuste Leistung ausreichen.

- Schulungsklassiker für die AOI-Gewinnung

- Auswahl der zu verwendenden Trainingsrahmen, Anzahl und Begründung

- Wählen Sie eine entsprechende Anzahl von Trainingsrahmen (fortan als Trainingsset bezeichnet). Es gibt keine feste Zahl, die angemessen ist.

Hinweis: Die Frames müssen den Bereich des visuellen Erscheinungsbildes jeder Objektklasse (d.h. der zu kennzeichnenden Objekte) während des gesamten Videos ausreichend abdecken. So wurden beispielsweise 40 Bilder aus einer 15.000-Frame-Videosequenz gefunden, die eine einzelne Parkland-Szene darstellt, um eine ausreichende Genauigkeit zu erreichen. Wenn eine Sequenz signifikante Abweichungen in allen enthalten, dann können mehr Frames benötigt werden. - Bei der Auswahl der Trainingsbilder werden die Inhalte des Frames berücksichtigt. Dazu gehören: Beleuchtung, Formen in Bezug auf das, was klassifiziert wird (z.B. nicht nur eine Baumart, sondern eine Reihe von Baumarten, ihre Position im Bild, die Art, wie sie beleuchtet werden, etc .), Textur und Farbe.

- Beachten Sie auch die Anzahl der zu enthielten Frames. Konkret geht es um die Länge und Variation der visuellen Bedingungen, die im gesamten Video gezeigt werden, sowie um die Anzahl der zu identifizierenden Objektklassen und die Häufigkeit ihres Erscheinungsbildes.

- Wählen Sie eine entsprechende Anzahl von Trainingsrahmen (fortan als Trainingsset bezeichnet). Es gibt keine feste Zahl, die angemessen ist.

- Manuelle Pixelbeschriftung für Trainingsrahmen

Hinweis: Die manuelle Kennzeichnung der Trainingsrahmen wird Pixel mit den Interessengruppen des Objekts verbinden.- Pixelbeschriftung von Schulungsrahmen

- Öffnen Sie wiederum jeden Trainingsrahmen aus dem Video in der Bildbearbeitungssoftware.

- Für jeden Trainingsrahmen aus dem Video überlagern Sie eine transparente Bildschicht auf dem geladenen Bild zur Beschriftung und erstellen eine Farbpalette, die eine Farbe für jede einzelne Objektklasse bietet (z.B. AOI).

- Stellen Sie sicher, dass die Farbpalette und die Kartierung von Farbe zu Objektklassen während des gesamten Kennzeichnungsprozesses gleich sind.

- Wählen Sie die Farbe für das Beispiel AOI.

- Farbregionen von Beispiel-AOIs, indem Sie mit einem Mausklick und Drag Pixel innerhalb des Bereichs auswählen, um "Farbe in" mit der entsprechenden Palette der Palette zu wählen.

Hinweis: Es ist möglich, große Objekte ungenau zu färben. Achten Sie jedoch bei schmalzkleinen Objekten mit einer Breite von wenigen Pixeln darauf, dass die manuelle Kennzeichnung das Erscheinungsbild des Objekts genau erfasst. - Sobald die Beschriftung eines Frames abgeschlossen ist, exportieren Sie die überlagerte Ebene als separate Bilddatei. Stellen Sie sicher, dass der Name der Basisdatei mit dem ursprünglichen Namen der Frame-Basis-Datei übereinstimmt, aber mit einem "c", das am Ende angehängt wird. Wenn zum Beispiel der ursprüngliche Frame-Dateiname "1234.png" war, dann sollte der beschriftete Layer-Dateiname "12c.png" sein.

- Stellen Sie sicher, dass alle beschrifteten Bilder in einem Ordner gespeichert werden.

-

Pixelkennzeichnung von Validierungsrahmen

Hinweis: Um die Genauigkeit des geschulten Klassifizierers quantitativ zu bestätigen, sollte ein zusätzlicher Satz beschrifteter Rahmen erstellt werden.- Wählen Sie die Bilder aus der ursprünglichen Videosequenz aus, die noch nicht ausgewählt wurde, um in den Trainingssatz aufgenommen zu werden. Für ein 5-minütiges Video müssen diese nicht mehr als 20 Bilder sein, sondern sollten einheitlich von quer durch die Videosequenz gesampelt werden, um eine ausreichende Berichterstattung zu gewährleisten.

- Label-Pixel in jedem Rahmen mit der gleichen Prozedur wie für die Vorbereitung von Trainingsrahmen (6.2.2) beschrieben. Dieses Mal jedoch so präzise und umfassend wie möglich mit der Kennzeichnung sein, wie sie als Bodenwahrheitsvergleich dienen wird.

- Wenn die Beschriftung eines Frames abgeschlossen ist, verwenden Sie die gleiche Namenskonvention wie für die Schulung, stellen Sie jedoch sicher, dass Dateien in einem separaten Validierungsrahmen-Ordner gespeichert werden.

- Pixelbeschriftung von Schulungsrahmen

- Automatische Pixelkennzeichnung der Videosequenz

- Laden Sie die DARWIN Software-Bibliothek von http://drwn.anu.edu.au herunter.

Hinweis: Das in diesem Papier beschriebene System wurde in einer Linux-Umgebung implementiert, und so sollte die Linux-Version von DARWIN heruntergeladen und installiert werden, nach den Anweisungen der Website. - Start der Darwin GUI

- Klicken Sie in der Darwin GUI auf Trainingskennzeichnungen laden.

- Wählen Sie mit dem erscheint erscheint erscheint aktuellen Dialogfeld "Datei-Explorer-Dialog" den Ordner mit den beschrifteten Trainingsbildern für die entsprechende Videosequenz.

- Klicken Sie auf Video-Frames laden und folgen Sie der gleichen Prozedur wie 6.2.3.2, um den Ordner auszuwählen, der alle Originalbilder der Videosequenz enthält. Dies sollte ein Ordner von Bildern sein, in dem jeder Frame-Dateiname die Nummer dieses Frames in der Videosequenz ist (z.B.Frame 1234 würde 1234.png genannt)

- Klicken Sie auf die Schaltfläche Zug . Der Algorithmus wird nun jeden beschrifteten Trainingsrahmen untersuchen und ein Erscheinungsmodell erlernen, um Pixel in eine der angegebenen Objektklassen einzuordnen.

- Laden Sie die DARWIN Software-Bibliothek von http://drwn.anu.edu.au herunter.

- Validierung des ausgebildeten Klassifizierers

- Sobald das Training abgeschlossen ist, klicken Sie auf den Knopf "Training Validate ".

- Wählen Sie mit dem Dialogfeld Datei-Explorer den Ordner, der alle beschrifteten Validierungsbilder für die entsprechende Videosequenz enthält. Der geschulte Klassifizierer wird nun verwendet, um Pixel in jedem der im Validierungssatz genannten Frames zu klassifizieren. Vergleichen Sie dies mit den im Validierungsordner angegebenen Boden-Legenzeichnungen.

Hinweis: Sobald die GUI vollständig ist, wird die Genauigkeit der Statistik angezeigt, einschließlich des Anteils der Pixel, die für jeden Frame im Validierungsset korrekt gekennzeichnet sind, sowie über den gesamten Validierungssatz. - Um die generierten Etiketten visuell zu validieren, klicken Sie auf die Schaltfläche Visuelle Validierung . Wenn Sie angeklickt werden, wird jedes generierte, beschriftete Bild neben dem ursprünglichen Validierungsrahmen angezeigt.

Hinweis: Dies kann aufschlussreich sein, wenn es darum geht, zu erkennen, wo Fehlklassifikationen auf dem Objekt auftreten. Zum Beispiel kann eine visuelle Inspektion darauf hinweisen, dass in einem bestimmten Teil einer Objektklasse immer wieder Fehler auftreten, was auf eine verbesserte Kennzeichnung im Trainingssatz hindeutet. Alternativ kann die Inspektion zeigen, dass Fehler nur zu einem bestimmten Zeitpunkt im Video auftreten, was darauf hindeutet, dass aus diesem Zeitraum im Video mehr Trainingsbeispiele erforderlich sind. - Wenn die Genauigkeit, die in der quantitativen oder qualitativen Validierung beobachtet wird, unter das akzeptable Niveau fällt, dann schließen Sie weitere Schulungsbeispiele ein. In diesem Fall wiederholen Sie alle Schritte von 6.2.2 zusätzliche Trainingsrahmen, trainieren Sie den Klassifizierer nach Schritten in 6.2.3 und bestätigen Sie die folgenden Schritte in 6.2.4.

- Videopixelkennzeichnung

- Wenn die Klassifizierungstraining und Validierungsphase abgeschlossen ist, klicken Sie auf Etikettenrahmen auf der Darwin GUI, um mit dem geschulten Klassifizierer die vollständige Beschriftung aller Frames in der Videosequenz zu beginnen.

- Folgen Sie der Aufforderung, um einen Zielordner für alle Ausgabefrahmen auszuwählen, der in Form von beschrifteten Bildern mit der gleichen Farbpalette wie beim Training verwendet wird.

- Auswahl der zu verwendenden Trainingsrahmen, Anzahl und Begründung

7. Registrierung der Eye-Tracking-Daten zu den Video-Inhalten

- Klicken Sie in der Eye-Tracking-Software auf Datei > Export ... Exportieren Sie die Eye-Tracking-Datei als CSV-Datei.

- Öffnen Sie die Datei in einem Tabellenkalkulationsprogramm.

- Aus der Videosequenz wird die Zeit identifiziert, zu der das weiße Kreuz auf der linken oberen Seite des Rahmens verschwindet (siehe 2.3). Nutzen Sie diese Zeit, um die Eye-Tracking zu identifizieren, indem Sie die entsprechende Spalte auf dem Eye-Tracking-Ergebnis verwenden. Dies ist der Beginn der Eye-Tracking-Datenerhebung.

- Fügen Sie eine Spalte zu den Eye-Tracking-Daten hinzu.

- Mit diesem neuen Spaltenetikett wird jede Zeile oder ein Blickverfolgungs-Datenpunkt mit einer Framennummer verwendet, die an der Nummer 1 beginnt.

8. Die Anzahl der Zeit, die die Teilnehmer untersucht untersucht verschiedene Klassen von Objekten in den Videos

Hinweis: Aufgrund der enormen Größe der Eye-Tracking-Daten wird die Programmiersprache Python besser für Schritte bis 8.4 verwendet, obwohl auch ein Datenverarbeitungsprogramm verwendet werden kann.

- Mit dem mitgelieferten Python-Code wird die Anzahl der Überschneidungen zwischen den Objekten, die von Interesse sind, und der Zeit und Häufigkeit der Blickverfolgung berechnet.

- Sum diese Daten, um zu verstehen, wie viel Zeit die Teilnehmer damit verbrachten, verschiedene Objekte zu betrachten.

- Verwenden Sie ein Histogramm, um die gesamte Zeit, die die Objekte besetzt den Bildschirm zu zeigen.

- Vergleichen Sie dies mit dem Gesamtaufwand, den die Teilnehmer verschiedene Objekte betrachteten.

- Um eine Hitzekarte in der Eye-Tracking-Software zu erstellen, klicken Sie auf eines der Park-Walk-Videos mit dem Häkchen.

- Klicken Sie auf die Registerkarte Wärmekarte .

- Passen Sie die Farbe und andere Funktionen der Wärmekarte so an, wie gewünscht, indem Sie die Variablen von "Count" (Gesamtzahl der Fixierungen, die über das Zeitfenster gemacht wurden), "Absolute Dauer" (angesammelte Fixierungsdauer) und "Relative Dauer" (die Zeit, die mit dem Betrachten eines Objekt geteilt durch die Menge der Zeit, die mit dem Betrachten einer Szene geteilt wird).

- Exportieren Sie das Bild oder Video, das die Wärmekarte als JPEG-Datei oder Videodatei enthält.

Ergebnisse

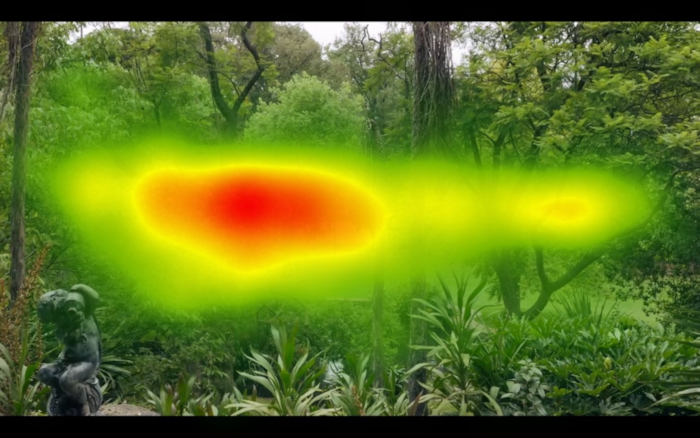

Abbildung 1 und Abbildung 2 zeigen das Ergebnis, dass alle Eye-Tracking-Daten für das gesamte Video über alle Teilnehmer hinweg erfasst werden und eine Wärmekarte erstellt wird; Dies ist der Standard-Ansatz, der in Eye-Tracking-Softwarepaketen verfügbar ist. Durch den Vergleich von Abbildung 1 und Abbildung 2 lässt sich feststellen, dass im Durchschnitt die Teilnehmer links und rechts auf der x-Koordinate des Videos in Abbildung 1 im Vergleich zu Abbildung 2 gescannt werden, die eine Runderform aufweist. Das liegt daran, dass Abbildung 1 im gesamten Video mehr horizontale Elemente hatte als der Park in Abbildung2. Das Bild hinter der Wärmekarte ist ein einzelner Rahmen und stellt nicht ausreichend den vollen Inhalt des Videos dar.

Das Desktop-Eye-Tracking-System und die Software zählen nur Ergebnisse, bei denen beide Augen gleichzeitig lokalisiert werden können. Mit anderen Worten: Wenn ein oder beide Augen nicht lokalisiert werden können, werden die Daten als verloren gezählt. In unserem Fall wurden Eye-Tracking-Daten für & gt;80% der Zeit erfasst.

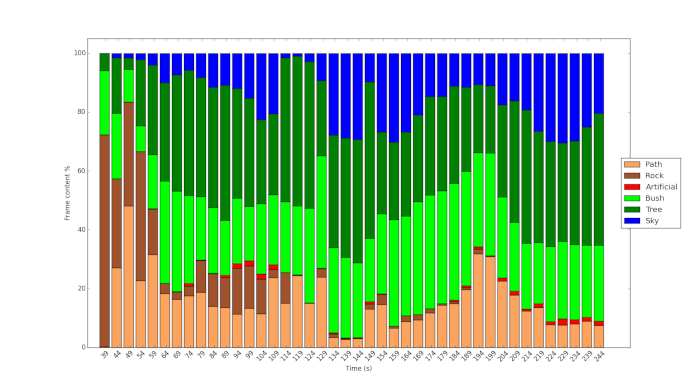

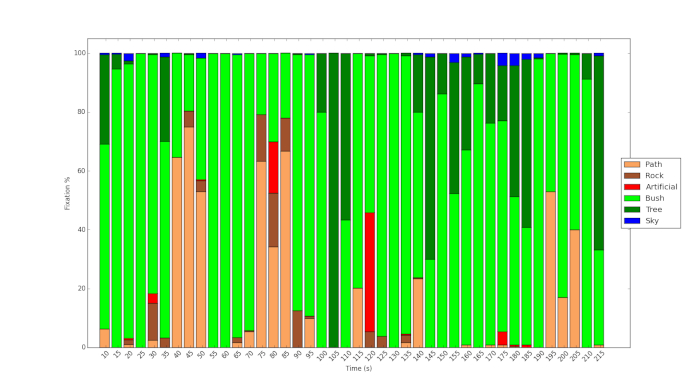

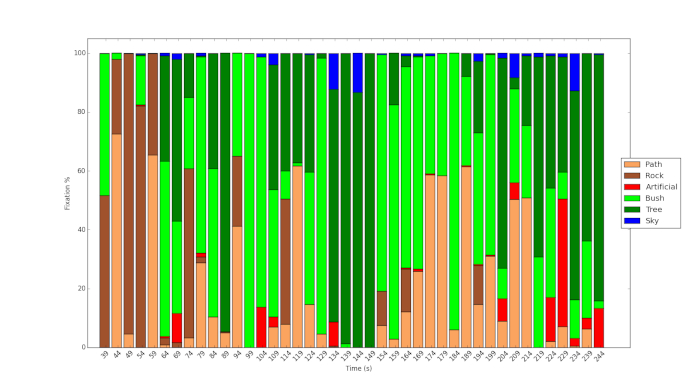

Abbildung 3 und Abbildung 4 zeigen das Ergebnis der Verwendung des Protokolls und der Nutzung von maschinellem Lernen, um den Inhalt der Videos zu analysieren. Abbildung 3 zeigt die dichte Vegetation der Fitzroy-Gärten im Vergleich zur relativ spärlichen Vegetation des Royal Parks (Abbildung4). Bei letzterem ist mehr Himmel zu sehen, mehr Szenen dominieren die Strauchvegetation. Abbildung 5 zeigt die% Fixierungszeit auf die verschiedenen Objekte während des Videos für einen der Teilnehmer. Es zeigt, dass der Pfad zwar im Verlauf des Videos deutlich sichtbar ist, der Teilnehmer diese Funktion aber nur gelegentlich, aber an Schlüsselpunkten betrachtet. Wie Abbildung 6 zeigt, untersucht der Teilnehmer der Studie diese Merkmale in einem vergleichsweise großen Umfang, obwohl ein winziger Bruchteil des Inhalts des Videos im Royal Park auf künstliche Objekte zurückzuführen ist.

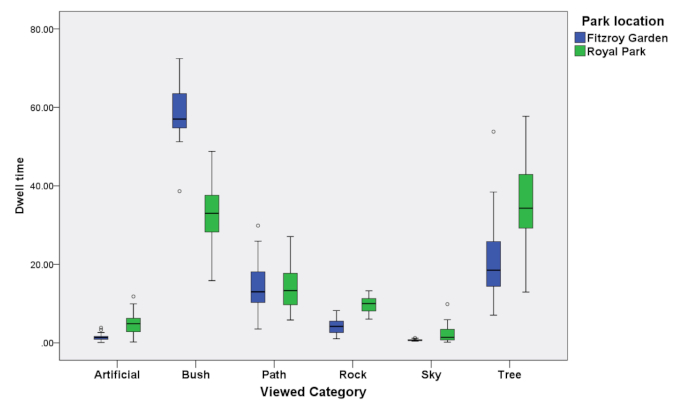

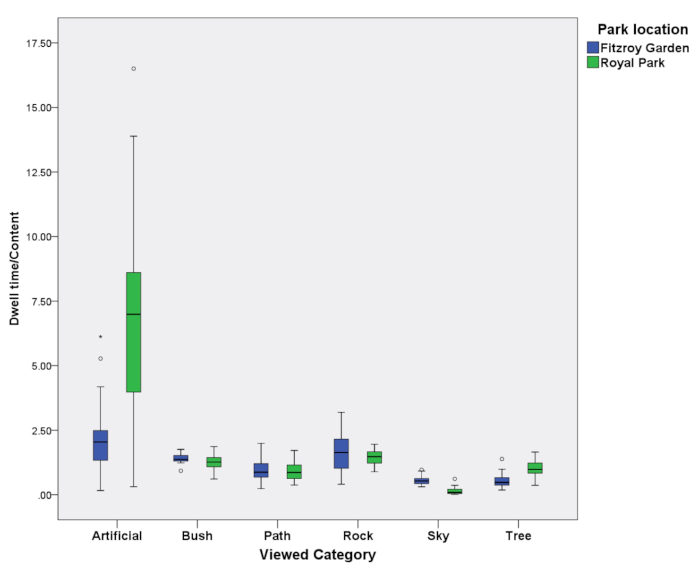

Die Ergebnisse in Abbildung3, Abbildung 4, Abbildung5 und Abbildung 6 können in Abbildung 7 und Abbildung 8 für alle 39 Teilnehmer zusammengefasst werden, deren Daten in dieser Studie verwendet wurden. Abbildung 7 zeigt die Verweildauer für alle Teilnehmer, wenn sie Objekte während der gesamten Länge des Videos betrachten. Die Abbildung 8 zeigt die gleichen Daten, die durch die Zeit und den Raum geteilt sind, die diese verschiedenen Objekte im Video besetzten. Ein Wert von 1 zeigt an, dass die Verweigerzeit durch die Menge des Objekts im Video abgerechnet werden kann. Abbildung 7 zeigt, dass künstliche Objekte wie Straßenlaternen und Bänke im Vergleich zu anderen Objekten (& gt;1) in größerem Maße bewohnt werden. Abbildung 7 zeigt auch, dass Objekte, die weniger relevant waren, wie der Himmel in beiden Bildern, vergleichsweise weniger gesehen wurden (& lt;1).

Abbildung 1: Beispiel-Wärmekarte, die für das gesamte Video eines Parks erstellt wird. Das zeigt, wo sich der Großteil der Augenspuren befand. Beachten Sie die horizontale Form der Wärmekarte wegen der Dominanz der horizontalen Elemente im Video. Bitte klicken Sie hier, um eine größere Version dieser Figur zu sehen.

Abbildung 2: Beispiel Wärmekarte, die für das ganze Video eines anderen Parks produziert wird. Beachten Sie die abgerundete Form, weil vertikale und horizontale Elemente im Video vorhanden sind. Bitte klicken Sie hier, um eine größere Version dieser Figur zu sehen.

Abbildung 3: Histogramm des Inhalts im Video von Fitzroy Gardens analysiert mit der maschinellen Lerntechnik. Bitte klicken Sie hier, um eine größere Version dieser Figur zu sehen.

Abbildung 4: Histogramm von Inhalten im Video von Royal Park mit der maschinellen Lerntechnik analysiert. Bitte klicken Sie hier, um eine größere Version dieser Figur zu sehen.

Abbildung 5: Augenverfolgungs-Fixierungszeit mit dem Betrachten von Objekten in Fitzroy Gardens. Bitte klicken Sie hier, um eine größere Version dieser Figur zu sehen.

Abbildung 6: Zeit zur Fixierung von Augenverfolgung, die mit dem Betrachten von Objekten im Royal Park verbracht wird. Bitte klicken Sie hier, um eine größere Version dieser Figur zu sehen.

Abbildung 7: Aggregierte Eye-Tracking Verweilen für alle Teilnehmer und Objekte für beide Parks. Bitte klicken Sie hier, um eine größere Version dieser Figur zu sehen.

Abbildung 8: Aggregierte Eye-Tracking wohnen in Bezug auf Inhalte für alle Teilnehmer und Objekte für beide Parks. Bitte klicken Sie hier, um eine größere Version dieser Figur zu sehen.

Diskussion

In der Regel wird in Standard-Softwarepaketen zur Analyse von Eye-Tracking-Daten ein Vektor AOI verwendet. Auch für ein einzelnes Standbild lässt sich die Größe des Vektors nicht einfach messen. Darüber hinaus ist es mühsam, alle AOIs in ein Bild aufzunehmen und die relativen Mengen von AOIs zu berechnen. Es ist fast unmöglich, dies manuell auf einem Video zu tun, ohne eine maschinelle Lerntechnik, wie sie beschrieben wird. Das war eine relativ einfache Aussage, die eine kostenlose Betrachtungssituation einfügt. Ein viel genaueres Szenario kann verwendet werden und verschiedene Szenarienbeschreibungen, bevor der gleiche Reizauch die Augenbewegungen 11 beeinflussen kann.

Unsere Recherchen verwendeten eine Methode, um Objekte in einem Video präzise zu klassifizieren und zu analysieren, inwieweit diese für das Auge sichtbar waren. Die Methode stellt ein Mittel dar, um zu erklären, inwieweit Augenbewegungen mit interessanten Objekten verknüpft sind. So lässt sich beim Vergleich der Eye-Tracking von verschiedenen Probanden mit einem mobilen Eye-Tracking-Gerät oder an verschiedenen Orten bei der Nutzung eines Desktop-basierten Systems kontrollieren, in dem interessante Objekte, die in einem Sichtfeld präsent sind, kontrolliert werden. Überlegungen, die sich auf die automatische Klassifizierung von Objekten durch das maschinelle Lernen auswirken können, das wir verwenden, sind Beleuchtung, Formen in Bezug auf das, was klassifiziert wird (z.B. nicht nur eine Baumart, sondern eine Reihe von Baumarten, ihre Position in der Bild, die Art und Weise, wie sie beleuchtet werden etc.), Textur und Farbe. Zu den Überlegungen über die Anzahl der Rahmen gehören die Länge und Variation der visuellen Bedingungen, die im gesamten Video gezeigt werden, sowie die Anzahl der zu identisierenden Objektklassen und die Häufigkeit ihres Erscheinungsbildes. Die Rahmen ändern sich jede Ein-25-Sekundenzeit, aber die Eye-Tracking mit der Software erfolgt bei der Ein-120 (120 Hz). Aus diesem Grund werden die Eye-Tracking-Daten mit dem 4.8-fachen der Geschwindigkeit erhoben, mit der ein neuer Rahmen erscheint. Es ist nicht möglich, die Etikettierung vollständig genau zu kennzeichnen, aber die Kennzeichnung der Rahmen sollte alle 5 Mal geändert werden. Zum Beispiel wurden für den Rahmen von 100 Sekunden des Videos die Eye-Tracking-Daten während 99 bis 101 s berücksichtigt.

Ein wesentlicher Vorteil der aktuellen Eye-Tracking-Pakete ist, dass sie so eingerichtet sind, dass Nutzer einen Film über ihre eigenen Eye-Tracking-Fixierungen und-Wege überprüfen und beschreiben können, warum sie bestimmte Objekte angeschaut haben. Daraus ergibt sich ein qualitativer Datensatz, der aufdecken kann, warum einzelne Probanden denken, bestimmte Objekte betrachtet zu haben. Eine Erweiterung des Projekts wäre es, ihnen auch die Zeit zu zeigen, die sie damit verbracht haben, Objekte zu unterschiedlichen Zeiten im Verhältnis zum Inhalt zu betrachten, zum Beispiel die Informationen in Abbildung8. Doch dies durch die schnelle genug kontrollierte Anzahl von Objekten in einer Szene ist derzeit nicht möglich.

So konnten die Teilnehmer gebeten werden, ihre eigenen Blickwege zu betrachten, die aufgezeichnet worden waren, und zu beschreiben, warum sie sich die einzelnen Objekte12angeschaut hatten. In unserem Fall wurden die Teilnehmer am Ende eines jeden Films gebeten, jeden der Parks auf einer Skala von 1-10 zu bewerten, erstens, ob sie das Gefühl haben, in dieser Umgebung auszuruhen und sich zu erholen (1, nicht sehr, bis 10, sehr) und zweitens, wie sehr ihnen die Park (1, nicht sehr viel, bis 10, sehr viel).

Offenlegungen

nichts

Danksagungen

Diese Arbeit wurde von der Stadt Melbourne und teilweise von ARC DP 150103135 finanziell unterstützt. Wir danken Eamonn Fennessy für seinen Rat und seine Zusammenarbeit. Ein besonderer Dank galt den Forscherinnen Isabelle Janecki und Ethan Chen, die auch bei der Erhebung und Analyse dieser Daten mitgeholfen haben. Alle Fehler bleiben den Autoren erhalten.

Materialien

| Name | Company | Catalog Number | Comments |

| 12 mm lens | Olympus | Lens | |

| Panasonic GH4 | Panasonic | Video Camera | |

| Tobii Studio version (2.1.14) | Tobii | Software | |

| Tobii x120 desktop eye-tracker | Tobii | Eye-tracker |

Referenzen

- Patrik, P., Stigsdotter, U. K. The relation between perceived sensory dimensions of urban green space and stress restoration. Landscape and Urban Planning. 94 (3-4), 264-275 (2010).

- Bjørn, G., Patil, G. G. Biophilia: does visual contact with nature impact on health and well-being?. International Journal of Environmental Research and Public Health. 6 (9), 2332-2343 (2009).

- Velarde, M. a. D., Fry, G., Tveit, M. Health effects of viewing landscapes-Landscape types in environmental psychology. Urban Forestry & Urban Greening. 6 (4), 199-212 (2007).

- Polat, A. T., Ahmet, A. Relationships between the visual preferences of urban recreation area users and various landscape design elements. Urban Forestry & Urban Greening. 14 (3), 573-582 (2015).

- Peter, P., Giannopoulos, I., Raubal, M. Where am I? Investigating map matching during self-localization with mobile eye tracking in an urban environment. Transactions in GIS. 18 (5), 660-686 (2014).

- Berto, R., Massaccesi, S., Pasini, M. Do Eye Movements Measured across High and Low Fascination Photographs Differ? Addressing Kaplan's Fascination Hypothesis. Journal of Environmental Psychology. 28 (2), 185-191 (2008).

- Kaplan, S. The restorative benefits of nature: Towards an integrative framework. Journal of Environmental Psychology. 15, 169-182 (1995).

- Duchowski, A. T. . Eye Tracking Methodology: Theory and Practice. , (2017).

- Amati, M., Ghanbari Parmehr, E., McCarthy, C., Sita, J. How eye-catching are natural features when walking through a park? Eye- tracking responses to videos of walks?. Urban Forestry and Urban Greening. 31, 67-78 (2018).

- Gould, S. D. A. R. W. I. N. A Framework for Machine Learning and Computer Vision Research and Development. Journal of Machine Learning Research. (Dec), 3533-3537 (2012).

- Richardson, D., Matlock, T. The integration of figurative language and static depictions: an eye movement study of fictive motion. Cognition. 102 (1), 129-138 (2007).

- Bojko, A. . Eye Tracking the User Experience: A Practical Guide to Research. , (2013).

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenThis article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten