Décodage de l'imagerie auditive avec l'analyse de motifs multivoxels

Vue d'ensemble

Source : Laboratoires de Jonas T. Kaplan et Sarah I. Gimbel — University of Southern California

Imaginez le son d’une cloche. Ce qui se passe dans le cerveau lorsque nous évoquent un son comme ça dans « l’oreille de l’entendement ? » Il y a plus de preuves que le cerveau utilise les mêmes mécanismes d’imagination qu’il utilise pour perception. 1 par exemple, en imaginant des images visuelles, le cortex visuel est activé, et en imaginant les sons, le cortex auditif est engagé. Toutefois, dans quelle mesure sont-ils ces activations du cortex sensoriels spécifiques au contenu de notre imagination ?

Une technique qui peut aider à répondre à cette question est l’analyse des habitudes de multivoxel (MPVA), dans quelles images cérébrale fonctionnelle sont analysées à l’aide de techniques d’apprentissage automatique. 2-3 experiment in an MPVA, nous formons un algorithme d’apprentissage automatique de distinguer parmi les différents modèles de l’activité induite par différents stimuli. Par exemple, on peut se demander si imaginer le son d’une cloche produit différents modèles de l’activité dans le cortex auditif comparée à imaginer le bruit d’une tronçonneuse, ou le son d’un violon. Si notre classificateur apprend à distinguer les patterns d’activité cérébrale produites par ces trois stimuli, alors nous pouvons conclure que le cortex auditif est activé de manière distincte de chaque stimulus. Une façon de penser à ce genre d’expérience est qu’au lieu de poser une question simplement sur l' activité d’une région du cerveau, nous poser une question sur le contenu de l’information de cette région.

Dans cette expérience, basée sur Meyer et al., 2010,4 nous seront cue participants pour imaginer plusieurs sons en leur remettant vidéos silencieux qui sont susceptibles d’évoquer des images auditives. Puisque nous nous intéressons à mesurer les motifs subtils évoquées par l’imagination dans le cortex auditif, il est préférable si les stimuli sont présentés dans un silence complet, sans ingérence des bruits fait par le scanner IRMf. Pour ce faire, nous utiliserons un type spécial de séquence de MRI fonctionnel appelé échantillonnage temporel clairsemée. Dans cette approche, un volume unique IRMf est acquise 4-5 s après chaque stimulus, programmée pour capturer la crête de la réponse hémodynamique.

Procédure

1. participant recrutement

- Recruter des 20 participants.

- Les participants devraient être droitier et ont pas d’antécédents de troubles neurologiques ou psychologiques.

- Les participants devront avoir une vision normale ou corrigée à la normale pour s’assurer qu’ils seront en mesure de voir les repères visuels correctement.

- Les participants n’ait pas de métal dans leur corps. Il s’agit d’une exigence de sécurité importante due au champ magnétique élevé impliqué en IRMf.

- Les participants ne devraient pas souffrent de claustrophobie, étant donné que l’IRMf exige se trouvant dans le petit espace du scanner alésage.

2. l’analyse préalable des procédures

- Remplir la paperasse pré-scan.

- Lorsque les participants viennent leur Scan IRMf, indiquez-lui de premier remplissage à une forme de grille métallique pour s’assurer qu’ils n’ont aucune contre-indications pour l’IRM, une forme accessoire-constatations donner leur consentement pour leur analyse être regardé par un radiologue et un formulaire de consentement précisant les risques et les avantages de l’étude.

- Préparer les participants à aller dans le scanner, en supprimant tous les métaux de leur corps, y compris les ceintures, portefeuilles, téléphones, pinces à cheveux, pièces de monnaie et tous les bijoux.

3. fournir des instructions pour le participant.

- Dites aux participants qu’ils verront une série de plusieurs courtes vidéos à l’intérieur du scanner. Ces vidéos seront silencieux, mais ils peuvent évoquer un son en « oreille de l’entendement. » Demander au participant de se concentrer sur et encourager cette imagerie auditive, pour essayer de « entendre » le bruit mieux qu’ils le peuvent.

- Insister sur l’importance de garder leur tête toujours tout au long de l’analyse au participant.

4. mettre le participant dans le scanner.

- Donner les bouchons d’oreille participant pour protéger leurs oreilles contre le bruit des téléphones scanner et oreille de porter afin de pouvoir entendre l’expérimentateur pendant le balayage et demandez-leur de s’allonger sur le lit avec leur tête dans la bobine.

- Donner au participant la balle d’urgence squeeze et indiquez-lui à le presser en cas d’urgence pendant l’analyse.

- Utilisation des coussinets en mousse pour garantir aux participants la tête dans la bobine pour éviter le mouvement excessif lors de l’analyse et rappeler le participant qu’il est très important de rester aussi immobile que possible lors de l’analyse, comme même le flou des mouvements plus petit les images.

5. collecte des données

- Recueillir l’analyse anatomique haute résolution.

- Commence l’analyse fonctionnelle.

- Coïncider le début de la présentation de la stimulation avec le début du scanner.

- Pour réaliser l’échantillonnage temporel clairsemée, définir le temps d’acquisition d’un volume de MRI à 2 s, avec un retard de 9-s entre les acquisitions de volume.

- Présenter les vidéos silencieux via un ordinateur portable connecté à un projecteur. Le participant a un miroir au-dessus de leurs yeux, reflétant qu'un écran à l’arrière du scanneur d’alésage.

- Coïncider le début de chaque clip vidéo 5-s pour commencer 4 s après le démarrage de l’acquisition de MRI précédente. Cela permettra d’assurer que le prochain volume de MRI est acquis 7 s après le début du clip vidéo, pour capturer l’activité hémodynamique qui correspond au milieu du film.

- Présenter trois différentes vidéos silencieux qui évoquent des images auditives vives : une cloche se balançant en arrière, une coupe de la tronçonneuse dans un arbre et une personne qui joue un violon.

- Dans chaque analyse fonctionnelle, présenter chaque vidéo 10 fois, dans un ordre aléatoire. Chaque essai dure 11 s, cela se traduira par un scan 330 s (5,5 min) long.

- Effectuer des analyses fonctionnelles 4.

6. analyse de données

- Définir une région d’intérêt (ROI).

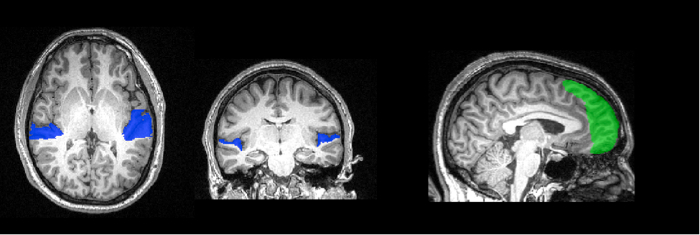

- La numérisation haute résolution anatomique de chaque participant permet de retracer les voxels correspondant au cortex auditif précoce (Figure 1). Cela correspond à la surface du lobe temporal, appelé le planum temporale. Utilisez les caractéristiques anatomiques du cerveau de chaque personne pour créer un masque spécifique à leur cortex auditif.

Figure 1 : région de traçage intérêt. La surface du planum temporale a été tracée sur une image haute définition anatomique de ce participant et est présentée ici en bleu. En vert est le masque du pôle frontal. Ces voxels sera utilisés pour l’analyse MVPA.

- Pré-traiter les données.

- Effectuer la correction de mouvement pour réduire les artefacts de mouvement.

- Effectuer un filtrage temporel pour supprimer les dérives de signal.

- Former et tester l’algorithme classifieur.

- Diviser les données en formation et les ensembles de tests. Formation de données servira à former le classificateur, et les données de tests de sortie gauche servira à évaluer ce qu’il a appris. Afin de maximiser l’indépendance de la formation et l’évaluation des données, laisser de côté les données d’une seule analyse fonctionnelle comme le jeu de test.

- Former un algorithme de Machine de vecteur de soutien sur les données d’apprentissage étiquetées de cortex auditif dans chaque matière. Tester capacité du classificateur deviner correctement l’identité de l’ensemble des essai sans étiquette et enregistrer exactitude du classifieur.

- Répétez l’opération 4 fois, en laissant de côté chaque analyse que le test de données chaque fois. Ce type de procédure, dans laquelle chaque section des données est laissée de côté une fois, s’appelle la validation croisée.

- Combiner des exactitudes de classificateur à travers les 4 plis de la validation croisée en faisant la moyenne.

- Tests statistiques

- Pour déterminer si le classifieur exécute mieux que chance (33 %), nous pouvons comparer les résultats au niveau du groupe au hasard. Pour ce faire, rassembler les précisions pour chaque sujet et vérifier que la répartition est différente de la chance à l’aide d’un test non paramétrique de Wilcoxon Signed-grade.

- Nous pouvons également demander si le classifieur exécute mieux que la chance pour chaque individu. Pour déterminer la probabilité d’un niveau donné de précision dans les données de la chance, créer une distribution nulle en formation et en testant l’algorithme MVPA sur des données dont les étiquettes ont été mélangées au hasard. Permute les étiquettes 10 000 fois pour créer une distribution nulle des valeurs d’exactitude et ensuite comparer la valeur de précision réelle à cette distribution.

- Pour démontrer la spécificité de l’information dans le cortex auditif, nous pouvons former et tester le classifieur sur voxels d’un autre endroit dans le cerveau. Ici, nous allons utiliser un masque du pôle frontal, extraite d’un atlas probabiliste et déformé pour s’adapter à cerveau individuel de chaque sujet.

Résultats

La précision moyenne classifieur dans la temporale planum à travers tous les 20 participants était de 59 %. Selon le test de Wilcoxon Signed-grade, c’est significativement différent niveau de chance de 33 %. La performance moyenne dans le masque de mât de façade était de 32,5 %, qui n’est pas plu de chance (Figure 2).

Figure 2. Performance de classification à chaque participant. Pour la classification tripartite, performance de chance est de 33 %. Selon un test par permutations, le niveau alpha de p < 0,05 correspond à 42 %.

Le test par permutations révèle que seulement 5 % des permutations exactitude supérieure à 42 % ; ainsi, notre seuil statistique pour les sujets individuels est de 42 %. Dix-neuf des 20 sujets avaient classifieur performance significativement plu de chance en utilisant des voxels du planum temporale, alors qu’aucun n’avait plus de chance en utilisant des voxels du pôle frontal performance.

Ainsi, nous sommes en mesure de prédire avec succès des tendances de l’activité dans le cortex auditif qui, des trois sons, le participant était imaginer. Nous n’étions pas en mesure de faire cette prévision basée sur la structure de l’activité du pôle frontal, ce qui laisse supposer que l’information n’est pas globale dans tout le cerveau.

Applications et Résumé

MVPA est un outil utile pour comprendre comment le cerveau représente des informations. Au lieu de considérer l’évolution temporelle de chaque voxel séparément comme dans une analyse par activation traditionnelle, cette technique considère patrons à travers de nombreux voxels à la fois, offrant une sensibilité accrue par rapport aux techniques univariées. Souvent une analyse multivariée révèle des différences où une technique univariée n’est pas en mesure de. Dans ce cas, nous avons appris quelque chose sur les mécanismes de l’imagerie mentale en sondant l’information contenue dans une zone spécifique du cerveau, le cortex auditif. La nature du contenu spécifique de ces modèles d’activation serait difficile à tester avec des approches univariées.

Il y a des avantages supplémentaires qui viennent de la direction d’inférence dans ce genre d’analyse. Dans MVPA nous commençons avec des motifs de l’activité cérébrale et tenter d’en déduire quelque chose sur l’état mental du participant. Ce type d’approche « cerveau-lecture » peut conduire au développement des interfaces cerveau-ordinateur et peut permettre de nouvelles possibilités de communication avec ceux qui ont la parole avec facultés affaiblies ou mouvement.

References

- Kosslyn, S.M., Ganis, G. & Thompson, W.L. Neural foundations of imagery. Nat Rev Neurosci 2, 635-642 (2001).

- Haynes, J.D. & Rees, G. Decoding mental states from brain activity in humans. Nat Rev Neurosci 7, 523-534 (2006).

- Norman, K.A., Polyn, S.M., Detre, G.J. & Haxby, J.V. Beyond mind-reading: multi-voxel pattern analysis of fMRI data. Trends Cogn Sci 10, 424-430 (2006).

- Meyer, K., et al. Predicting visual stimuli on the basis of activity in auditory cortices. Nat Neurosci 13, 667-668 (2010).

Passer à...

Vidéos de cette collection:

Now Playing

Décodage de l'imagerie auditive avec l'analyse de motifs multivoxels

Neuropsychology

6.4K Vues

Le cerveau divisé

Neuropsychology

68.2K Vues

Cartes de motricité

Neuropsychology

27.5K Vues

Perspectives sur la neuropsychologie

Neuropsychology

12.0K Vues

Prise de décision et l'Iowa Gambling Task

Neuropsychology

32.4K Vues

Fonction exécutive dans les troubles du spectre autistique

Neuropsychology

17.7K Vues

Amnésie antérograde

Neuropsychology

30.3K Vues

Corrélats physiologiques de la reconnaissance des émotions

Neuropsychology

16.2K Vues

Potentiels liés à l'événement et paradigme "oddball" (ou stimulus discordant)

Neuropsychology

27.4K Vues

Langage : Le N400 en incongruité sémantique

Neuropsychology

19.6K Vues

Apprentissage et mémoire : la tâche de Remember-Know

Neuropsychology

17.1K Vues

Mesurer la différence de densité de matière grise grâce à la morphométrie basée sur les voxels : le cerveau musical

Neuropsychology

17.3K Vues

Attention visuelle : enquête par IRMf sur le contrôle attentionnel basé sur les objets

Neuropsychology

41.5K Vues

Utilisation de l'IRM de diffusion dans les lésions cérébrales traumatiques

Neuropsychology

16.7K Vues

Utilisation du TMS pour mesurer l'excitabilité motrice pendant l'observation de l'action

Neuropsychology

10.1K Vues