Method Article

Un metodo per la ricostruzione 3D e l'analisi della realtà virtuale delle cellule gliali e neuronali

In questo articolo

Riepilogo

La pipeline descritta è progettata per la segmentazione di set di dati di microscopia elettronica più grandi di gigabyte, per estrarre morfologie intere celle. Una volta che le celle sono state ricostruite in 3D, software personalizzato progettato intorno alle esigenze individuali può essere utilizzato per eseguire un'analisi qualitativa e quantitativa direttamente in 3D, utilizzando anche la realtà virtuale per superare vista occlusione.

Abstract

La sezionamento seriale e la successiva imaging ad alta risoluzione del tessuto biologico utilizzando la microscopia elettronica (EM) consentono alla segmentazione e alla ricostruzione di pile a immagine ad alta risoluzione di rivelare modelli ultrastrutturali che non potevano essere risolti utilizzando 2D Immagini. Infatti, quest'ultimo potrebbe portare a un'errata interpretazione delle morfologie, come nel caso dei mitocondri; l'uso di modelli 3D è, quindi, sempre più comune e applicato alla formulazione di ipotesi funzionali basate sulla morfologia. Ad oggi, l'uso di modelli 3D generati da pile di immagini di luce o elettroni rende le valutazioni qualitative e visive, così come la quantificazione, più convenienti da eseguire direttamente in 3D. Poiché questi modelli sono spesso estremamente complessi, è anche importante creare un ambiente di realtà virtuale per superare l'occlusione e sfruttare appieno la struttura 3D. Qui, una guida passo-passo dalla segmentazione dell'immagine alla ricostruzione e all'analisi è descritta in dettaglio.

Introduzione

Il primo modello proposto per la configurazione di una microscopia elettronica che consente la sezione seriale automatizzata e l'imaging risale al 19811; la diffusione di tali configurazioni automatizzate e migliorate per immagini di grandi campioni utilizzando EM aumentata negli ultimi dieci anni2,3, e opere che mostrano impressionanti ricostruzioni dense o morfologie complete immediatamente seguito4, 5,6,7,8,9,10.

La produzione di set di dati di grandi dimensioni è stata fornita con la necessità di pipeline migliorate per la segmentazione delle immagini. Gli strumenti software per la segmentazione manuale delle sezioni seriali, come RECONSTRUCT e TrakEM211,12, sono stati progettati per la microscopia elettronica a trasmissione (TEM). Poiché l'intero processo può richiedere molto tempo, questi strumenti non sono appropriati quando si tratta di migliaia di micrografie seriali che possono essere generati automaticamente con tecniche di sezione seriale EM automatizzate (3DEM), come microscopia elettronica a scansione a blocchi (SBEM)3 o microscopia elettronica a scansione del fascio focalizzato (FIB-SEM)2. Per questo motivo, gli scienziati hanno messo gli sforzi nello sviluppo di strumenti semi-automatizzati, nonché di strumenti completamente automatizzati, per migliorare l'efficienza della segmentazione. Strumenti completamente automatizzati, basati su machine learning13 o algoritmi di classificazione dei pixel non addestrati allo stato dell'arte14,vengono migliorati per essere utilizzati da una comunità più ampia; tuttavia, la segmentazione è ancora lungi dall'essere pienamente affidabile, e molte opere sono ancora basate sul lavoro manuale, che è inefficiente in termini di tempo di segmentazione, ma fornisce ancora completa affidabilità. Gli strumenti semiautomatici, come ilastik15, rappresentano un compromesso migliore, in quanto forniscono una lettura immediata per la segmentazione che può essere corretta in una certa misura, anche se non fornisce un quadro di correzione reale e può essere integrato utilizzando TrakEM2 in parallelo16.

La segmentazione su larga scala è, ad oggi, per lo più limitata alla connettomica; pertanto, gli informatici sono più interessati a fornire quadri per le visualizzazioni integrate di grandi set di dati annotati e ad analizzare i modelli di connettività dedotti dalla presenza di contatti sinaptici17,18. Tuttavia, ricostruzioni 3D accurate possono essere utilizzate per analisi morfometriche quantitative, piuttosto che valutazioni qualitative delle strutture 3D. Strumenti come NeuroMorph19,20 e analisi glicogeno10 sono stati sviluppati per prendere misure sulle ricostruzioni 3D per lunghezze, aree di superficie e volumi, e sulla distribuzione di punti nuvola, completamente scartando lo stack EM originale8,10. Gli astrociti rappresentano un caso di studio interessante, perché la mancanza di indizi visivi o modelli strutturali ripetitivi danno ai ricercatori un accenno sulla funzione delle singole unità strutturali e la conseguente mancanza di un'adeguata ontologia dei processi astrociti 21, rendere difficile la progettazione di strumenti analitici. Un recente tentativo è stato l'Assotite22, che consente un'esplorazione visiva dei processi astrociti e l'inferenza di relazioni qualitative tra processi astrociti citici e neuriti.

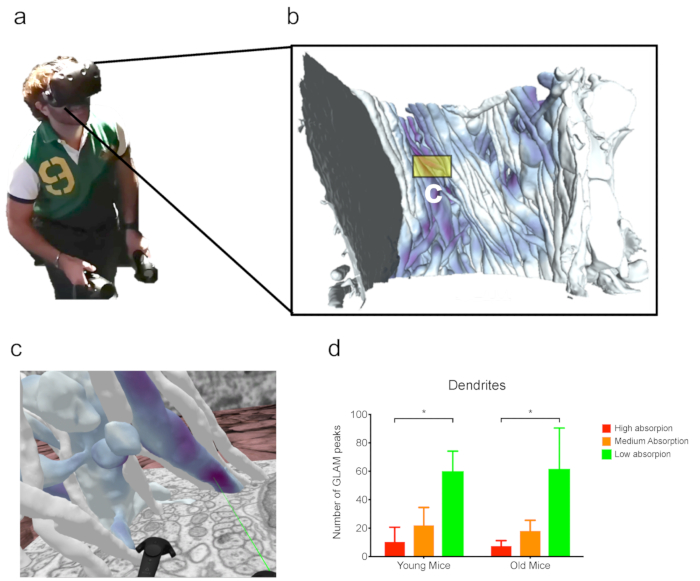

Tuttavia, la comodità dell'imaging del tessuto sezionato sotto EM deriva dal fatto che la quantità di informazioni nascoste in campioni di cervello intatti è enorme e l'interpretazione di immagini a sezione singola può superare questo problema. La densità delle strutture nel cervello è così alta che ricostruzioni 3D anche di pochi oggetti visibili contemporaneamente renderebbero impossibile distinguerli visivamente. Per questo motivo, abbiamo recentemente proposto l'uso della realtà virtuale (VR) come metodo migliorato per osservare strutture complesse. Ci concentriamo sugli astrociti23 per superare l'occlusione (che è il blocco della visibilità di un oggetto di interesse con un secondo spazio, in uno spazio 3D) e facilitare le valutazioni qualitative delle ricostruzioni, tra cui la correzione delle bozze, così come le quantificazioni di feature utilizzando il conteggio dei punti nello spazio. Recentemente abbiamo combinato l'esplorazione visiva VR con l'uso di GLAM (modello di assorbimento lattato derivato dal glicogeno), una tecnica per visualizzare una mappa della probabilità di navetta lattato di neuriti, considerando i granuli di glicogeno come corpi che emettono luce23; in particolare, abbiamo usato la VR per quantificare i picchi di luce prodotti da GLAM.

Protocollo

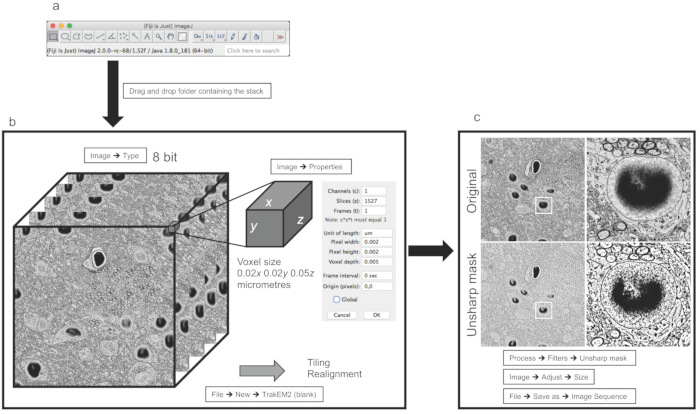

1. Elaborazione delle immagini con Fiji

- Aprire la pila di immagini trascinando e rilasciando il file nativo dal microscopio contenente la pila o trascinando e rilasciando la cartella contenente l'intera pila di immagini nella finestra del software.

NOT: Fiji è in grado di riconoscere automaticamente tutti i formati di immagine standard, come .jpg, .tif, e .png, così come i formati di file proprietari da fornitori di microscopio. Mentre il protocollo seguente è stato ottimizzato per gli stack di immagini da 3DEM, questi passaggi potrebbero essere utilizzati anche per i set di dati di microscopia leggera. - Una volta aperto lo stack, vai a Immagine > Proprietà per assicurarti che la dimensione voxel sia stata letta dai metadati. In caso contrario, può essere immesso manualmente.

- Assicurati di trasformare l'immagine in 8 bit. Fare clic su Immagine > Tipo e selezionare 8-bit.

- Se lo stack originale si trovava in file/cartelle sequenziali diversi, utilizzare Concatena te per unirli in un unico stack selezionando Immagine > Stack > Strumenti > Concatena.

- Salvare la pila selezionando File > Salva con nome. Verrà salvato come singolo file .tif e può essere utilizzato come backup e per un'ulteriore elaborazione.

- Se la pila originale viene acquisita come piastrelle diverse, applicare cuciture all'interno di TrakEM2.

- Creare un nuovo progetto TrakEM2 utilizzando Nuovo > TrakEM2 (vuoto).

- All'interno dell'interfaccia utente grafica (GUI) del riquadro di visualizzazione, importare gli stack facendo clic con il pulsante destro del mouse > Importa > Importa pilae importando tutti i riquadri aperti nella GUI principale di Fiji. Assicurati di ridimensionare le dimensioni dell'area di disegno per adattarla all'intera pila facendo clic con il pulsante destro del mouse > Schermo > Ridimensiona canvas/insieme di livellie scegli la dimensione y /x pixel a seconda delle dimensioni finali del montaggio.

NOT: Ad esempio, se il montaggio deve essere finalizzato utilizzando quattro riquadri di 4.096 x 4.096 pixel, le dimensioni dell'area di disegno devono essere di almeno 8.192 x 8.192 pixel. Si consideri di renderlo leggermente più grande, e ritagliarlo più tardi. - Sovrapporre le parti comuni dei singoli riquadri trascinandole e rilasciandole sul set di livelli. Utilizzare il dispositivo di scorrimento in alto a sinistra per modificare la trasparenza per facilitare la sovrapposizione.

- Montare e riallineare le pile facendo clic con il pulsante destro del mouse > Allinea, quindi selezionare una delle opzioni (vedere la nota seguente).

NOT: SBEM o FIB-SEM sono in genere già ben allineati, ma potrebbero verificarsi disallineamenti minori. Allinea livelli è la pipeline automatica per l'allineamento z; Montage più livelli è la pipeline automatica per allineare i piastrelle su ogni stack z, per l'intero volume; Il mosaico multistrato allinea combina le due opzioni precedenti. Questa operazione richiede molto tempo e soggetta alla memoria ad accesso casuale (RAM) della macchina. Considerare l'utilizzo di un computer di fascia alta e lasciarlo funzionare per ore/giorni, a seconda delle dimensioni dello stack. - Infine, esportare le pile di immagini e salvarle utilizzando il pulsante destro del mouse > Crea immagine piatta, quindi assicurarsi di selezionare la prima e l'ultima immagine nei menu a discesa Inizio e Fine.

- Utilizzando le funzioni incorporate TrakEM2, segmentare le strutture di interesse, se necessario.

- Nella GUI di TrakEM2, fare clic con il pulsante destro del mouse su Qualsiasi cosa nella finestra Modello e selezionare Aggiungi nuovo figlio > Area_list.

- Trascinare e rilasciare Qualsiasi elemento nella parte superiore della cartella in Oggetti di progettoe verrà visualizzato Qualsiasi elemento.

- Trascinare l'elenco Area dal modello all'elenco Qualsiasi elemento che si trova in Oggetti progetto.

- Nella finestra dello stack di immagini, selezionare lo spazio con il cursore. Apparirà l'elenco delle aree, con un numero ID univoco. Selezionare lo strumento pennello in alto (in basso a destra) e utilizzare il mouse per segmentare una struttura riempiendo il suo citosol, sull'intero stack z.

- Esportare la maschera segmentata da utilizzare in ilastik come seeding per l'intaglio facendo clic con il pulsante destro del mouse sull'oggetto elenco Area nell'elenco Spazio z o sulla maschera nella finestra e selezionare Esporta > Area elenchi come etichette (tif).

- A seconda della risoluzione necessaria per ulteriori ricostruzioni, se possibile, ridurre le dimensioni in pixel dello stack di immagini mediante il downsampling, considerando i requisiti di memoria del software che verrà utilizzato per la segmentazione e la ricostruzione. Usa immagine > Regola > Dimensioni.

NOTA: ilastik gestisce stack fino a 500 pixel su xy pozzetto. Inoltre, il downsampling ridurrà la risoluzione dello stack; pertanto, prendere in considerazione la dimensione minima alla quale l'oggetto appare ancora riconoscibile e, quindi, può essere segmentato. - Per migliorare il contrasto e aiutare la segmentazione, il filtro Maschera di contrasto può essere applicato per rendere le membrane più nitide. Usa Processo > Filtro > Maschera di contrasto.

- Esportare la pila di immagini come singole immagini per un'ulteriore elaborazione nel software di segmentazione (ad esempio, ilastik), utilizzando File > Salva con nome... > Sequenza immagini e scegliere formato .tif.

2. Segmentazione (semi-automatica) e ricostruzione con ilastik 1.3.2

- Nella GUI principale di ilastik, selezionare il modulo Intaglio.

- Caricare la pila di immagini utilizzando Aggiungi nuovo > Aggiungi un singolo volume 3D/4D dalla sequenza.

- Selezionare Intera directory e scegliere la cartella contenente la pila di immagini salvata come singoli file. Nella parte inferiore della nuova finestra, in cui sono presenti le opzioni per il caricamento delle immagini, assicurarsi di mantenere selezionata l'opzione .

- Per i seguenti passaggi, tutte le operazioni e i pulsanti si trovano sul lato sinistro della GUI principale del software. Nella scheda Pre-elaborazione, utilizzare le opzioni standard già selezionate. Utilizzare linee luminose (filtri di cresta) e mantenere la scala del filtro a 1.600. Questo parametro può essere modificato in seguito.

- Al termine della pre-elaborazione, selezionare la pagina successiva nel menu a discesa del modulo Etichettatura. Un oggetto e uno sfondo sono presenti per impostazione predefinita.

-

Selezionare il valore di serie dell'oggetto facendo clic su di esso e disegnare una linea sopra la struttura di interesse; quindi, selezionare il seme di sfondo e disegnare una o più linee all'esterno dell'oggetto da ricostruire. Quindi, fare clic su Segmento e attendere.

NOTA: a seconda della potenza del computer e delle dimensioni dello stack, la segmentazione potrebbe richiedere da pochi secondi alle ore. Al termine, una maschera semitrasparente che evidenzia la segmentazione dovrebbe apparire sopra la struttura segmentata.- Scorrere la pila per verificare la segmentazione. La segmentazione potrebbe non essere accurata e non seguire con precisione la struttura di interesse o fuoriuscire da essa. Correggere la fuoriuscita posizionando un seme di sfondo sulla segmentazione versata e aggiungere un valore di seme dell'oggetto non ricostruito dell'oggetto di interesse.

- Se la segmentazione non è ancora corretta, provare a modificare con il parametro Bias, che aumenterà o diminuirà la quantità di pixel classificati incerti come accettati. Il valore è 0,95 per impostazione predefinita; ridurlo per limitare eventuali ricadute (di solito a non meno di 0,9) o aumentare se la segmentazione è troppo conservativa (fino a 1).

- Un'altra possibilità è quella di tornare al passaggio 2.4 (cliccando su Pre-elaborazione)e di modificare le dimensioni del filtro; aumentando il valore (ad esempio, a 2) si ridurranno al minimo gli effetti simili al rumore di sale e pepe, ma renderà anche le membrane più sfocate e dettagli più piccoli più difficili da rilevare. Questo potrebbe limitare la fuoriuscita.

- Ribadisci il più possibile, purché tutti gli oggetti desiderati siano stati segmentati. Una volta che un oggetto è finito, clicca su Salva oggetto corrente, sotto Segmento. Appariranno due nuovi semi, per iniziare la segmentazione di un nuovo oggetto.

- Estrarre le maglie di superficie immediatamente come file .obj facendo clic su Esporta tutte le maglie.

- Se è necessaria un'ulteriore correzione delle bozze, la segmentazione può essere estratta come maschere binarie. Selezionare la maschera per esportarla facendo clic su Sfoglia oggetti; quindi, fare clic con il pulsante destro del mouse su Segmentazione > Esporta e, in Informazioni file di output,selezionare tif sequenza come formato.

3. Correzione/Segmentazione (Manuale) in TrakEM2 (Fiji)

- Caricare la pila di immagini e creare un nuovo progetto TrekEM2 come da passo 1.6.1.

- Importare le maschere che necessitano di correzione di bozze utilizzando l'opzione Importa etichette come elenchi di aree, disponibili nello stesso menu di importazione utilizzato per importare la pila di immagini.

- Selezionate l'elenco delle aree importato nello spazio z e usate lo strumento Pennello per rivedere la segmentazione.

- Visualizzare il modello in 3D facendo clic con il pulsante destro del mouse sull'elenco Area > Mostra in 3D. Nella finestra seguente che richiede un numero di ricampionamento, un valore più alto genererà una mesh a risoluzione inferiore.

NOT: A seconda delle dimensioni dell'oggetto, prendere in considerazione l'utilizzo di un valore compreso tra 4 e 6, che di solito fornisce il miglior compromesso tra risoluzione e dettaglio morfologico. - Esportare la mesh 3D come .obj fronte onda scegliendo dal menu File > Esporta superfici > Wavefront.

4. Analisi 3D

- Aprire Blender. Per i passaggi seguenti, assicurarsi di installare il toolkit NeuroMorph (disponibile all'https://neuromorph.epfl.ch/index.html) e il toolkit di analisi del glicogeno (disponibile allhttps://github.com/daniJb/glyco-analysis).

- Importare gli oggetti utilizzando l'importazione batch NeuroMorph facendo clic su Importa oggetti nel menu Scena per importare più oggetti contemporaneamente. Assicurarsi di attivare Usa mesh e Ombreggiatura uniforme.

NOT: Non è consigliabile fare clic su Finalizza remesh se c'è incertezza sulla dimensione iniziale dell'oggetto. La profondità dell'albero di importazione al valore 7 (predefinito) è in genere buona per mantenere una risoluzione e una morfologia accettabili dell'oggetto. - Selezionare l'oggetto di interesse dal outliner e modificare la profondità octree della funzione remesh nel menu Modificatori in modo iterativo per ridurre al minimo il numero di vertici ed evitare di perdere dettagli in risoluzione e morfologia corretta. Quando si modifica la profondità dell'octree, la mesh sulla GUI principale cambierà di conseguenza. Al termine, fare clic su Applica per finalizzare il processo.

NOT: I valori intorno a 4 sono di solito buoni per piccoli oggetti (come le densità post-sinaptiche), i valori intorno a 7 per quelli più grandi (come assoni lunghi o dendriti), e i valori intorno a 8 o 9 per le morfologie complete in cui i dettagli delle diverse risoluzioni devono essere Mantenuto. - Usate lo strumento di sovrapposizione delle immagini Interazioni stack di immagini nel pannello di sinistra, sotto il menu NeuroMorph, per caricare la pila di immagini. Assicurarsi di immettere le dimensioni fisiche della pila di immagini per x, ye x (in micron o nanometri, a seconda delle unità della mesh) e selezionare il percorso della pila facendo clic su Sorgente_. X e Y sono piani ortogonali; sono facoltativi e verranno caricati solo se l'utente inserisce un percorso valido.

- Quindi, selezionare una mesh sulla finestra facendo clic con il pulsante destro del mouse su di essa, accedere alla modalità di modifica premendo TAB, selezionare uno (o più) vertici con il tasto destro del mouse e infine fare clic su Mostra immagine al vertice. Uno (o più) piani tagliati con la micrografia appariranno sovrapposti sopra la mesh.

- Selezionare il piano di taglio facendo clic con il pulsante destro del mouse su di esso, premere CTRL e Ye scorrere il modello 3D utilizzando lo scorrimento del mouse. Questo può essere utilizzato anche come metodo di correzione delle bozze.

- Utilizzare gli strumenti di misurazione per le quantificazioni di superfici, volumi e lunghezze. Queste operazioni sono documentate in dettaglio da Jorstad et al.19 e sul sito Web NeuroMorph24.

- Utilizzare lo strumento di analisi glicogeno per quantificare la vicinanza del glicogeno verso spine e bouton. Le operazioni sono documentate in dettaglio in una precedente pubblicazione10 e nel repository di analisi del glicogeno25.

- Importare gli oggetti utilizzando l'importazione batch NeuroMorph facendo clic su Importa oggetti nel menu Scena per importare più oggetti contemporaneamente. Assicurarsi di attivare Usa mesh e Ombreggiatura uniforme.

- Eseguire GLAM23. Il codice, l'eseguibile e alcuni file di test sono disponibili nel repository GLAM26.

- Preparare due file di geometria in formato .ply: un file di origine contenente granuli di glicogeno e un file di destinazione contenente le superfici morfologia.

- Preparare tre file di mappa colori .ascii (ogni riga contenente t_norm(0..1) R(0..255) G(0..255) B(0..255)) per rappresentare i valori di assorbimento locali, i valori di picco e i valori medi di assorbimento.

- Eseguite lo script GLAM, con i file di geometria (passaggio 4.2.1) e i file colormap (passaggio 4.2.2), impostando il raggio di influenza (in micron), il valore massimo previsto di assorbimento e una soglia normalizzata per il clustering dei picchi di assorbimento. Per informazioni su altri parametri, eseguire lo script con l'opzione -help.

- Esportare i risultati come file .ply o .obj: oggetti di destinazione mappati a colori con valori GLAM, indicatori di picco di assorbimento rappresentati come sfere codificate a colori e oggetti con codifica a colori rispetto al valore medio di assorbimento.

- Aprire VR Data Interact. VR Data Il codice eseguibile di interazione è disponibile in un repository pubblico27.

- Importa le maglie da visualizzare, seguendo le istruzioni nel menu VR. Assicurarsi di importare i file obj calcolati nel passaggio 4.2.1, nel caso in cui sia necessaria un'analisi GLAM.

Risultati

Utilizzando la procedura presentata in precedenza, vengono illustrati i risultati in due stack di immagini di dimensioni diverse, per dimostrare come la flessibilità degli strumenti consente di scalare la procedura a set di dati più grandi. In questo caso, i due set di dati 3DEM sono (i) ratto P14, corteccia somatosensoriale, strato VI, 100 m x 100 m x 76,4 m4 e (ii) ratto P60, ippocampo CA1, 7,07 m x 6,75 m x 4,73 mx 10.

I passaggi di pre-elaborazione (Figura 1) possono essere eseguiti allo stesso modo per entrambi i set di dati, semplicemente tenendo conto che un set di dati più grande, ad esempio il primo stack, ovvero 25 GB, richiede hardware più performante per gestire la visualizzazione e l'elaborazione di dati di grandi dimensioni . Il secondo stack è solo 1 GB, con una dimensione voxel perfettamente isotropico.

La dimensione dei dati potrebbe non essere direttamente correlata al campo visivo (FOV), piuttosto che alla risoluzione dello stack stesso, che dipende dalla dimensione massima in pixel del sensore del microscopio e dall'ingrandimento dello stack. In ogni caso, logicamente, è probabile che i FOV più grandi occupino più spazio fisico rispetto ai FOV più piccoli, se acquisiti alla stessa risoluzione.

Una volta importato lo stack di immagini, come indicato nella sezione 1 del protocollo, nel software Fiji (Figura 1A), una versione scientifica di ImageJ12, un punto importante è assicurarsi che il formato dell'immagine sia a 8 bit (Figura 1B). Questo perché molte aziende di microscopia di acquisizione diverse produttori di produttori generano il loro formato di file proprietario a 16 bit per memorizzare i metadati rilevanti per le informazioni sul processo di acquisizione (cioè, dimensione dei pixel, spessore, corrente/tensione del fascio di elettroni, pressione della camera) insieme alla pila di immagini. Tali regolazioni consentono agli scienziati di risparmiare memoria, poiché l'extra 8 bit contenente metadati non influisce sulle immagini. Il secondo parametro importante da controllare è la dimensione del voxel, che consente quindi di eseguire la ricostruzione dopo la segmentazione sulla scala corretta (micrometri o nanometri; Figura 1B).

Le pile potrebbero richiedere il riallineamento e/o le cuciture se sono state acquisite utilizzando l'agustatura; queste operazioni possono essere eseguite all'interno di TrakEM2 (Figura 2A), anche se per quanto riguarda il riallineamento, le tecniche 3DEM automatizzate come FIB-SEM o 3View sono in genere ben riallineate.

Un ultimo passaggio richiede il filtraggio e, eventualmente, il downsampling della pila, a seconda di quali oggetti devono essere ricostruiti e se il downsampling influisce sul riconoscimento delle feature ricostruibili. Ad esempio, per lo stack più grande (della corteccia somatosensoriale dei ratti P14), non è stato possibile compromettere la risoluzione a beneficio dell'efficienza di ricostruzione, mentre per lo stack più piccolo (dell'ippocampo CA1 dei ratti P60), è stato possibile farlo perché la risoluzione era di gran lunga superiore a quella necessaria per ricostruire gli oggetti più piccoli. Infine, l'uso della maschera unsharp migliora la differenza tra le membrane e lo sfondo, rendendolo favorevole per le ricostruzioni di software come ilastik che utilizza gradienti per pre-valutare i confini.

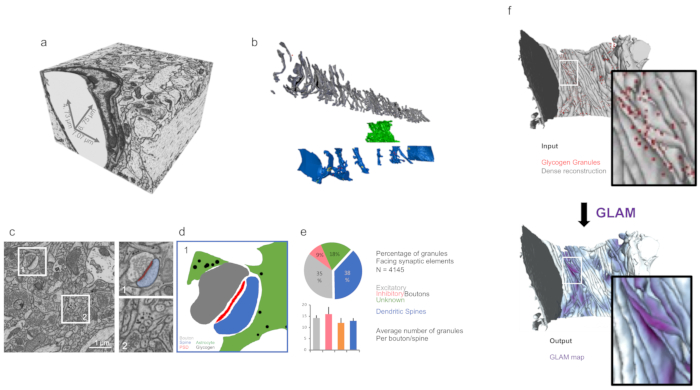

Dopo l'elaborazione dell'immagine, la ricostruzione può essere eseguita manualmente utilizzando TrakEM2 o semi-automaticamente utilizzando ilastik (Figura 2C). Un set di dati come quello più piccolo elencato qui (ii), che può essere campionato per adattarsi alla memoria, può essere completamente segmentato utilizzando ilastik (Figura 2B) per produrre una ricostruzione densa. Nel caso del primo set di dati elencato qui (i), siamo riusciti a caricare e pre-elaborare l'intero set di dati con una workstation Linux con 500 GB di RAM. La segmentazione sparse di 16 morfologie complete è stata ottenuta con una conduttura ibrida, estraendo la segmentazione ruvida che è stata revisionata manualmente utilizzando TrakEM2.

L'analisi 3D di funzioni quali superfici, volumi o distribuzione del glicogeno intracellulare può essere eseguita all'interno di un ambiente Blender (Figura 3) utilizzando codici personalizzati, come NeuroMorph19 o analisi glicogeno10.

Nel caso di set di dati contenenti anche granuli di glicogeno, è possibile dedurre l'analisi sulla loro distribuzione utilizzando GLAM, un codice C , che genererebbe mappe colore con area di influenza direttamente sulla mesh.

Infine, tali set di dati complessi possono essere visualizzati e analizzati utilizzando VR, che è stato dimostrato utile per l'analisi di set di dati con una particolare vista occlusa (Figura 4). Ad esempio, i picchi dedotti dalle mappe GLAM sono stati facilmente dedotti visivamente dai dendriti nel secondo set di dati descritto qui.

Figura 1: Elaborazione dell'immagine e preparazione per la segmentazione dell'immagine. (a) GUI principale delle Figi. (b) Esempio di immagini impilate dal set di dati (i) discusse nei risultati rappresentativi. Il pannello a destra mostra le proprietà che consentono all'utente di impostare le dimensioni del voxel. (c) Esempio di operazione di ridimensionamento e filer applicata a una singola immagine. I pannelli a destra mostrano gli ingrandimenti dal centro dell'immagine. Fare clic qui per visualizzare una versione più grande di questa figura.

Figura 2: Segmentazione e ricostruzione con TrakEM2 e ilastik. (a) ComME2 GUI con oggetti segmentati manualmente (in rosso). (b) La maschera esportata dal pannello a può essere utilizzata come input (seme) per (c) segmentazione semiautomatica (intaglio). Da ilastik, le maschere (rosso) possono essere ulteriormente esportate in TrakEM2 per la correzione manuale delle bozze. (d) Le maschere possono essere esportate come maglie triangolari 3D per rivelare strutture ricostruite. In questo esempio, quattro neuroni, astrociti, microglia e periciti dal set di dati (i) (discusso nei risultati rappresentativi) sono stati ricostruiti utilizzando questo processo. Fare clic qui per visualizzare una versione più grande di questa figura.

Figura 3: Analisi 3D delle morfologie ricostruite mediante strumenti personalizzati. (a) Volume di immagini isotropiche dal set di dati FIB-SEM (ii) (come discusso nei risultati rappresentativi). (b) Ricostruzione densa dal pannello a. Grigio - assoni; verde - processo astrocitico; blu - dendriti. (c) Micrografo che mostra esempi di obiettivi per le quantificazioni quali sinapsi (i)) e granuli di glicogeno astrocitico (set di dati (ii)) nelle giuste. (d) Maschera del pannello c che mostra la distribuzione di granuli di glicogeno intorno alle sinapsi. (e) Quantificazione della distribuzione del glicogeno dal set di dati del pannello c, utilizzando la cassetta degli attrezzi per l'analisi del glicogeno di Blender. Le barre di errore indicano errori standard. N - 4.145 granuli di glicogeno. (f) Illustrazione grafica della visualizzazione di input e output di GLAM. Fare clic qui per visualizzare una versione più grande di questa figura.

Figura 4: Analisi in VR. (a) Un utente che indossaun auricolare VR mentre lavora sulla densa ricostruzione dal set di dati FIB-SEM (ii) (come discusso nei risultati rappresentativi). (c) Scena VR immersiva da un sottoinsieme di neuriti dal pannello b. Il laser verde punta a un picco GLAM. (d) Esempio di analisi da conteggi picchi GLAM in VR. N - 3 topi per ogni barra. Analisi della FIB-SEM da una precedente pubblicazione28. Le barre di errore indicano gli errori standard; p < 0.1, ANOVA unidirezionale. Fare clic qui per visualizzare una versione più grande di questa figura.

Discussione

Il metodo qui presentato è un'utile guida passo-passo per la segmentazione e la ricostruzione 3D di un set di dati EM multiscala, sia che provengano da tecniche di imaging ad alta risoluzione, come FIB-SEM, o altre tecniche di sezionamento e imaging seriali automatizzate. FIB-SEM ha il vantaggio di raggiungere potenzialmente l'isotropia perfetta in formato voxel tagliando sezioni sottili fino a 5 nm utilizzando un fascio ionico focalizzato, il suo FOV potrebbe essere limitato a 15-20 m a causa di artefatti laterali, che sono probabilmente dovuti alla deposizione del tessuto tagliato se la FO V supera questo valore. Tali artefatti possono essere evitati utilizzando altre tecniche, come SBEM, che utilizza un coltello di adiamante per tagliare sezioni seriali all'interno della camera del microscopio. In quest'ultimo caso, la risoluzione z può essere di circa 20 nm nella migliore delle posizioni (in genere, 50 nm), ma il FOV potrebbe essere più grande, anche se la risoluzione dei pixel deve essere compromessa per una vasta area di interesse. Una soluzione per superare tali limitazioni (ingrandimento contro FOV) è quella di dividere la regione di interesse nelle piastrelle e acquisire ciascuno di essi ad una risoluzione più alta. Abbiamo mostrato qui i risultati di un set di dati dello stack SBEM (i) nei risultati rappresentativi, sia di un set di dati dello stack FIB-SEM (ii) nei risultati rappresentativi.

Man mano che la generazione di set di dati sempre più grandi e grandi sta diventando sempre più comune, gli sforzi per la creazione di strumenti per la classificazione dei pixel e la segmentazione automatica delle immagini si moltiplicano; tuttavia, ad oggi, nessun software ha dimostrato un'affidabilità paragonabile a quella della revisione umana, che è quindi ancora necessaria, indipendentemente dal suo dispendioso in termini di tempo. In generale, i set di dati più piccoli che possono essere sottocampionati, come nel caso del set di dati (ii), possono essere ricostruiti densamente da un singolo utente esperto in una settimana, incluso il tempo di correzione delle revisioni.

Il protocollo qui presentato prevede l'uso di tre programmi software in particolare: Fiji (versione 2.0.0-rc-65/1.65b), ilastik (versione 1.3.2 rc2) e Blender (2.79), che sono tutti programmi open-source e multi-piattaforma e scaricabili gratuitamente. Fiji è un rilascio di ImageJ, alimentato da plugin per l'analisi biologica delle immagini. Ha un'architettura software robusta ed è suggerito in quanto è una piattaforma comune per gli scienziati della vita e comprende TrakEM2, uno dei primi e più ampiamente utilizzati plugin per la segmentazione delle immagini. Un problema sperimentato da molti utenti ultimamente è la transizione da Java 6 a Java 8, che sta creando problemi di compatibilità; pertanto, si consiglia di astenersi dall'aggiornamento a Java 8, se possibile, per consentire alle Figi di funzionare correttamente. ilastik è un potente software che fornisce una serie di quadri per la classificazione dei pixel, ognuno documentato e spiegato sul loro sito web. Il modulo di intaglio utilizzato per la segmentazione semi-automatica degli stack EM è conveniente in quanto consente di risparmiare molto tempo, consentendo agli scienziati di ridurre il tempo dedicato al lavoro manuale da mesi a giorni per un utente esperto, come con un solo clic un intero neurite può essere segmentati in pochi secondi. La fase di pre-elaborazione è molto intensa dal punto di vista hardware e set di dati molto grandi, come lo stack SBEM presentato qui, che era di 26 GB, richiedono strategie peculiari per adattarsi alla memoria, considerando che si acquisirebbe set di dati di grandi dimensioni perché non è possibile campo di opinione e risoluzione di compromesso. Pertanto, il downsampling potrebbe non essere una soluzione appropriata in questo caso. L'ultima versione del software può fare la pre-elaborazione in poche ore con una potente workstation Linux, ma la segmentazione richiederebbe minuti, e scorrendo attraverso lo stack sarebbe ancora relativamente lento. Usiamo ancora questo metodo per una prima segmentazione approssimativa e ne leggiamo la prova usando TrakEM2. Infine, Blender è un software di modellazione 3D, con un potente motore di rendering 3D, che può essere personalizzato con script pitone che possono essere incorporati nella GUI principale come componenti aggiuntivi, come NeuroMorph e analisi glicogeno. La flessibilità di questo software viene fornito con lo svantaggio che, a differenza delle Fiji, per esempio, non è progettato per la visualizzazione online di grandi set di dati; pertanto, la visualizzazione e la navigazione tra grandi dimensioni (superiore a 1 GB) potrebbero essere lente e non efficienti. Per questo motivo, è sempre consigliabile scegliere tecniche che riducano la complessità della maglia ma stiano attenti a non interrompere la morfologia originale della struttura di interesse. La funzione remesh è utile ed è una funzionalità incorporata dello strumento di importazione batch NeuroMorph. Un problema con questa funzione è che, a seconda del numero di vertici della mesh originale, il valore di profondità dell'octree, che è correlato alla risoluzione finale, deve essere modificato di conseguenza. Gli oggetti piccoli possono essere ristampati con una piccola profondità di octree (ad esempio 4), ma lo stesso valore potrebbe interrompere la morfologia di oggetti più grandi, che ha bisogno di valori più grandi (6 al massimo, a 8 o anche 9 per una mesh molto grande, come una cella completa). Si consiglia di rendere iterativo questo processo e testare le diverse profondità dell'octree se le dimensioni dell'oggetto non sono chiare.

Come accennato in precedenza, un aspetto che dovrebbe essere preso in considerazione è la potenza di calcolo da dedicare alla ricostruzione e all'analisi, relative al software che viene utilizzato. Tutte le operazioni mostrate nei risultati rappresentativi di questo manoscritto sono state ottenute utilizzando un MacPro, dotato di una scheda grafica AMD FirePro D500, 64 GB di RAM e una CPU Intel Xeon E5 con 8 core. Fiji ha una buona architettura software per la gestione di grandi set di dati; pertanto, si consiglia di utilizzare un computer portatile con buone prestazioni hardware, ad esempio un MacBook Pro con una CPU Intel i7 da 2,5 GHz e 16 GB di RAM. Il software ilastik è più esigente in termini di risorse hardware, in particolare durante la fase di pre-elaborazione. Anche se il downsampling dello stack di immagini è un buon trucco per limitare le richieste hardware dal software e consente all'utente di elaborare una pila con un computer portatile (in genere se è inferiore a 500 pixel in x,y,z), suggeriamo l'uso di un high-end computer per eseguire questo software senza problemi. Utilizziamo una workstation dotata di CPU Intel Xeon Gold 6150 con 16 core e 500 GB di RAM.

Quando viene fornita una ricostruzione 3D accurata, gli scienziati possono eliminare i micrografi originali e lavorare direttamente sui modelli 3D per estrarre dati morfometrici utili per confrontare cellule dello stesso tipo, nonché diversi tipi di cellule, e sfruttare la realtà virtuale per valutazioni qualitative e quantitative delle morfologie. In particolare, l'uso di quest'ultimo si è dimostrato vantaggioso nel caso di analisi di morfologie dense o complesse che presentano occlusione visiva (cioè il blocco di vista di un oggetto di interesse nello spazio 3D da parte di un secondo posto tra l'osservatore e la fi rst oggetto), rendendo difficile rappresentarli e analizzarli in 3D. Nell'esempio presentato, un utente esperto ha impiegato circa 4 ore non consecutive per osservare i set di dati e contare gli oggetti. Il tempo dedicato all'analisi della realtà virtuale può variare in quanto aspetti come la malattia della realtà virtuale (che può, in una certa misura, essere correlata al mal d'auto) possono avere un impatto negativo sull'esperienza utente; in questo caso, l'utente potrebbe preferire altri strumenti di analisi e limitare il tempo dedicato alla realtà virtuale.

Infine, tutti questi passaggi possono essere applicati ad altre tecniche di microscopia e non EM che generano pile di immagini. EM genera immagini che sono, in generale, difficili da gestire e segmentare, rispetto, ad esempio, alla microscopia a fluorescenza, dove qualcosa di paragonabile a una maschera binaria (segnale contro sfondo nero), che in linea di principio può essere prontamente resa in 3D per un'ulteriore elaborazione, spesso deve essere affrontata.

Divulgazioni

Gli autori non hanno nulla da rivelare.

Riconoscimenti

Questo lavoro è stato sostenuto dalla sovvenzione "KAUST-BBP Alliance for Integrative Modelling of Brain Energy Metabolism" della King Abdullah University of Science and Technology (KAUST) "KAUST-BBP Alliance for Integrative Modelling of Brain Energy Metabolism" a P.J.M.

Materiali

| Name | Company | Catalog Number | Comments |

| Fiji | Open Source | 2.0.0-rc-65/1.65b | Open Source image processing editor www.fiji.sc |

| iLastik | Open Source | 1.3.2 rc2 | Image Segmentation tool www.ilastik.org |

| Blender | Blender Foundation | 2.79 | Open Source 3D Modeling software www.blender.org |

| HTC Vive Headset | HTC | Vive / Vive Pro | Virtual Reality (VR) Head monted headset www.vive.com |

| Neuromorph | Open Source | --- | Collection of Blender Addons for 3D Analysis neuromorph.epfl.ch |

| Glycogen Analysis | Open Source | --- | Blender addon for analysis of Glycogen https://github.com/daniJb/glyco-analysis |

| GLAM | Open Source | --- | C++ Code For generating GLAM Maps https://github.com/magus74/GLAM |

Riferimenti

- Leighton, S. B. SEM images of block faces, cut by a miniature microtome within the SEM - a technical note. Scanning Electron Microscopy. , 73-76 (1981).

- Knott, G., Marchman, H., Wall, D., Lich, B. Serial section scanning electron microscopy of adult brain tissue using focused ion beam milling. Journal of Neuroscience. 28, 2959-2964 (2008).

- Denk, W., Horstmann, H. Serial block-face scanning electron microscopy to reconstruct three-dimensional tissue nanostructure. PLOS Biology. 2, e329 (2004).

- Coggan, J. S., et al. A Process for Digitizing and Simulating Biologically Realistic Oligocellular Networks Demonstrated for the Neuro-Glio-Vascular Ensemble. Frontiers in Neuroscience. 12, (2018).

- Tomassy, G. S., et al. Distinct Profiles of Myelin Distribution Along Single Axons of Pyramidal Neurons in the Neocortex. Science. 344, 319-324 (2014).

- Wanner, A. A., Genoud, C., Masudi, T., Siksou, L., Friedrich, R. W. Dense EM-based reconstruction of the interglomerular projectome in the zebrafish olfactory bulb. Nature Neuroscience. 19, 816-825 (2016).

- Kasthuri, N., et al. Saturated Reconstruction of a Volume of Neocortex. Cell. 162, 648-661 (2015).

- Calì, C., et al. The effects of aging on neuropil structure in mouse somatosensory cortex—A 3D electron microscopy analysis of layer 1. PLOS ONE. 13, e0198131 (2018).

- Calì, C., Agus, M., Gagnon, N., Hadwiger, M., Magistretti, P. J. Visual Analysis of Glycogen Derived Lactate Absorption in Dense and Sparse Surface Reconstructions of Rodent Brain Structures. , (2017).

- Calì, C., et al. Three-dimensional immersive virtual reality for studying cellular compartments in 3D models from EM preparations of neural tissues. Journal of Comparative Neurology. 524, 23-38 (2016).

- Fiala, J. C. Reconstruct: a free editor for serial section microscopy. Journal of Microscopy. 218, 52-61 (2005).

- Cardona, A., et al. TrakEM2 software for neural circuit reconstruction. PLOS ONE. 7, e38011 (2012).

- Januszewski, M., et al. High-precision automated reconstruction of neurons with flood-filling networks. Nature Methods. 1, (2018).

- Shahbazi, A., et al. Flexible Learning-Free Segmentation and Reconstruction of Neural Volumes. Scientific Reports. 8, 14247 (2018).

- Sommer, C., Straehle, C., Köthe, U., Hamprecht, F. A. Ilastik: Interactive learning and segmentation toolkit. , (2011).

- Holst, G., Berg, S., Kare, K., Magistretti, P., Calì, C. Adding large EM stack support. , (2016).

- Beyer, J., et al. ConnectomeExplorer: query-guided visual analysis of large volumetric neuroscience data. IEEE Transactions on Visualization and Computer Graphics. 19, 2868-2877 (2013).

- Beyer, J., et al. Culling for Extreme-Scale Segmentation Volumes: A Hybrid Deterministic and Probabilistic Approach. IEEE Transactions on Visualization and Computer. , (2018).

- Jorstad, A., et al. NeuroMorph: A Toolset for the Morphometric Analysis and Visualization of 3D Models Derived from Electron Microscopy Image Stacks. Neuroinformatics. 13, 83-92 (2015).

- Jorstad, A., Blanc, J., Knott, G. NeuroMorph: A Software Toolset for 3D Analysis of Neurite Morphology and Connectivity. Frontiers in Neuroanatomy. 12, 59 (2018).

- Calì, C. Astroglial anatomy in the times of connectomics. Journal of Translational Neuroscience. 2, 31-40 (2017).

- Mohammed, H., et al. Abstractocyte: A Visual Tool for Exploring Nanoscale Astroglial Cells. IEEE Transactions on Visualization and Computer Graphics. , (2017).

- Agus, M., et al. GLAM: Glycogen-derived Lactate Absorption Map for visual analysis of dense and sparse surface reconstructions of rodent brain structures on desktop systems and virtual environments. Computers & Graphics. 74, 85-98 (2018).

- École Polytechnique Fédérale de Lausanne. . NeuroMorph Analysis and Visualization Toolset. , (2018).

- . GitHub - daniJb/glycol-analysis: Glycogen_analysis.py is a python-blender API based script that performs analysis on a reconstructed module of glycogen data Available from: https://github.com/daniJb/glyco-analysis (2018)

- . GitHub – magus74/GLAM: Glycogen Lactate Absorption Model Available from: https://github.com/magus74/GLAM (2019)

- Agus, M., et al. GLAM: Glycogen-derived Lactate Absorption Map for visual analysis of dense and sparse surface reconstructions of rodent brain structures on desktop systems and virtual environments. Dryad Digital Repository. , (2018).

- Calì, C., et al. Data from: The effects of aging on neuropil structure in mouse somatosensory cortex—A 3D electron microscopy analysis of layer 1. Dryad Digital Repository. , (2018).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneEsplora altri articoli

This article has been published

Video Coming Soon