Method Article

Objektivierung der Zungendiagnostik in der traditionellen Medizin, Datenanalyse und Studienanwendung

* Diese Autoren haben gleichermaßen beigetragen

In diesem Artikel

Zusammenfassung

In der vorliegenden Studie wurden U-Net und andere Deep-Learning-Algorithmen verwendet, um ein Zungenbild zu segmentieren, und die Segmentierungsergebnisse verglichen, um die Objektivierung der Zungendiagnose zu untersuchen.

Zusammenfassung

Die Zungendiagnose ist eine wesentliche Technik der Diagnostik der Traditionellen Chinesischen Medizin (TCM), und der Bedarf an der Objektivierung von Zungenbildern durch Bildverarbeitungstechnologie wächst. Die vorliegende Studie gibt einen Überblick über die Fortschritte bei der Objektivierung der Zunge in den letzten zehn Jahren und vergleicht Segmentierungsmodelle. Es werden verschiedene Deep-Learning-Modelle konstruiert, um Algorithmen anhand von echten Zungenbildsätzen zu verifizieren und zu vergleichen. Die Stärken und Schwächen jedes Modells werden analysiert. Die Ergebnisse deuten darauf hin, dass der U-Net-Algorithmus andere Modelle in Bezug auf die Metriken "Precision Accuracy" (PA), "Recall" und "Mean Intersection over Union" (MIoU) übertrifft. Trotz der erheblichen Fortschritte bei der Aufnahme und Verarbeitung von Zungenbildern muss sich jedoch noch ein einheitlicher Standard für die objektivierende Zungendiagnose etablieren. Um die breite Anwendung von Zungenbildern, die mit mobilen Geräten aufgenommen wurden, bei der Objektivierung der Zungendiagnose zu erleichtern, könnte sich die weitere Forschung mit den Herausforderungen befassen, die sich aus Zungenbildern ergeben, die in komplexen Umgebungen aufgenommen werden.

Einleitung

Die Zungenbeobachtung ist eine weit verbreitete Technik in der traditionellen chinesischen ethnischen Medizin (TCM). Die Farbe und Form der Zunge kann den körperlichen Zustand und verschiedene Krankheitseigenschaften, Schweregrade und Prognosen widerspiegeln. In der traditionellen Hmong-Medizin wird beispielsweise die Farbe der Zunge verwendet, um die Körpertemperatur zu bestimmen, z. B. weist eine rote oder violette Zunge auf pathologische Faktoren im Zusammenhang mit Hitze hin. In der tibetischen Medizin wird ein Zustand beurteilt, indem die Zunge eines Patienten beobachtet wird, wobei auf die Farbe, Form und Feuchtigkeit des Schleims geachtet wird. Zum Beispiel werden die Zungen von Patienten mit Morbus Heyi rot und rau oder schwarz und trocken1; Patienten mit Morbus Xieri2 haben gelbe und trockene Zungen; Patienten mit Badakan-Krankheit3 haben eine weiße, feuchte und weiche Zunge4. Diese Beobachtungen zeigen den engen Zusammenhang zwischen den Merkmalen der Zunge und der Physiologie und Pathologie. Insgesamt spielt der Zustand der Zunge eine wichtige Rolle bei der Diagnose, der Identifizierung von Krankheiten und der Bewertung des Behandlungseffekts.

Gleichzeitig sind aufgrund der unterschiedlichen Lebensbedingungen und Ernährungspraktiken der verschiedenen ethnischen Gruppen Unterschiede in den Zungenbildern offensichtlich. Das Lab-Modell, das auf der Grundlage eines internationalen Standards für die Bestimmung der Farbe festgelegt wurde, wurde 1931 von der Commission International Eclairage (CIE) formuliert. 1976 wurde ein Farbmuster modifiziert und benannt. Das Lab-Farbmodell setzt sich aus drei Elementen zusammen: L entspricht der Helligkeit, während a und b zwei Farbkanäle sind. a umfasst Farben von Dunkelgrün (niedriger Helligkeitswert) über Grau (mittlerer Helligkeitswert) bis hin zu hellem Pink (hoher Helligkeitswert); b wechselt von hellblau (niedriger Helligkeitswert) über Grau (mittlerer Helligkeitswert) bis gelb (hoher Helligkeitswert). Durch den Vergleich der L x a x b-Werte der Zungenfarbe von fünf ethnischen Gruppen stellten Yang et al.5 fest, dass sich die Merkmale der Zungenbilder der Hmong-, Hui-, Zhuang-, Han- und mongolischen Gruppen signifikant voneinander unterschieden. Zum Beispiel haben die Mongolen dunkle Zungen mit einem gelben Zungenbelag, während die Hmong helle Zungen mit einem weißen Zungenbelag haben, was darauf hindeutet, dass Zungenmerkmale als diagnostischer Indikator zur Beurteilung des Gesundheitszustands einer Bevölkerung verwendet werden können. Darüber hinaus können Zungenbilder als Bewertungsindex für evidenzbasierte Medizin in der klinischen Forschung der ethnischen Medizin fungieren. Er et al.6 nutzten Zungenbilder als Grundlage für die TCM-Diagnose und bewerteten systematisch die Sicherheit und Wirksamkeit von Chou-Ling-Dan-Pellets (CLD-Granulat zur Behandlung von entzündlichen und fieberhaften Erkrankungen, einschließlich der saisonalen Influenza in der TCM) in Kombination mit chinesischer und westlicher Medizin. Die Ergebnisse belegen die wissenschaftliche Validität von Zungenbildern als Bewertungsindex für klinische Studien. Nichtsdestotrotz verlassen sich traditionelle Mediziner im Allgemeinen auf Subjektivität, um die Eigenschaften der Zunge zu beobachten und den physiologischen und pathologischen Zustand der Patienten zu beurteilen, was genauere Indikatoren erfordert.

Das Aufkommen des Internets und der Technologie der künstlichen Intelligenz hat den Weg für die Digitalisierung und Objektivierung der Zungendiagnose geebnet. Dieser Prozess beinhaltet die Verwendung mathematischer Modelle, um eine qualitative und objektive Beschreibung von Zungenbildern7 zu liefern, die den Inhalt des Zungenbildes widerspiegelt. Der Prozess umfasst mehrere Schritte: Bildaufnahme, optische Kompensation, Farbkorrektur und geometrische Transformation. Die vorverarbeiteten Bilder werden dann in ein algorithmisches Modell zur Bildpositionierung und -segmentierung, Merkmalsextraktion, Mustererkennung usw. eingespeist. Das Ergebnis dieses Prozesses ist eine hocheffiziente und präzise Diagnose von Zungenbilddaten, wodurch das Ziel der Objektivierung, Quantifizierung und Informatisierung der Zungendiagnoseerreicht wird 8. Damit wird das Ziel einer hocheffizienten und hochpräzisen Verarbeitung von Zungendiagnosedaten erreicht. Basierend auf dem Wissen über die Zungendiagnose und der Deep-Learning-Technologie wurden in dieser Studie mithilfe eines Computeralgorithmus automatisch der Zungenkörper und der Zungenbelag von den Zungenbildern getrennt, um die quantitativen Merkmale der Zungen für Ärzte zu extrahieren, die Zuverlässigkeit und Konsistenz der Diagnose zu verbessern und Methoden für die anschließende Forschung zur Objektivierung der Zungendiagnose bereitzustellen9.

Protokoll

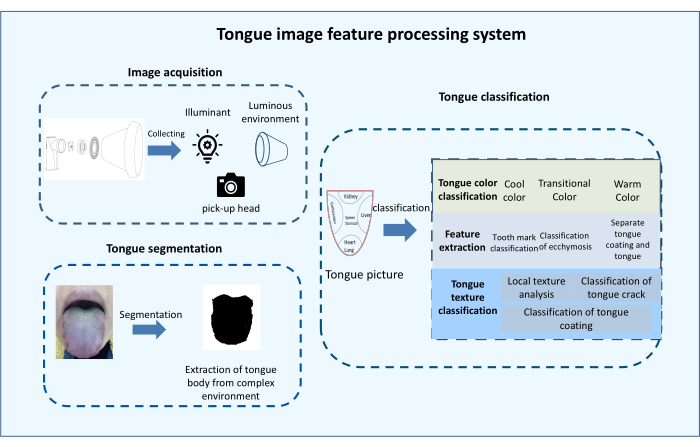

Diese Studie wurde von der National Natural Science Foundation of China genehmigt, das Projekt "Constructing Dynamic Change rules of TCM Facial image Based on Association Analysis". Die Ethikgenehmigungsnummer lautet 2021KL-027, und die Ethikkommission hat die klinische Studie genehmigt, die in Übereinstimmung mit den genehmigten Dokumenten durchgeführt werden soll, die das klinische Forschungsprotokoll (2021.04.12, V2.0), die Einwilligungserklärung (2021.04.12, V2.0), Materialien zur Rekrutierung von Probanden (2021.04.12, V2.0), Studienfälle und/oder Fallberichte, Tagebuchkarten und andere Fragebögen (2021.04.12, V2.0), eine Liste der Teilnehmer an der klinischen Studie, Bewilligung von Forschungsprojekten usw. Die an der Studie teilnehmenden Patienten wurden eingeholt. Der primäre experimentelle Ansatz dieser Studie besteht darin, reale Zungenbilder zu verwenden, um die Segmentierungseffekte des Modells zu validieren und zu vergleichen. Abbildung 1 zeigt die Komponenten der Objektivierung der Zungendiagnose.

1. Bildaufnahme

- Verwenden Sie das selbst entwickelte tragbare linguale Gesichtsdiagnoseinstrument, um linguale Gesichtsbilder von Patienten zu sammeln.

- Geben Sie den Namen, das Geschlecht, das Alter und die Krankheit des Patienten auf der Computerseite ein. Die hier gezeigten Bilder stammen von Patienten, die in die Klinik kamen und sich bereit erklärten, fotografiert zu werden, nachdem sie über den Zweck und den Inhalt der Studie informiert wurden. Vergewissern Sie sich, dass der Patient aufrecht sitzt, legen Sie das ganze Gesicht in das Bilderfassungsgerät und weisen Sie den Patienten an, seine Zunge so weit wie möglich aus dem Mund zu strecken.

- Halten Sie das Bildeinzugsgerät an einen Computer angeschlossen und überprüfen Sie anhand der Bilder auf dem Computerbildschirm, ob sich der Patient in der richtigen Position befindet und ob die Zunge und das Gesicht vollständig freiliegen.

- Drücken Sie die Aufnahmetaste auf dem Computerbildschirm dreimal, um drei Bilder aufzunehmen.

HINWEIS: Das Bilderfassungsgerät befindet sich derzeit nur in der Patentanmeldephase und ist nicht für die kommerzielle Nutzung bestimmt, daher wird es nicht zum Verkauf angeboten. - Wählen Sie die gesammelten Zungen- und Gesichtsbilder manuell aus und filtern Sie sie. Filtern und schließen Sie Bilder aus, die eine unvollständige Zungen- und Gesichtsbelichtung aufweisen, sowie Bilder, die aufgrund unzureichenden Lichts zu dunkel sind. Abbildung 2 zeigt die Bilderfassungsseite der Software.

- Sammeln Sie in der Versuchsplanung als Alternative drei Bilder von jedem Patienten gleichzeitig und wählen Sie ein relativ standardmäßiges, vollständig belichtetes, gut ausgeleuchtetes und klares Bild als Stichprobe für das anschließende Algorithmustraining und die Tests aus.

- Sammeln Sie Daten nach der Aufnahme, exportieren Sie die Daten für die manuelle Überprüfung und löschen Sie die nicht standardmäßigen Bilder, die mit bloßem Auge sichtbar sind. Verwenden Sie die folgenden Filter- und Ausschlusskriterien: unvollständige Zungen- und Gesichtsbelichtung und Bilder, die aufgrund von unzureichendem Licht zu dunkel sind. Ein Beispiel für ein unterbeleuchtetes, ein unvollständiges und ein Standardbild ist in Abbildung 3 dargestellt.

HINWEIS: Unzureichendes Licht wird in der Regel dadurch verursacht, dass der Patient das Gesicht nicht vollständig in das Instrument legt. Eine vollständige Belichtung wird in der Regel nur durch korrektes Fotografieren des Patienten erreicht.

2. Segmentierung der Zunge

- Führen Sie die Segmentierung von Zungenbildern mit einem Online-Anmerkungstool durch, wie unten beschrieben.

- Installieren Sie Labelme, klicken Sie auf die Schaltfläche Öffnen in der oberen linken Ecke der Etikettenoberfläche, wählen Sie den Ordner aus, in dem sich das Bild befindet, und öffnen Sie die Fotos.

- Klicken Sie auf Polygon erstellen , um Tracking-Punkte zu starten, verfolgen Sie die Zungen- und Zungenformen, benennen Sie sie entsprechend den ausgewählten Bereichen (z. B. Zunge und Zungenoberfläche) und speichern Sie sie.

- Wenn alle Markierungen vollständig sind, klicken Sie auf Speichern , um das Bild im Datenordner zu speichern. In Abbildung 4 finden Sie ein detailliertes Flussdiagramm.

HINWEIS: Da die Bilder Pixelunterschiede aufweisen können, können die Bilder nicht direkt für das Training und Testen von Algorithmen verwendet werden.

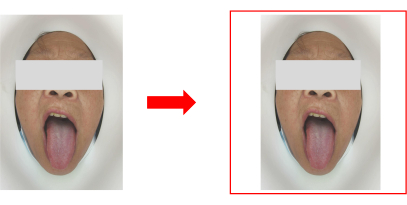

- Vereinheitlichen Sie die Bilder auf die gleiche Größe, indem Sie die Bilder mit der langen Seite des Bildes als Zielfülllänge füllen und die Bilder mit weißen Kanten füllen, um die Bilder zu einem Quadrat zu füllen, wobei die lange Seite des Bildes die Kantenlänge ist. Die vom Gerät erfasste Bildgröße beträgt 1080 x 1920 Pixel und die Größe des gefüllten Bildes 1920 x 1920 Pixel. Siehe Abbildung 5.

- Wenden Sie bei Bedarf Bildverbesserungen an. In dieser Studie wurde keine Verbesserung vorgenommen, da die verwendeten Bilder in einer festen Szene aufgenommen wurden und weniger von der Umgebung, der Beleuchtung und anderen Faktoren beeinflusst wurden.

- Da während des Aufnahmeprozesses für jeden Patienten drei Bilder aufgenommen wurden, um unkontrollierbare Faktoren wie das Blinzeln des Motivs und das Blockieren des Objektivs zu berücksichtigen, sollten Sie die Bilder jedes Patienten manuell überprüfen, um ein Bild pro Patient zu erhalten.

- Sammeln Sie zum Trainieren des Modells Daten von 200 Personen oder 600 Bildern. Behalten Sie nach der Vorführung etwa 200 brauchbare Bilder.

- Teilen Sie je nach Bildnummer alle Zungenbilder nach dem Zufallsprinzip auf und platzieren Sie 70 % davon in den Trainingssatz und 30 % in den Testsatz in einer Tabelle.

3. Klassifizierung der Zunge

- Gehen Sie auf die offiziellen Websites und laden Sie Anaconda, Python und Labelme herunter und installieren Sie sie. Aktivieren Sie die Umgebung und schließen Sie die Installation und Anpassung der Gesamtumgebung ab. In Abbildung 6 finden Sie ein Flussdiagramm, das die Installation und Einrichtung der Software beschreibt.

- Erstellen Sie das Deep-Learning-Algorithmusmodell in der installierten Umgebung, optimieren Sie die Parameter, und schließen Sie das Modelltraining mit dem Trainingssatz ab. Führen Sie die Modellauswahl und -optimierung wie in den folgenden Schritten beschrieben durch.

- Modellauswahl: Wählen Sie das geeignete Modell basierend auf dem Zweck der Recherche aus. Nach einer Überprüfung der Forschung zur Bildverarbeitung von Zungen in den letzten 5 Jahren wurden vier Algorithmen, U-Net, Seg-Net, DeeplabV3 und PSPNet, für die Validierung in dieser Studie ausgewählt (siehe Supplementary Coding File 1, Supplementary Coding File 2, Supplementary Coding File 3 und Supplementary Coding File 4 für Modellcodes).

- Datensatzkonstruktion: Nach Abschluss der Modellauswahl konstruieren Sie den benötigten Datensatz in Verbindung mit den Forschungsinhalten, hauptsächlich unter Verwendung der Labelme-Annotation und der oben beschriebenen Methoden der einheitlichen Bildgröße.

- Führen Sie das Modelltraining wie unten beschrieben durch. Abbildung 7 zeigt Details des Algorithmus-Trainingsvorgangs.

- Geben Sie die Daten zur Vorwärtsausbreitung in das neuronale Netzwerk ein, wobei jedes Neuron zuerst eine gewichtete Ansammlung von Werten eingibt und dann eine Aktivierungsfunktion als Ausgabewert dieses Neurons eingibt, um das Ergebnis zu erhalten.

- Geben Sie das Ergebnis in die Fehlerfunktion ein und vergleichen Sie es mit dem erwarteten Wert, um den Fehler zu erhalten und den Grad der fehlerhaften Erkennung zu beurteilen. Je kleiner die Verlustfunktion ist, desto besser ist das Modell.

- Reduzieren Sie den Fehler durch Backpropagation und bestimmen Sie den Gradientenvektor. Passen Sie die Gewichtungen anhand des Verlaufsvektors an den Trend zu den Ergebnissen an, sodass der Fehler gegen Null tendiert oder schrumpft.

- Wiederholen Sie diesen Trainingsvorgang, bis der Satz abgeschlossen ist oder der Fehlerwert nicht mehr abnimmt, woraufhin das Modelltraining abgeschlossen ist. In Abbildung 8 finden Sie ein Flussdiagramm des Algorithmusmodells beim Trainieren und Testen.

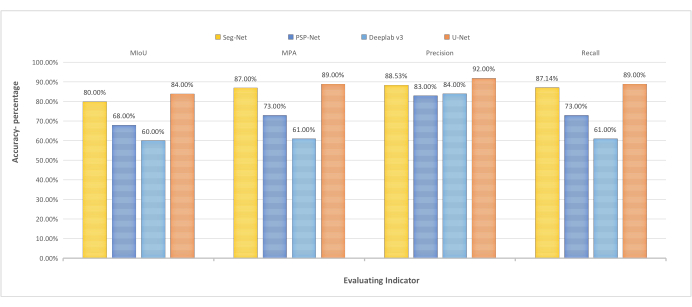

- Testen Sie die vier Modelle mit denselben Testdaten für die Segmentierung, und beurteilen Sie die Modellleistung anhand des Segmentierungseffekts. Die vier Metriken Precision, Recall, Mean Pixel Accuracy (MPA) und MIoU ermöglichen eine umfassendere Bewertung der Modellleistung.

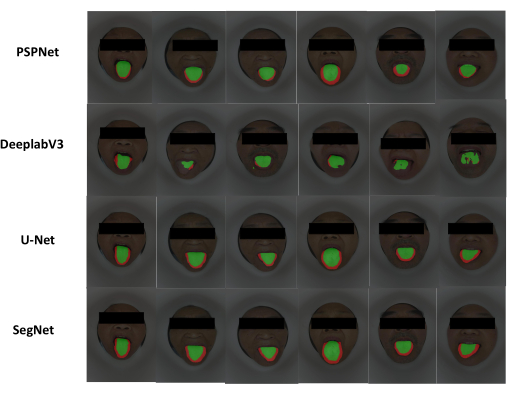

- Nachdem die Ergebnisse der vier Modelle generiert wurden, vergleichen Sie ihre Werte horizontal. Je höher der Wert ist, desto höher ist die Segmentierungsgenauigkeit und desto besser ist die Leistung des Modells. Siehe Abbildung 9, Abbildung 10 und Abbildung 11.

Ergebnisse

Die Vergleichsergebnisse finden Sie in Abbildung 12, Abbildung 13 und Tabelle 1, in denen in der in dieser Studie erstellten Umgebung dieselben Stichproben zum Trainieren und Testen des Algorithmusmodells verwendet werden. MIoU-Indikator: U-Net > Seg-Net > PSPNet > DeeplabV3; MPA-Indikator: U-Net > Seg-Net > PSPNet > DeeplabV3; Präzisionsanzeige: U-Net > Seg-Net > DeeplabV3 > PSPNet; Rückruf: U-Net > Seg-Net > PSPNet > DeeplabV3. Je größer der Indexwert ist, desto höher ist die Segmentierungsgenauigkeit und desto besser ist die Modellleistung. Anhand der Indexergebnisse kann analysiert werden, dass der U-Net-Algorithmus den anderen Algorithmen in MIoU, MPA, Precision und Recall überlegen ist und auch seine Segmentierungsgenauigkeit höher ist als die der anderen Algorithmen. Daher hat der U-Net-Algorithmus die beste Leistung unter den vier verschiedenen Algorithmen. PSPNet ist in MIoU, MPA und Recall besser als DeeplabV3, während das DeeplabV3-Modell in allen Indizes niedriger ist als das Seg-Net-Modell. Daraus kann geschlussfolgert werden, dass der DeeplabV3-Algorithmus unter den vier Algorithmen in diesem Forschungsumfeld die am wenigsten wünschenswerte umfassende Leistung aufweist.

Evaluierungsindikatoren

In dieser Studie wurde die Leistungsfähigkeit des Algorithmusmodells hauptsächlich durch Precision, Recall, MPA und MIoU validiert. Die Leistungsmetriken des Modells stehen in direktem Zusammenhang mit der Konfusionsmatrix, die aus den Ergebnissen der Modellklassifizierung besteht und die Anzahl der Stichproben widerspiegelt, die das Modell richtig und falsch klassifiziert hat. Die Matrix stellt den geschätzten Wert dar, der den Ergebnissen des Testsatzes entspricht, und der tatsächliche Wert stellt die Grundwahrheit dar. Beide Kategorien werden in wahr und falsch unterteilt, dargestellt durch T bzw. F, was zu vier Kombinationen führt: TP, FP, FN und TN.MPA ist der Mittelwert des Anteils der korrekt klassifizierten Pixel in jeder Kategorie und MIoU ist das mittlere Schnittpunkt-zu-Zusammenführungsverhältnis. Dies ist die gebräuchlichste Metrik für die semantische Segmentierung. Es berechnet das Verhältnis des Schnittpunkts und führt die wahren und vorhergesagten Werte10 zusammen. Die Formel dafür lautet:

Genauigkeit = , Rückruf = , MPA = (CPA = , wobei N die Gesamtzahl der Kategorien ist) und MIoU =

(IoU= ).

(IoU= ).

Diese vier Metriken bieten eine umfassendere Bewertung des Segmentierungseffekts von Zungenbildern.

In dieser Studie wurden vier Deep-Learning-Algorithmusmodelle, U-Net, Seg-Net, DeeplabV3 und PSPNet, ausgewählt, um die Algorithmusmodelle mit echten lingualen Bilddaten zu trainieren und zu testen. U-Net11 verfügt über eine U-förmige Architektur, bestehend aus einem Encoder auf der linken und einem Decoder auf der rechten Seite, und hat den Vorteil, dass genauere Klassifizierungsergebnisse mit weniger Daten trainiert und Bildmerkmale umfassend extrahiert werden können. Basierend auf dem Res-Net-Netzwerk zur Lösung des Problems der Zielsegmentierung mit mehreren Skalen übernimmt DeepLabV3 die hohle Faltungsstruktur, entwirft das Modul, um den Kontext mit mehreren Skalen zu erfassen, entfernt das bedingte Zufallsfeld (CRF) und aktualisiert das ASPP-Modul (Atrous Spatial Pyramid Pooling), wodurch die Modellleistung erheblich verbessert wird. Die semantische Segmentierung zielt darauf ab, die Kategoriebezeichnung für jedes Pixel des segmentierten Objekts abzurufen. Seg-Net ist eine CNN-Architektur (Convolutional Neural Network) mit einer symmetrischen Struktur für die semantische Segmentierung, einschließlich eines Encoders und eines Decoders. Dies hat den Vorteil, dass die Up-Sampling-Methode des Decoders für Feature-Diagramme mit niedrigerer Auflösung die Up-Sampling-Lernzeit eliminiert. Das PSPNet-Modell wird hauptsächlich auf das Parsen von Szenen angewendet, indem es der semantischen Segmentierung Kontextinformationen hinzufügt, wodurch partielle Fehler vermieden, das Problem des Fehlens geeigneter Strategien zur Verwendung globaler Szenenklassifizierungsinformationen gelöst und die Zuverlässigkeit der endgültigen vorhergesagten Ergebnisse verbessert werden kann.

Abbildung 1: Komponenten der Objektivierung der Zungendiagnose. Komponenten für die Zungendiagnose, einschließlich Bildaufnahmeelemente, Zungensegmentierung und Zungenklassifizierung. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 2: Bilderfassungsseite. Zungenbilderfassungsschnittstelle und Fragebogeninhalt. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 3: Bildfilterung und Ablehnungskriterien. Ein grünes Häkchen steht für Einschlusskriterien und ein rotes Kreuz für Ausschlusskriterien. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 4: Schematische Darstellung des Labelme-Markierungsprozesses. Die Labelme-Software wird verwendet, um den gesamten Prozess des Bildes zu kommentieren, vom Öffnen des Ordners bis zum Speichern der Datei. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 5: Diagramm der Bildvorverarbeitung. Die Größe des aufgenommenen Bildes beträgt 1080 x 1920 Pixel und die Größe des Füllbildes 1920 x 1920 Pixel. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 6: Flussdiagramm der Umgebungskonfiguration. Der Algorithmus kann erst ausgeführt werden, nachdem die Umgebung konfiguriert wurde. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 7: Detaildiagramm des Algorithmustrainingslaufs. Detaillierte Schritte und Ausführungsmethoden im Algorithmusbetrieb. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 8: Flussdiagramm des Algorithmusmodells beim Trainieren und Testen. Die wichtigen Schritte des Algorithmus, einschließlich Datenverarbeitung, Algorithmustraining und Algorithmustests. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 9: Struktur des Seg-Net-Algorithmus. Seg-Net-Algorithmus, logische Struktur und Code-Ausführungsprozess. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 10: Struktur des U-Net-Algorithmus. U-Net-Algorithmus, logische Struktur und Code-Ausführungsprozess. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 11: Ablauf von Studien zur Segmentierung von Zungenbildern. Der rote Bereich im Bild ist das Ergebnis der Zungensegmentierung, und der grüne Bereich ist das Ergebnis der Segmentierung des Zungenbelags. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 12: Vergleichstabelle von vier Algorithmusmetriken. MIoU, MPA, Präzision und Rückruf sind allesamt Bewertungsindizes für die Algorithmusleistung. Je größer der Wert, desto besser die Algorithmusleistung und desto höher die Segmentierungsgenauigkeit. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 13: Vergleich der Ergebnisse der vier Algorithmen zur Zungensegmentierung. Der rote Bereich im Bild ist das Ergebnis der Zungensegmentierung, und der grüne Bereich ist das Ergebnis der Segmentierung des Zungenbelags. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Abbildung 14: Strukturdiagramm des U-Net-Algorithmus. Die blau/weißen Kästchen zeigen die Feature-Map an, während die Zahl über der Feature-Map die Anzahl der Kanäle darstellt. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

| MIoU | .MPA | Präzision | Rückruf | |

| U-Netz | 84.00% | 89.38% | 91.90% | 89.38% |

| DeeplabV3 | 59.68% | 61.33% | 84.21% | 61.33% |

| PSPNet | 67.80% | 72.56% | 82.71% | 72.56% |

| SegNet | 80.09% | 87.14% | 88.53% | 87.14% |

Tabelle 1: Vergleich von vier Ergebnismetriken für die Algorithmussegmentierung. Die Metriken waren MIoU, MPA, Präzision und Recall.

Ergänzende Kodierdatei 1: U-Net_training. Trainingscode für das U-Net-Modell. Bitte klicken Sie hier, um diese Datei herunterzuladen.

Ergänzende Kodierungsdatei 2: Seg-Net_training. Seg-Net-Modell-Trainingscode. Bitte klicken Sie hier, um diese Datei herunterzuladen.

Ergänzende Kodierungsdatei 3: DeeplabV3_training. Trainingscode für das DeeplabV3-Modell. Bitte klicken Sie hier, um diese Datei herunterzuladen.

Ergänzende Kodierdatei 4: PSPNet_training. PSPNet-Modell-Trainingscode. Bitte klicken Sie hier, um diese Datei herunterzuladen.

Diskussion

Anhand der oben dargestellten Vergleichsergebnisse wird deutlich, dass die Charakteristika der vier betrachteten Algorithmen unterschiedlich sind und ihre unterschiedlichen Vor- und Nachteile im Folgenden beschrieben werden. Die U-Net-Struktur, die auf der Modifikation und Erweiterung eines vollständigen Faltungsnetzwerks basiert, kann Kontextinformationen und eine präzise Positionierung durch einen kontrahierenden Pfad und einen symmetrischen Expansionspfad erhalten. Durch die Klassifizierung jedes Pixelpunkts erreicht dieser Algorithmus eine höhere Segmentierungsgenauigkeit und segmentiert das Bild mit dem trainierten Modell schneller. Auf der anderen Seite hat der Seg-Net-Algorithmus, der aus einer symmetrischen Struktur aus Encoder und Decoder besteht, den Vorteil, dass er sich schnell an neue Probleme anpasst und bei Aufgaben wie Sprache, Semantik, Sehen und Spielen gut abschneidet. Der Algorithmus benötigt jedoch eine große Menge an Daten, was ihn in Bezug auf die Hardwarekonfiguration anspruchsvoll macht und daher nur für einige Aufgaben anwendbar ist. Als allgemeineres Framework hat der DeeplabV3-Algorithmus den Vorteil, dass ASSP-Module für die meisten Netzwerke verbessert und kaskadiert oder parallel angeordnet werden, um die Gesamtleistung zu verbessern. Die endgültige Merkmalskarte muss jedoch mit Up-Sampling mit den Raten 8 und 16 erstellt werden, was relativ grob ist und später verbessert werden könnte. Darüber hinaus hat das PSPNet-Modell die wichtigste Eigenschaft, Kontextinformationen aus verschiedenen Regionen über das PSP-Modul zu aggregieren, wodurch der Zugang zu globalen Informationen verbessert und gute Ergebnisse für mehrere Datensätze geliefert werden. Die Ergebnisse deuten darauf hin, dass das U-Net-Modell in diesem Forschungsumfeld die höchste Segmentierungsgenauigkeit und den besten Segmentierungseffekt aufweist.

Die U-Net-Architektur demonstriert ihre Überlegenheit bei der Segmentierung medizinischer Bilder12. Ursprünglich für die Segmentierung von 2D-Zellbildern konzipiert, wurde der U-Net-Algorithmus weiterentwickelt, indem sein 2D-Modul durch ein 3D-Modul ersetzt wurde. Diese Modifikation hat die Fähigkeit zur Verarbeitung von 3D-Bildern wie Magnetresonanztomographie (MRT), Computertomographie (CT) und dreidimensionalen (3D) Ultraschallbildern verbessert. Durch die Segmentierung medizinischer Bilder in Organe, Gewebe und Läsionen können wertvolle klinische Daten gewonnen werden. Der verbesserte U-Net-Algorithmus stellt ein effektives Werkzeug für die anschließende Untersuchung und Behandlung dar. In der medizinischen Diagnostik ist die Klassifizierung von Bildern ein entscheidender Bestandteil vieler diagnostischer Verfahren. Die traditionelle Medizin beruht auf der Beobachtung aller sichtbaren Zeichen, einschließlich der Zunge, der Haut und des Ausdrucks. Das Aufkommen und die Weiterentwicklung der medizinischen Bildsegmentierungstechnologie sind in der medizinischen Diagnostik von großer Bedeutung. In der TCM erfordert die Analyse von Gesichts- und Zungenbildern die Verwendung verschiedener Deep-Learning-Algorithmen zur Klassifizierung der Merkmalsextraktion. Auf der anderen Seite sind Bildsegmentierungsalgorithmen in der westlichen Medizin weit verbreitet und bilden eine Grundlage für die klinische Diagnose und Pathologie13.

Der Forschungsprozess dieser Studie umfasst kritische Schritte, darunter die Vorverarbeitung von Daten, das Training und Testen von Algorithmen sowie den Vergleich der Algorithmusleistung. Zunächst werden die Rohdaten verarbeitet, gekennzeichnet und in Trainings- und Testsätze unterteilt, um die anschließende Algorithmuskonstruktion zu erleichtern. Die verarbeiteten Daten werden dann in das neuronale Netz eingespeist, und die Verlustfunktion wird so eingestellt, dass der Gradientenvektor durch Rückpropagation bestimmt wird. Anschließend werden die Parameter bis zum Abschluss des Trainingsprozesses angepasst. Die Leistung des Algorithmus wird bewertet, indem der Bildsegmentierungseffekt mithilfe mehrerer Indizes wie MIoU, MPA, Genauigkeit und Abruf getestet wird, um die Leistung umfassend zu bewerten. Während des eigentlichen Algorithmustrainings kann es zu einer Überanpassung kommen, bei der das Modell die Daten zu gründlich lernt, einschließlich der Eigenschaften der Rauschdaten. Dies führt zu einer Identifizierung von Daten bei späteren Tests, zu einer falschen Klassifizierung der Daten und zu einer schlechten Generalisierungsfähigkeit. Wenn es zu einer Überanpassung kommt, kann man die Trainingsdaten erhöhen oder die Daten neu bereinigen. In dieser Arbeit wird die iterative Methode des Gradientenabstiegs angewendet. Eine Überanpassung kann auch verhindert werden, indem die Iteration im Voraus abgeschnitten wird.

Die Limitation dieser Studie liegt auf der Hand; Die Bilder wurden mit fest installierten Instrumenten aufgenommen, und die experimentellen Instrumente können derzeit nicht für kommerzielle Zwecke verwendet werden. Folglich stammen die Zungenbilder in dieser Studie aus einer einzigen Szene und spiegeln den klinischen Hintergrund und die komplexen und variablen Lichtverhältnisse nicht vollständig wider. Daher ist weitere Forschung erforderlich, um Bildverarbeitungstechniken unter komplexen Umgebungen und schlechten Beleuchtungsbedingungen zu untersuchen. Objektivierungsstudien zur Zungendiagnose enthalten reichhaltige Inhalte, daher ist eine genaue Segmentierung des Zungenkörpers unerlässlich. Folglich ist der Vergleich und die Verifizierung von Algorithmen mit dem am besten geeigneten Segmentierungseffekt für nachfolgende Studien von Bedeutung. Die Kombination von Zungensegmentierung mit Klassifizierung kann theoretisch eine automatische Beurteilung des Zungenbildes erreichen und die Diagnose unterstützen. Wissenschaftler haben dieses Thema erforscht und untersucht. Im Gesundheitswesen kann die Nutzung des Internets der Dinge und drahtloser Kommunikationstechnologien zur Verarbeitung biomedizinischer Bilder sowie zur Unterstützung bei der Diagnose die Effizienz eines Systems steigern. Mansour et al.14 entwarfen ein automatisiertes Zungenfarbbild (ASDL-TCI), das auf kollaborativem Deep Learning und dem Internet der Dinge basiert. Es umfasst die Datenerfassung, Vorverarbeitung, Merkmalsextraktion, Klassifizierung und Parameteroptimierung. Die Präzision, die Abrufrate und die Genauigkeit dieses Modells liegen bei 0,984, 0,973 bzw. 0,983, was anderen Methoden überlegen ist.

Bildaufnahme und Vorverarbeitung

Während des Bildaufnahmeprozesses können sich die Intensität und Vielfalt der Lichtquellen direkt auf die Bildqualität auswirken, was sich wiederum auf die Ergebnisse der Bildsegmentierung und -klassifizierung auswirkt. Daher ist es wichtig, die Lichtquelle so einzustellen, dass sie die Wirkung natürlicher Lichtquellen so genau wie möglich nachahmt. Darüber hinaus können Methoden wie die Verwendung von Standardlichtquellen oder die Verwendung mehrerer Lichtquellen und die Aufnahme in einer festen Szene die negativen Auswirkungen von Licht, Hintergrund und anderen Faktoren verhindern und dadurch die Genauigkeit der algorithmischen Segmentierung verbessern. Die Parameter der Instrumentenbeleuchtung, die zum Erfassen von Zungenbildern verwendet werden, sind nicht identisch mit der Standardbeleuchtung, was sich auf den Farbwiedergabeeffekt von Zungenbildern auswirkt. Daher ist die am häufigsten verwendete Vorverarbeitungsmethode die Farbkorrektur. Cai et al.15 fanden heraus, dass es notwendig ist, die Farbraumkonvertierung und Farbkorrektur des Zungenbildes zu normalisieren, um die Diskrepanz zwischen den Farbdaten eines Zungenbildes und der Farbsättigung der entsprechenden Zunge zu beheben. Auch die Farbleistung des Anzeigegeräts weicht vom realen Zungenkörper ab, so dass ein Testen und Einstellen erforderlich ist. Darüber hinaus variiert die Bildgröße aufgrund unterschiedlicher Erfassungsinstrumente, die während des Bilderfassungsprozesses verwendet werden16. Um die Trainingseffizienz zu verbessern und Speicherplatz zu sparen, hat das Deep-Learning-Netzwerk Einschränkungen bei der Größe des Eingabebildes. Daher muss die Bildgröße während der Bildvorverarbeitung standardisiert werden. In der Regel wird dies durch eine gleichmäßige Umformung der Eingabebildgröße für das Modelltraining erreicht, wobei häufig verwendete Umformungsmethoden Interpolation, Zuschneiden, Einschließen, Kacheln und Spiegeln sind.

Segmentierung von Zungenbildern

Die Segmentierung von Zungenbildern kann in zwei Typen eingeteilt werden: traditionelle und Deep-Learning-Segmentierungsmethoden17. Herkömmliche Methoden zur Segmentierung von Zungenbildern bestehen aus Algorithmen wie dem Snake-Algorithmus und dem Otsu-Algorithmus. Als aktives Konturmodell legt der Snake-Algorithmus18 zuerst eine Profilkurve fest und passt dann das Anfangsprofil an, um sich zu einer echten Profilkurve zu entwickeln. Die Erfassung von Anfangskonturen und die Evolution von Konturen stehen im Vordergrund der Forschung für den Snake-Algorithmus. Auf der anderen Seite ist der Otsu-Algorithmus ein klassischer Schwellenwertsegmentierungsalgorithmus, der einen oder mehrere Schwellenwerte verwendet, um den Grauwert auf dem Originalbild zu berechnen und den Graustufenwert jedes Pixels mit dem Schwellenwert zu vergleichen. Basierend auf den Vergleichsergebnissen werden die Zunge und der Hintergrund vor dem Aufkommen von Deep-Learning-Methoden dargestellt. Diese beiden Algorithmen werden häufig bei der Bildverarbeitung der Zunge und der Objektivierung der Zungendiagnose verwendet.

Seit dem Aufkommen der Deep-Learning-Theorie haben zahlreiche Wissenschaftler die Integration von Zungendiagnose, Objektivierung und Deep Learning erforscht. Zheng et al.19 entwickelten eine Zungenerkennungsmethode, die auf Bildsegmentierung basiert, indem sie verschiedene Algorithmen zusammenführten und die Zungenerkennungsmethode in einer offenen Umgebung untersuchten, um letztendlich günstige Ergebnisse bei der Zungensegmentierung zu erzielen. Yuan et al.20 schlugen eine Methode zur Zungensegmentierung vor, die auf der Einzelpixelverlustfunktion der Regionsassoziation basiert, wobei die verbesserte Verlustfunktion die Korrelation zwischen den Regionspixeln berücksichtigt. Durch den Einsatz von Pixellabel-Semantik und überwachtem Lernen wurde die Effizienz des Modelltrainings verbessert, was durch den MIoU-Index von 96,32 % veranschaulicht wird. Das Zungenbild wies spezifische morphologische Merkmale wie Zahnspuren, Risse und Einstiche auf, die eng mit dem Ausbruch der Krankheit verbunden waren. So kann die Beobachtung der Zunge helfen, den Krankheitsverlauf zu diagnostizieren. Wang et al.21 schlugen einen Deep-Learning-Ansatz zur Segmentierung von Zungenfrakturen für kleine Stichprobendatensätze vor, der zu einer verbesserten Genauigkeit und Stabilität führte. Bei dieser Methode wurde zuerst der Zungenkörper gespalten, gefolgt von Zungenrissen, und der U-Net-Algorithmus wurde verbessert, indem der Fokusverlust als Funktionsverlust berücksichtigt wurde.

Klassifizierung von Zungenbildern

Bei der Klassifizierung von Zungenbildern geht es hauptsächlich um die Identifizierung von Merkmalen wie Zungenfarbe, Stacheln, Rissen und Beschichtungsfarbe. Wang et al.22 verwendeten den Snake-Algorithmus, um den Zungenkörper zu segmentieren, und verwendeten Techniken wie die gegenseitige Informationsbildregistrierung, die Erkennung von Stammkanten, parallele Linien und andere Methoden zur Identifizierung von Einstichen. Dieser Ansatz löste effektiv das Problem der automatischen Erkennung und Zählung von Einstichen und erleichterte gleichzeitig die Früherkennung und -prävention. Um die Einschränkungen zu beheben, die mit dem Training des Zungenbildalgorithmus verbunden sind, wie z. B. ein großes Datenvolumen, eine lange Trainingszeit und hohe Anforderungen an die Ausrüstung, schlugen Yang et al.23ein vollständig vernetztes neuronales Netzwerk vor, das auf Transfer Learning basiert. Bei dieser Methode werden die gut trainierten Inception_v3 verwendet, um Merkmale zu extrahieren und sie mit dem vollständig verbundenen neuronalen Netzwerk (FCN) zu kombinieren, wodurch eine Genauigkeitsrate von über 90 % erreicht wird. Dieser Ansatz löste das Problem des Deep Learning in kleinen Stichproben und mehreren Klassifizierungen. Song et al.24 verwendeten einen Kaskadenklassifikator, um Bilder auf GoogLe-Net und Res-Net für Transferlernen, Training und die Anwendung von Deep Learning zu lokalisieren, um drei Zungenbildmerkmale automatisch zu klassifizieren: Zahnspuren, Risse und Dicke der Zungenbeschichtung. Die durchschnittliche Genauigkeit der Klassifizierungsergebnisse lag bei über 94 %. Der Algorithmus zur Klassifizierung von Zungenbildern ist jedoch sehr anfällig für Interferenzen durch andere, nicht verwandte Teile des Gesichts, was sich direkt auf die Klassifizierungsgenauigkeit auswirkt25.

Zhai et al.26 entwickelten einen mehrstufigen Algorithmus zur Klassifizierung von Zungenbildern mithilfe von Aufmerksamkeitsmechanismen. Diese Methode verbessert die Genauigkeit der Identifizierung von Zungenregionen, indem sie Merkmale aus verschiedenen Wahrnehmungsfeldern extrahiert, die während der Zungenlokalisierungsphase verschmolzen werden. Darüber hinaus verbessert das Aufmerksamkeitsmechanismus-Modul die Genauigkeit der Bildklassifizierung der Zunge, wodurch Störungen durch Zungenverunreinigungen unterdrückt werden. Angesichts des Problems der Klassifizierung von Zungenmerkmalen verschiedener Krankheiten27 können Deep-Learning-Algorithmen auch neue Ansätze bieten. Darüber hinaus haben Shi et al.28 eine typische Klassifikationsmethode für nicht-kleinzelliges Lungenkarzinom untersucht, die auf dem C5.0-Entscheidungsbaumalgorithmus basiert. Sie identifizierten sieben Regeln zur Klassifizierung von Attributen, die für die Klassifizierung des Qi-Mangelzertifikats und des Yin-Mangelzertifikats relevant sind. Die Genauigkeit des Modells lag bei 80,37 %. Darüber hinaus haben Li et al.29 ein diagnostisches Modell für Diabetes entwickelt, das den stochastischen Waldalgorithmus verwendet. Sie analysierten außerdem Textur- und Farbmerkmale von Zungenbildern, um die Leistung des Modells zu verbessern.

Schlussfolgerung

Im Gegensatz zu den heutigen diagnostischen Ansätzen der westlichen Medizin sind die diagnostischen Methoden der TCM minimalinvasiv und verursachen nur minimale Schäden. Darüber hinaus haben die vier diagnostischen Methoden Beobachten, Hören oder Riechen, Untersuchen und Abtasten ihre Grundlage in verschiedenen Aspekten der TCM. Aufgrund der starken Abhängigkeit der TCM-Diagnostik und -Behandlung von der Expertise des Behandlers und persönlichen Behandlungskonzepten kann es jedoch zu einem Mangel an Objektivität und Standardisierung kommen. Infolgedessen hat sich der Trend zur Versachlichung der Diagnostik der TCM als Richtung für weitere Forschungen herauskristallisiert, die die Weiterentwicklung der TCM fördern könnten.

Die Objektivierung der Zungendiagnostik birgt das Potenzial, Bilder und große Datenmengen mit hoher Effizienz zu verarbeiten, was Ärzten erheblich helfen könnte. Es ist jedoch wichtig zu beachten, dass die Zungendiagnose nicht nur eine traditionelle Methode ist, sondern auch validiert wurde. Chen et al.30 führten eine Studie durch, in der sie klinische Daten zu den Zungenbildern von 382 COVID-19-Patienten sammelten. Sie analysierten statistisch die Bildmerkmale der Zunge und die Farbmusterparameter des Labors für alle Bildgruppen. Die Ergebnisse der Studie zeigten eine Korrelation zwischen den Merkmalen von Zungenbildern und der Art der verwendeten westlichen Medizin. Darüber hinaus stimmen die Veränderungen der Zungenbilder mit der allgemeinen Pathogenese der Krankheit überein. Einige Parameter von Zungenbildern könnten möglicherweise bei der Vorhersage pathogener Veränderungen von COVID-19 in TCM31 helfen.

Bei der Objektivierung der traditionellen medizinischen Zungendiagnose haben zahlreiche Forscher die Segmentierungs- und Klassifizierungsmethode verwendet. Deep Learning und Convolution Neural Networks sind für die Klassifizierung von Bildmerkmalen der Zunge unerlässlich. Die Genauigkeit des Algorithmus zur Segmentierung von Zungenbildern ist von entscheidender Bedeutung, da er bestimmt, ob die Zunge präzise vom Gesicht getrennt werden kann, was sich auf die Genauigkeit der nachfolgenden Klassifizierung von Merkmalen auswirkt. Daher ist die Verbesserung der Genauigkeit des aktuellen Algorithmusmodells ein entscheidender Forschungsschwerpunkt in diesem Bereich. Im Moment ist die Verbesserung des Algorithmusmodells und seiner Genauigkeit ein Forschungsschwerpunkt.

In dieser Studie wurden die gleichen Testsatzdaten verwendet, um die Leistung der Algorithmen U-Net, Seg-Net, DeeplabV3 und PSPNet4 zu vergleichen. Diese Maßnahme wurde ergriffen, um die Konsistenz der Qualität der verwendeten Daten zu gewährleisten. In der in dieser Studie verwendeten experimentellen Umgebung übertraf der U-Net-Algorithmus die anderen drei Algorithmen in Bezug auf die Segmentierungsgenauigkeit signifikant. MIoU ist das Annotationsmaß des semantischen Segmentierungsalgorithmus32, dem wichtigsten Index, der zur Bewertung der Algorithmusleistung verwendet wird. Der MIoU-Wert des U-Net-Algorithmus war 3,91 % höher als der des Seg-Net-Algorithmus, 23,32 % höher als der von DeeplabV3 und 16,2 % höher als der von PSPNet. Dies ist ein Beweis dafür, dass der U-Net-Algorithmus besser abschneidet als die anderen Algorithmen.

Es gibt jedoch einige Probleme bei der Segmentierung und Klassifizierung von Zungenbildern mithilfe von Deep-Learning-Algorithmen. Beispielsweise sind medizinische Bilddatensätze aufgrund der Privatsphäre der Patienten im Vergleich zu anderen semantisch segmentierten Datensätzen zu klein, was die Vorteile von Deep Learning in Big Data einschränkt. Die Segmentierung von Modellen mit großen Parametern ist anfällig für das Anpassungsproblem. Daher muss die Netzstruktur durch die Auswahl geeigneter Verbesserungsmodi angepasst werden. Gegenwärtig hat die Objektivierungsforschung der Zungendiagnostik noch keinen einheitlichen Erhebungsstandard gebildet; Die Erfassungsumgebung und der Lichtquellentyp sind nicht ausreichend standardisiert. Die Forschenden richten in der Regel die Sammlungsumgebung ein und bauen ihre eigene nicht-öffentliche Datenbank auf. Obwohl die aktuellen algorithmischen Modelle eine gute Genauigkeit erreichen können, werden die verwendeten Daten sorgfältig gescreent und vorverarbeitet, was in der tatsächlichen Diagnose- und Behandlungsumgebung nur schwer zu erreichen ist, was die klinische Anwendung einschränkt. Darüber hinaus wird sich die weitere Objektivierung der Zungendiagnose mit komplexen Umgebungen oder Zungenbildern befassen, die von verschiedenen Geräten aufgenommen wurden33. Ein weiterer Trend ist die dynamische Informationsverarbeitung, insbesondere die Videobildverarbeitung, die detailliertere Informationen über die Zunge liefert und die Vorteile der Zungendiagnostik umfassender abbildet. Daher ist es notwendig, Deep-Learning-Algorithmen zu entwickeln, um dynamische Details zu verarbeiten. Insgesamt verspricht die Objektivierung der medizinischen Zungendiagnose in Kombination mit Deep-Learning-Algorithmen die Reduzierung der Subjektivität in der TCM-Diagnostik.

Offenlegungen

Die Autoren haben keinen Interessenkonflikt zu erklären.

Danksagungen

Diese Arbeit wurde von der National Nature Foundation of China (Grant Nr. 82004504), dem National Key Research and Development Program des Ministeriums für Wissenschaft und Technologie der China (Grant Nr. 2018YFC1707606), der Chinese Medicine Administration of Sichuan Province (Grant Nr. 2021MS199) und der National Nature Foundation of China (Grant Nr. 82174236) unterstützt.

Materialien

| Name | Company | Catalog Number | Comments |

| CPU | Intel(R) Core(TM) i7-9700K | ||

| GPU | NVIDIA GeForce RTX 3070 Ti (8192MB) | ||

| Operating systems | Microsoft Windows 10 Professional Edition (64-bit) | ||

| Programming language | Python | ||

| RAM | 16G |

Referenzen

- Jiu, G., et al. Effects of herbal therapy on intestinal microbiota and serum metabolomics in different rat models of Mongolian medicine. Evidence-Based Complementary and Alternative. 2022, 7255780 (2022).

- Xi, J., Xin, Y., Teregle, Study on the correlation between the animal model of Mongolian medicine 34;Xieri disease" and serum ALT and AST. Electronic Journal of Cardiovascular Diseases in Combination of Traditional Chinese. 4 (33), 134-135 (2016).

- Yin, L., et al. Study on the mechanism of serum differential protein changes in bronchial asthma based on proteomics. Chinese Journal of Traditional Chinese Medicine. 47 (22), 6227-6234 (2022).

- Wang, X. H., Bao, L. Band Seed. The origin and development of tongue diagnosis in Mongolian medicine. Chinese Ethnic Folk Medicine. (1), 64-65 (2008).

- Yang, S., et al. A comparative study on the feature parameters of tongue diagnosis images in five nationalities. Chinese Journal of Traditional Chinese Medicine. 36 (11), 6428-6430 (2021).

- He, J. Y., et al. Efficacy and safety of Chou-Ling-Dan granules in the treatment of seasonal influenza via combining Western and traditional Chinese medicine, protocol for a multicentre, randomised controlled clinical trial. BMJ Open. 9 (4), e024800 (2019).

- Wang, D. J., et al. Scientific knowledge mapping and visualization analysis in the field of Chinese medicine tongue feature objectification research. World Science and Technology - Modernization of Chinese Medicine. 23 (9), 3032-3040 (2021).

- Yuan, S. M., Qian, P., Li, F. F. Research progress of color correction methods for tongue and face diagnosis in traditional Chinese Medicine. Chinese Journal of Traditional Chinese Medicine. 34 (9), 4183-4185 (2019).

- Kanawong, R., et al. Tongue image analysis and its mobile app development for health diagnosis. Advances in Experimental Medicine and Biology. 1005, 99-121 (2017).

- Yu, Y., et al. Semantic segmentation evaluation index and evaluation method. Computer Engineering and Application. , (2023).

- Sehyung, L., Negishi, M., Urakubo, H., Kasai, H., Ishii, S. Mu-net: Multi-scale U-net for two-photon microscopy image denoising and restoration. Neural Networks. 125, 92-103 (2020).

- Huang, X. M., et al. A review on the application of U-Net and its variants in medical image segmentation. Chinese Journal of Biomedical Engineering. 41 (5), 567-576 (2022).

- Lu, J. H., Xu, Y. F., Wang, Y. Q., Hao, Y. M. Research overview of tongue objectification in traditional Chinese medicine based on computer image technology. World Science and Technology - Modernization of Traditional Chinese Medicine. 24 (11), 4568-4573 (2022).

- Mansour, R. F., Althobaiti, M. M., Ashour, A. A. Internet of things and synergic deep learning based biomedical tongue color image analysis for disease diagnosis and classification. IEEE Access. 9, 94769-94779 (2021).

- Cai, Y. H., Hu, S. B., Guan, J., Zhang, X. F. Analysis of the development and application of tongue diagnosis objectification techniques in Chinese medicine. World Science and Technology - Modernization of Chinese Medicine. 23 (7), 2447-2453 (2021).

- Ghosh, S., Das, N., Nasipuri, M. Reshaping inputs for convolutional neural network: some common and uncommon methods. Pattern Recognition. 93, 79-94 (2019).

- Shang, Z. M., et al. Research progress of digital acquisition and characterization of tongue diagnosis information. Chinese Journal of Traditional Chinese Medicine. 36 (10), 6010-6013 (2021).

- Ning, J., Zhang, D., Wu, C., Yue, F. Automatic tongue image segmentation based on gradient vector flow and region merging. Neural Computing and Applications. 21, 1819-1826 (2012).

- Zheng, F., Huang, X. Y., Wang, B. L., Wang, Y. H. A method for tongue detection based on image segmentation. Journal of Xiamen University. 55 (6), 895-900 (2016).

- Li, Y. T., Luo, Y. S., Zhu, Z. M. Deep learning-based tongue feature analysis. Computer Science. 47 (11), 148-158 (2020).

- Wang, Y. D., Sun, C. H., Cui, J. L., Wu, X. R., Qin, Y. X. Research on deep learning-based tongue fissure segmentation algorithm. World Science and Technology - Modernization of Chinese Medicine. 23 (9), 3065-3073 (2021).

- Wang, X. M., Wang, R. Y., Guo, D., Lu, S. Z., Zhou, P. Research on the identification method of tongue punctures based on auxiliary light source. Journal of Sensing Technology. 29 (10), 1553-1559 (2016).

- Yang, J. D., Zhang, P. A fully connected neural network based on migration learning for tongue image classification. Journal of the Second Military Medical University. 39 (8), 897-902 (2018).

- Song, C., Wang, B., Xu, J. T. Research on tongue feature classification method based on deep migration learning. Computer Engineering and Science. 43 (8), 1488-1496 (2021).

- Ding, H. J., He, J. C. Study on modern techniques and methods of tongue diagnosis. Shi Zhen Chinese Medicine. 21 (5), 1230-1232 (2010).

- Zhai, P. B., et al. A multi-stage tongue image classification algorithm incorporating attention mechanism. Computer Engineering and Design. 42 (6), 1606-1613 (2021).

- Hou, Y. S. A new clustering analysis algorithm based on deep learning. Journal of Xinxiang University. 35 (12), 4 (2018).

- Shi, Y. L., et al. A decision tree algorithm for classification of non-small cell lung cancer evidence based on tongue and pulse data. World Science and Technology - Modernization of Chinese Medicine. 24 (7), 2766-2775 (2022).

- Li, J., Hu, X. J., Zhou, C. L., Xu, J. T. Study on the feature analysis and diagnosis model of diabetic tongue based on random forest algorithm. Chinese Journal of Traditional Chinese Medicine. 37 (3), 1639-1643 (2022).

- Chen, C. H., et al. The characteristics of the combination of the four diagnostic methods of traditional Chinese medicine from the perspective of the differences between Chinese and Western medical diagnosis methods. Journal of Guangzhou University of Traditional Chinese Medicine. 28 (3), 332-334 (2011).

- Chen, R., et al. Correlation analysis of tongue image and western medicine typing in 382 patients with novel coronavirus pneumonia based on Lab colour model and imaging histology. Chinese Journal of Traditional Chinese Medicine. 36 (12), 7010-7014 (2021).

- Ju, J. W., Jung, H., Lee, Y. J., Mun, S. W., Lee, J. H. Semantic segmentation dataset for AI-based quantification of clean mucosa in capsule endoscopy. Medicina. 58 (3), 397 (2022).

- Wu, X., et al. A review of research on deep learning in tongue image classification. Computer Science and Exploration. , 1-23 (2022).

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenThis article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten